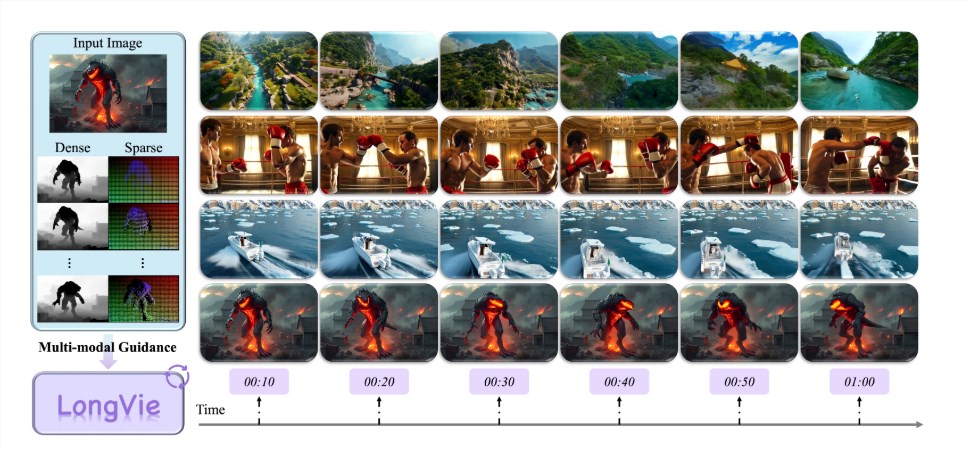

在過去的兩年中,視頻生成技術經歷了驚人的進步,尤其是短視頻的創作。然而,製作超過一分鐘的高質量、風格統一的超長視頻仍然是一項巨大的挑戰。對此,上海人工智能實驗室聯合南京大學、復旦大學、南洋理工大學 S-Lab 以及英偉達等機構,共同推出了 LongVie 框架,系統性解決了這一領域中的核心問題。

LongVie 的目標是讓超長視頻的生成變得更加可控和一致。團隊發現,傳統的視頻生成模型在處理長視頻時,常常面臨時序不一致和視覺退化等難題。前者主要表現爲畫面細節與內容不連貫,後者則指隨着視頻時長的增加,畫面顏色和清晰度的下降。

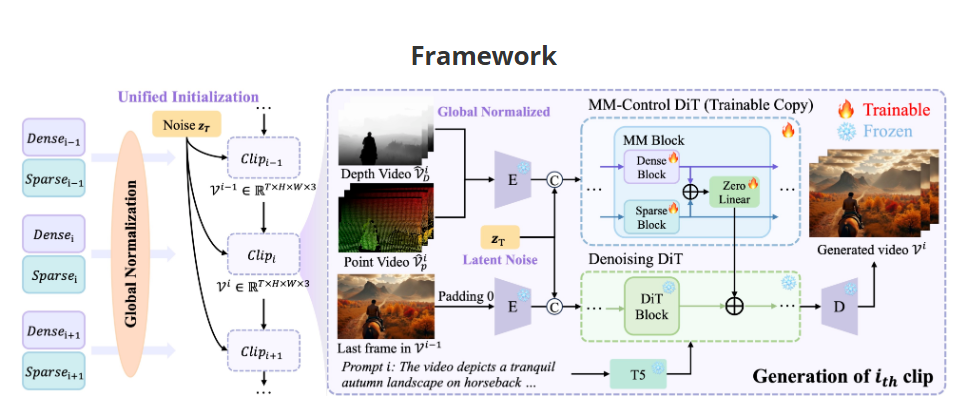

爲了解決這些問題,LongVie 從 “控制信號” 和 “初始噪聲” 兩個方面入手。首先,團隊提出了 “控制信號全局歸一化” 策略,這意味着在生成視頻時,不再只在單一片段內進行歸一化,而是統一整個視頻段的控制信號,從而提升跨片段的連貫性。其次,他們引入了 “統一噪聲初始化” 策略,確保各個片段共享同一初始噪聲,這樣可以從源頭上減少不同片段之間的視覺漂移。

在解決視覺退化問題上,LongVie 採用了多模態精細控制方法。單一模態的控制常常無法提供穩定的約束,而 LongVie 結合了密集控制信號(如深度圖)和稀疏控制信號(如關鍵點),並引入退化感知訓練策略,使得模型在處理長視頻時,能夠保持更高的畫質和細節。

此外,LongVie 還推出了 LongVGenBench,這是首個專爲可控超長視頻生成設計的基準數據集,包含100個超過1分鐘的高分辨率視頻,旨在推動該領域的研究與評測。根據定量指標和用戶評測結果,LongVie 在多個評估上超越了現有技術,贏得了用戶的高度偏好,達到了 SOTA(最先進技術)水平。

隨着 LongVie 框架的問世,超長視頻生成將迎來新的時代,創作者們將能夠在更大的自由度下實現自己的創意。

項目地址:https://vchitect.github.io/LongVie-project/