近日,Nvidia 推出了一款新的小型語言模型 Nemotron-Nano-9B-v2,這款模型在多個基準測試中表現優異,並且用戶可以靈活控制其推理功能的開關。Nemotron-Nano-9B-v2的參數量爲90億,相較於其前身的120億參數有了顯著減小,旨在適應單個 Nvidia A10GPU 的部署需求。

Nvidia 的 AI 模型後訓練總監 Oleksii Kuchiaev 表示,這款模型專門針對 A10GPU 進行了優化,可以實現高達6倍的處理速度,適合各種應用場景。Nemotron-Nano-9B-v2支持多種語言,包括英語、德語、西班牙語、法語、意大利語、日語,以及擴展的韓語、葡萄牙語、俄語和中文等,適用於指令跟隨和代碼生成任務。

該模型基於 Nemotron-H 系列,融合了 Mamba 與 Transformer 架構,能夠在處理長序列時降低內存和計算需求。與傳統的 Transformer 模型不同,Nemotron-H 模型使用選擇性狀態空間模型(SSM),在確保準確性的同時,能夠高效處理更長的信息序列。

在推理功能上,Nemotron-Nano-9B-v2可以默認生成推理過程的跟蹤記錄,用戶也可以通過簡單的控制指令,如 /think 或 /no_think,來切換這一功能。此外,模型引入了運行時 “思考預算” 管理,允許開發者設定推理所用的最大 token 數量,以便在準確性和響應速度之間取得平衡。

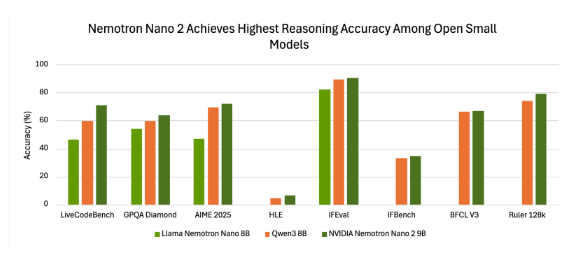

在基準測試中,Nemotron-Nano-9B-v2展現了良好的準確性。例如,在使用 NeMo-Skills 套件的 “推理開啓” 模式下,該模型在多個測試中均表現出色,顯示出與其他小型開源模型相比的優勢。

Nvidia 將 Nemotron-Nano-9B-v2以開放模型許可證發佈,允許商業用途,且開發者可自由創建和分發衍生模型。值得一提的是,Nvidia 不會對模型生成的輸出主張所有權,用戶可完全控制其使用。

該模型的發佈旨在爲開發者提供在小規模環境中平衡推理能力和部署效率的工具,標誌着 Nvidia 在提高語言模型的效率和可控推理能力方面的持續努力。

huggingface:https://huggingface.co/nvidia/NVIDIA-Nemotron-Nano-9B-v2

劃重點:

🌟 Nvidia 推出了新型小型語言模型 Nemotron-Nano-9B-v2,支持用戶靈活控制推理功能。

⚙️ 該模型基於先進的混合架構,能夠高效處理長序列信息,適用於多語言任務。

📊 Nemotron-Nano-9B-v2以開放模型許可證發佈,允許開發者進行商業用途和衍生模型的創建。