最近、Nvidiaは新しい小型言語モデルであるNemotron-Nano-9B-v2をリリースしました。このモデルは複数のベンチマークテストで優れた性能を発揮し、ユーザーが推論機能のオン/オフを柔軟に制御できます。Nemotron-Nano-9B-v2のパラメータ数は90億で、前バージョンの120億パラメータよりも大幅に減少しており、単一のNvidia A10GPUでの導入を目的としています。

NvidiaのAIモデル後学習責任者Oleksii Kuchiaev氏は、このモデルがA10GPUに特化して最適化されており、処理速度が最大6倍に向上していると述べています。これはさまざまな応用シナリオに適しています。Nemotron-Nano-9B-v2は英語、ドイツ語、スペイン語、フランス語、イタリア語、日本語、および拡張された韓国語、ポルトガル語、ロシア語、中国語など多言語をサポートしており、指示の追従やコード生成のタスクに適しています。

このモデルはNemotron-Hシリーズに基づいており、MambaとTransformerアーキテクチャを統合しており、長文処理においてメモリと計算要件を低下させます。伝統的なTransformerモデルとは異なり、Nemotron-Hモデルは選択的状態空間モデル(SSM)を使用しており、精度を保ちながらより長い情報シーケンスを効率的に処理できます。

推論機能に関して、Nemotron-Nano-9B-v2はデフォルトで推論プロセスのトラッキング記録を生成できます。ユーザーは、/thinkまたは/no_thinkなどの簡単なコントロール命令を通じて、この機能を切り替えることも可能です。さらに、モデルには実行時「思考予算」管理が導入され、開発者は推論に使用する最大トークン数を設定できるため、正確性と応答速度のバランスを取りやすくなっています。

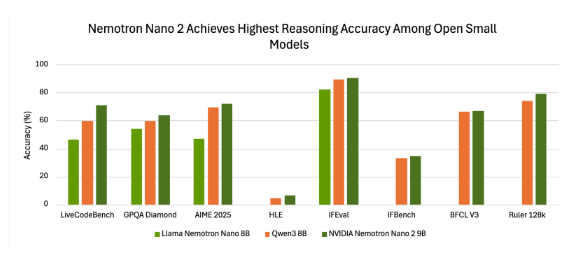

ベンチマークテストでは、Nemotron-Nano-9B-v2は良好な正確性を示しました。たとえば、NeMo-Skillsキットの「推論ON」モードで動作させた場合、多くのテストで優れた結果を収め、他の小さなオープンソースモデルと比較して優位性を示しました。

NvidiaはNemotron-Nano-9B-v2をオープンモデルライセンスで公開しており、商業用途が許可されており、開発者は派生モデルの作成と配布を自由に行えます。また、Nvidiaはモデルが出力した内容に対して所有権を主張せず、ユーザーは完全にその使用を制御できます。

このモデルのリリースは、開発者に小規模な環境で推論能力と展開効率のバランスを取るためのツールを提供することを目的としており、Nvidiaが言語モデルの効率性と制御可能な推論能力を向上させるための継続的な努力を示しています。

huggingface:https://huggingface.co/nvidia/NVIDIA-Nemotron-Nano-9B-v2

ポイント:

🌟 Nvidiaは新しい小型言語モデルNemotron-Nano-9B-v2をリリースし、ユーザーが推論機能を柔軟に制御できます。

⚙️ このモデルは先進的なハイブリッドアーキテクチャを基盤としており、長文情報を効率的に処理でき、多言語タスクに適しています。

📊 Nemotron-Nano-9B-v2はオープンモデルライセンスで公開されており、開発者が商業用途や派生モデルの作成が可能です。