智譜宣佈推出並開源了全球100B級效果最佳的開源視覺推理模型GLM-4.5V,這是該公司在通向通用人工智能(AGI)道路上的又一重要探索性成果。該模型在魔搭社區與Hugging Face上同步開源,其總參數達到106B,激活參數爲12B,標誌着多模態推理技術的新里程碑。

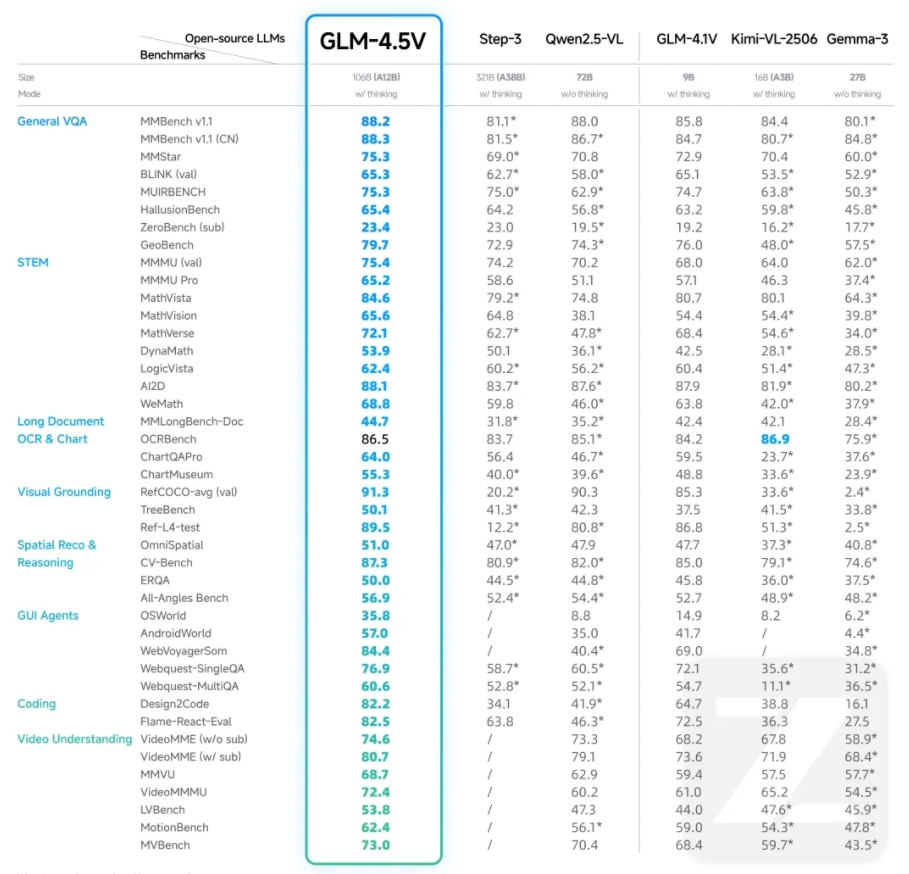

GLM-4.5V基於智譜新一代旗艦文本基座模型GLM-4.5-Air,延續了GLM-4.1V-Thinking的技術路線。在41個公開視覺多模態榜單中,GLM-4.5V的綜合效果達到了同級別開源模型的最高性能(SOTA),涵蓋了圖像、視頻、文檔理解以及GUI Agent等常見任務。該模型不僅在多模態榜單上表現出色,更在真實場景下的表現與可用性方面得到了重視。

GLM-4.5V通過高效混合訓練,具備了覆蓋不同種視覺內容的處理能力,實現全場景視覺推理,包括圖像推理、視頻理解、GUI任務、複雜圖表與長文檔解析以及Grounding能力。模型新增的“思考模式”開關,允許用戶靈活選擇快速響應或深度推理,平衡效率與效果。

爲了幫助開發者直觀體驗GLM-4.5V的模型能力,智譜清言同步開源了一款桌面助手應用,該應用可實時截屏、錄屏獲取屏幕信息,並依託GLM-4.5V處理多種視覺推理任務,如代碼輔助、視頻內容分析、遊戲解答、文檔解讀等多類視覺任務,成爲一個能看着屏幕和你一起工作娛樂的夥伴。

GLM-4.5V的API現已上線智譜開放平臺BigModel.cn,爲所有新老用戶準備了2000萬Tokens的免費資源包。該模型在保持高精度的同時,兼顧推理速度與部署成本,爲企業與開發者提供高性價比的多模態AI解決方案。API調用價格低至輸入2元/M tokens,輸出6元/M tokens,響應速度達到60-80tokens/s。

此外,GLM-4.5V在視覺定位、前端復刻、圖像識別與推理、複雜文檔深度解讀以及GUI Agent能力等方面展現了強大的性能。例如,它能夠精準識別和定位目標物體,復刻網頁,通過圖像中的細微線索推理出背景信息,閱讀並解讀長達數十頁的複雜長文本,以及在GUI環境中進行對話問答、圖標定位等任務。

GLM-4.5V的技術細節包括視覺編碼器、MLP適配器和語言解碼器三部分組成,支持64K多模態長上下文,支持圖像與視頻輸入,並通過三維卷積提升視頻處理效率。模型採用雙三次插值機制,有效增強了對高分辨率及極端寬高比圖像的處理能力與穩健性;同時,引入三維旋轉位置編碼(3D-RoPE),顯著強化了對多模態信息的三維空間關係的感知與推理能力。

GitHub:https://github.com/zai-org/GLM-V

Hugging Face:https://huggingface.co/collections/zai-org/glm-45v-68999032ddf8ecf7dcdbc102

魔搭社區:https://modelscope.cn/collections/GLM-45V-8b471c8f97154e