智譜は、世界で最も効果的なオープンソースの視覚推論モデルGLM-4.5Vをリリースし、オープンソース化しました。これは、同社が汎用人工知能(AGI)への道のりにおいて新たな重要な探求的成果です。このモデルは、魔搭コミュニティとHugging Faceで同時にオープンソース化され、総パラメータ数は106B、アクティブパラメータ数は12Bであり、マルチモーダル推論技術の新しいマイルストーンを示しています。

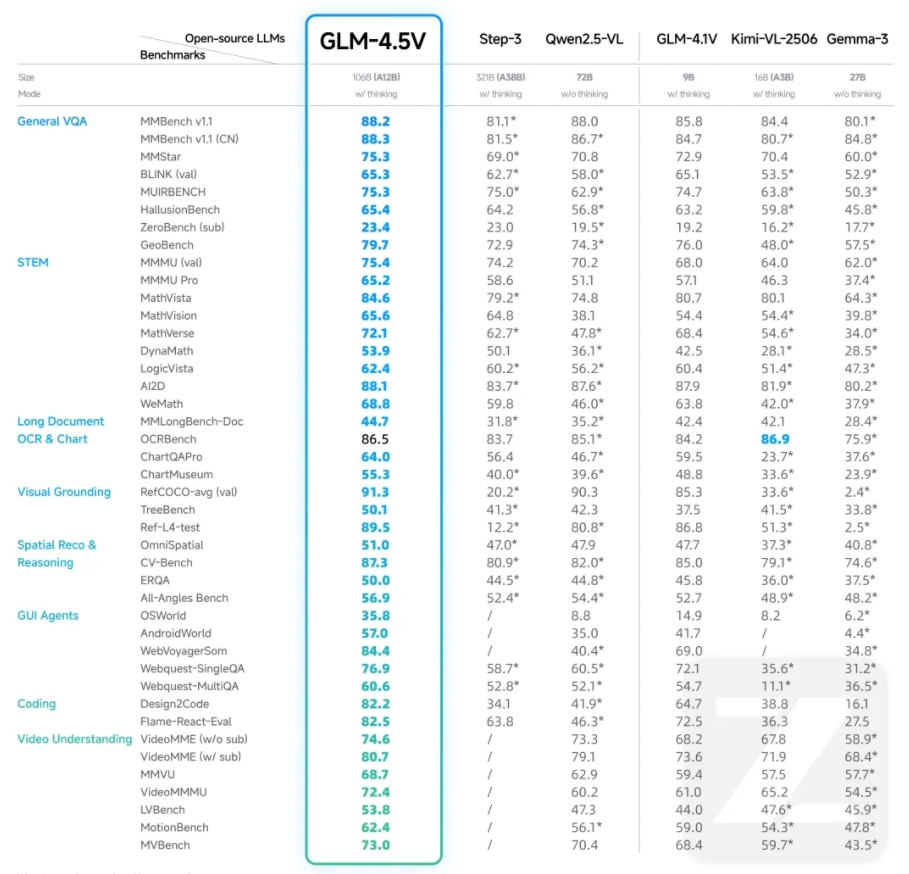

GLM-4.5Vは、智譜の新世代旗艦テキストベースモデルGLM-4.5-Airを基盤としており、GLM-4.1V-Thinkingの技術的アプローチを引き継いでいます。41の公開されたビジュアルマルチモーダルランキングにおいて、GLM-4.5Vの全体的な性能は同レベルのオープンソースモデルの中で最高(SOTA)となり、画像、動画、ドキュメントの理解、GUIエージェントなどの一般的なタスクをカバーしています。このモデルはマルチモーダルランキングでの優れた性能だけでなく、現実的なシナリオでの性能と利用可能性にも注目されています。

GLM-4.5Vは、効率的なハイブリッドトレーニングにより、さまざまな種類のビジュアルコンテンツの処理能力を備え、すべてのシーンでのビジュアル推論を実現しており、画像推論、動画理解、GUIタスク、複雑なチャートと長文ドキュメントの解析、およびグラウンディング機能を含みます。モデルに追加された「思考モード」スイッチにより、ユーザーは迅速な応答または深い推論を選択でき、効率と効果のバランスを取ることができます。

開発者がGLM-4.5Vのモデル能力を直感的に体験できるようにするために、智譜清言は同時にオープンソース化されたデスクトップアシスタントアプリをリリースしました。このアプリは、スクリーンショットや録画を通じて画面情報をリアルタイムで取得し、GLM-4.5Vを使ってコード補助、動画内容分析、ゲームの解答、ドキュメントの解釈などの多様なビジュアル推論タスクを処理します。これにより、画面を見て一緒に作業や娯楽を楽しめるパートナーとなります。

GLM-4.5VのAPIは現在、智譜オープンプラットフォームBigModel.cnで利用可能です。新規および既存のすべてのユーザーに対して、2000万トークンの無料リソースパッケージが用意されています。このモデルは高精度を維持しながらも、推論速度と導入コストを考慮し、企業や開発者に高コストパフォーマンスのマルチモーダルAIソリューションを提供します。API呼び出しの料金は、入力が2元/Mトークン、出力が6元/Mトークンで、応答速度は60〜80トークン/sです。

また、GLM-4.5Vは視覚的位置決め、フロントエンドの復刻、画像認識および推論、複雑なドキュメントの深層解釈、GUIエージェントの能力などにおいて強力な性能を示しています。例えば、目標物体の正確な識別と位置決め、ウェブページの復刻、画像中の微細な手がかりから背景情報を推論すること、数十ページにわたる複雑な長文を読み取り解釈すること、GUI環境での対話質問、アイコンの位置決めなどのタスクを行うことができます。

GLM-4.5Vの技術的な詳細は、視覚エンコーダー、MLPアダプター、および言語デコーダーの3つの部分から構成されており、64Kのマルチモーダル長文脈をサポートし、画像と動画の入力をサポートしています。3次元畳み込みを活用して動画処理効率を向上させています。モデルは、三重補間機構を採用しており、高解像度や極端な縦横比の画像の処理能力と信頼性を効果的に強化しています。さらに、三次元回転位置符号化(3D-RoPE)を導入することで、マルチモーダル情報の三次元空間関係に対する認識と推論能力を顕著に強化しています。

GitHub:https://github.com/zai-org/GLM-V

Hugging Face:https://huggingface.co/collections/zai-org/glm-45v-68999032ddf8ecf7dcdbc102

魔搭コミュニティ:https://modelscope.cn/collections/GLM-45V-8b471c8f97154e