阿里巴巴今晚正式開源視頻生成模型"通義萬相Wan2.2",此次發佈包含三款核心模型:文生視頻(Wan2.2-T2V-A14B)、圖生視頻(Wan2.2-I2V-A14B)和統一視頻生成(Wan2.2-IT2V-5B)模型,標誌着視頻生成技術迎來重大突破。

業界首創MoE架構,計算效率提升50%

通義萬相2.2率先在視頻生成擴散模型中引入MoE(Mixture of Experts)架構,有效解決了視頻生成處理Token過長導致的計算資源消耗過大問題。其中文生視頻和圖生視頻模型總參數量達27B,激活參數14B,均爲業界首個使用MoE架構的視頻生成模型。

該架構由高噪聲專家模型和低噪專家模型組成,分別負責視頻的整體佈局和細節完善。在同參數規模下,可節省約50%的計算資源消耗,同時在複雜運動生成、人物交互、美學表達等維度上實現顯著提升。

首創電影美學控制系統

Wan2.2的一大亮點是首創的"電影美學控制系統",在光影、色彩、構圖、微表情等方面達到專業電影水平。用戶通過輸入"黃昏"、"柔光"、"邊緣光"、"暖色調"、"中心構圖"等關鍵詞,模型可自動生成金色落日餘暉的浪漫畫面;而使用"冷色調"、"硬光"、"平衡圖"、"低角度"的組合,則能生成接近科幻片的畫面效果。

消費級顯卡即可部署的5B統一模型

通義萬相還開源了一款5B小尺寸的統一視頻生成模型,單一模型同時支持文生視頻和圖生視頻功能。該模型採用高壓縮率3D VAE架構,時間與空間壓縮比達到4×16×16,信息壓縮率提升至64,均實現開源模型的最高水平。

該模型僅需22G顯存(單張消費級顯卡)即可在數分鐘內生成5秒高清視頻,是目前24幀每秒、720P像素級生成速度最快的基礎模型,大幅降低了AI視頻生成的技術門檻。

多渠道開放使用

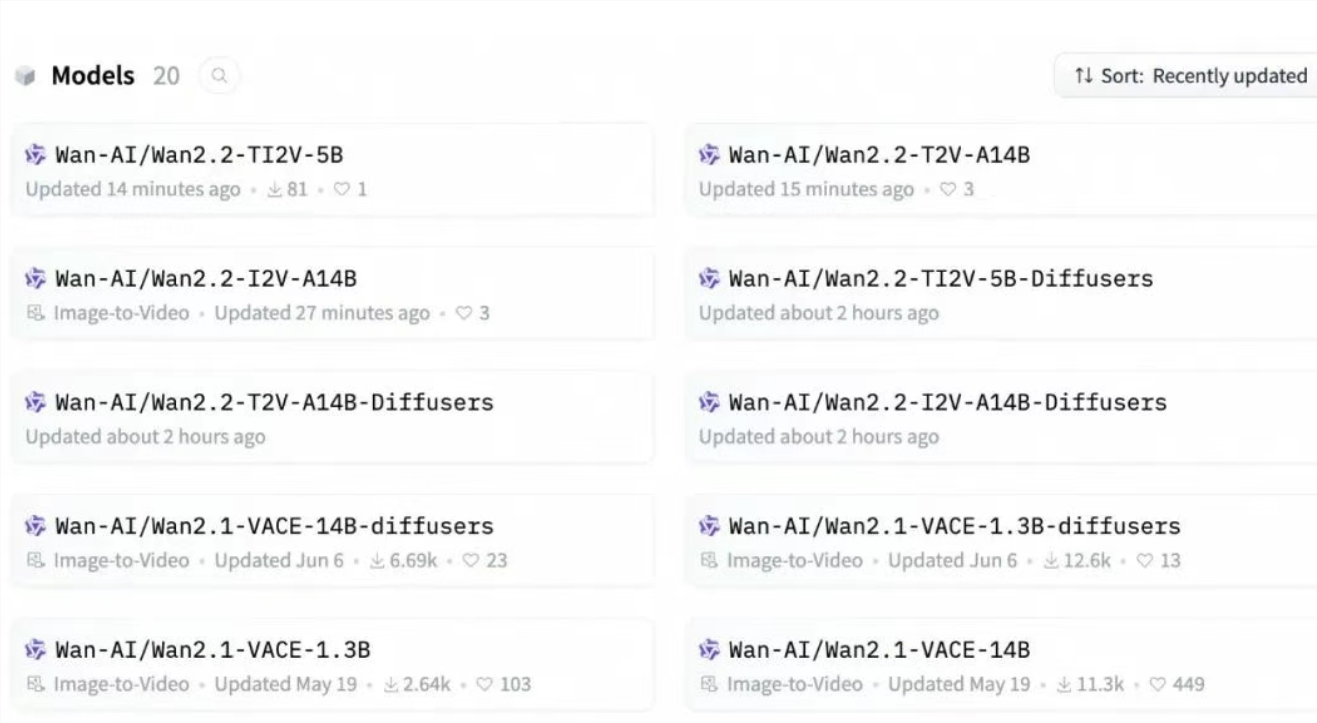

開發者可在GitHub、HuggingFace、魔搭社區下載模型和代碼,企業可通過阿里雲百鍊調用模型API,普通用戶還可在通義萬相官網和通義APP直接體驗。

自今年2月以來,通義萬相已連續開源文生視頻、圖生視頻、首尾幀生視頻和全能編輯等多款模型,在開源社區的下載量已超500萬次,爲AI視頻生成技術的普及和發展做出重要貢獻。

開源地址:

GitHub:https://github.com/Wan-Video/Wan2.2

HuggingFace:https://huggingface.co/Wan-AI

魔搭社區:https://modelscope.cn/organization/Wan-AI