アリババは今夜、動画生成モデル「Tongyi Wanxiang Wan2.2」を正式にオープンソース化しました。今回のリリースには3つのコアモデルが含まれています: テキストから動画を生成する「Wan2.2-T2V-A14B」、画像から動画を生成する「Wan2.2-I2V-A14B」、そして統一的な動画生成を行う「Wan2.2-IT2V-5B」モデルで、動画生成技術に大きな飛躍をもたらしました。

業界初のMoEアーキテクチャ、計算効率が50%向上

Tongyi Wanxiang 2.2は、動画生成の拡散モデルにおいて初めてMoE(Mixture of Experts)アーキテクチャを導入し、動画生成処理におけるトークンの長さによる計算リソースの過剰な消費問題を効果的に解決しました。そのうち、テキストから動画を生成するモデルと画像から動画を生成するモデルの合計パラメータ数は27Bで、アクティブパラメータは14Bであり、いずれも業界で初めてMoEアーキテクチャを採用した動画生成モデルです。

このアーキテクチャは、高ノイズ専門モデルと低ノイズ専門モデルから構成されており、それぞれ動画全体のレイアウトと細部の完成を担当します。同じパラメータ規模下では、約50%の計算リソースを節約でき、複雑な運動生成、人物間のインタラクション、芸術表現などの面で顕著な向上を実現しています。

映画美学制御システムの最初の試み

Wan2.2の大きな特徴の一つは、「映画美学制御システム」の最初の導入です。光と影、色彩、構図、微表情などにおいてプロの映画レベルに達しています。ユーザーは「黄昏」「柔光」「エッジライト」「暖色調」「中心構図」などのキーワードを入力することで、金色の夕暮れのロマンチックなシーンを自動生成できます。一方、「冷色調」「ハードライト」「バランス構図」「低い角度」の組み合わせを使うことで、SF映画のような画面効果を生成することができます。

5Bの統一モデルでコンsumer級グラフィックカードでも運用可能

Tongyi Wanxiangはまた、5Bの小サイズの統一動画生成モデルをオープンソース化しました。このモデルは、単一のモデルでテキストから動画を生成することと画像から動画を生成することの両方に対応しています。このモデルは、高い圧縮率を持つ3D VAEアーキテクチャを使用しており、時間と空間の圧縮比は4×16×16で、情報圧縮率は64に達し、ともにオープンソースモデルの中でも最高水準です。

このモデルは、単一のコンシューマー向けグラフィックカードで22GBのVRAMがあれば、数分で5秒間のハイビジョン動画を生成できます。これは現在、24フレーム毎秒、720Pピクセルレベルでの生成速度が最も速いベースモデルであり、AI動画生成の技術的ハードルを大幅に下げました。

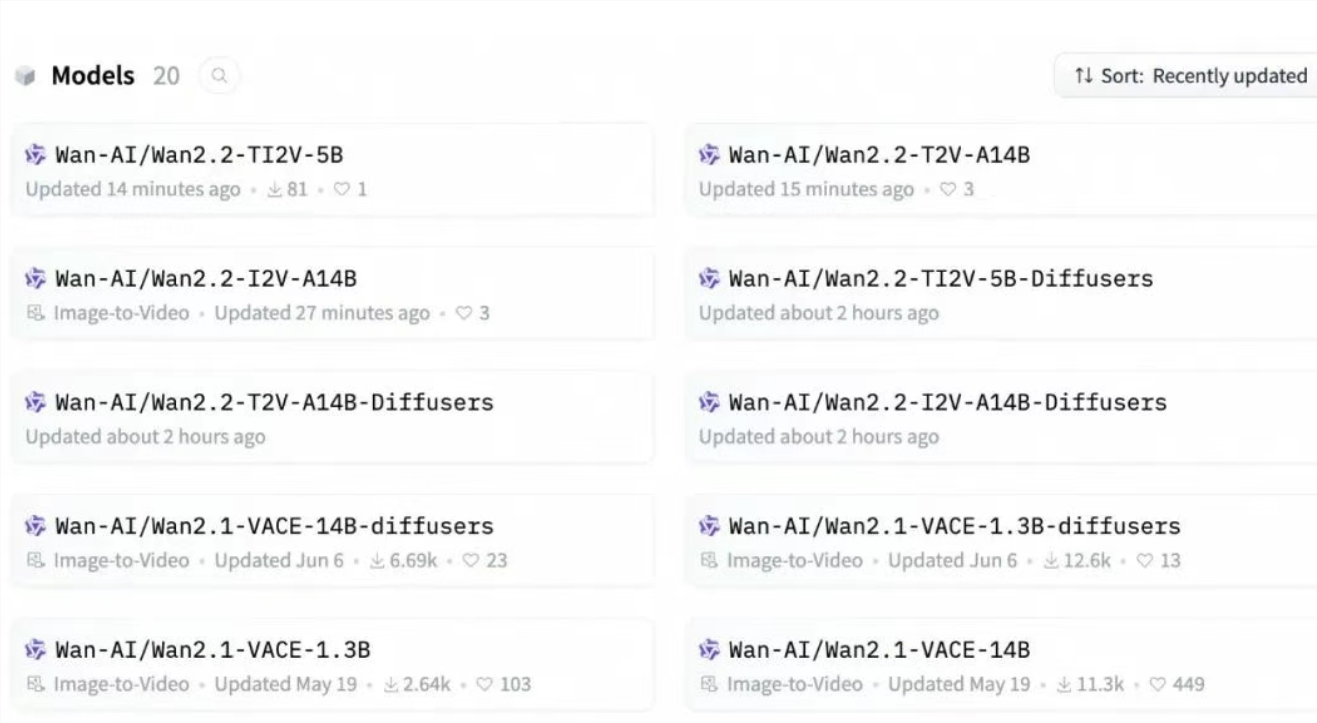

多様なチャネルで公開

開発者はGitHub、HuggingFace、魔搭コミュニティからモデルとコードをダウンロードできます。企業はアリババ雲の百煉を通じてモデルAPIを呼び出すことができます。一般ユーザーは通義万相公式サイトや通義アプリで直接体験できます。