在多模態嵌入學習領域,研究人員們不斷努力將不同的數據形式連接在一起,以便更好地理解和處理多樣化的信息。近期,由 Salesforce Research、加州大學聖巴巴拉分校、滑鐵盧大學及清華大學的研究團隊共同提出了 VLM2Vec-V2,這是一種全新的多模態嵌入學習框架,旨在統一圖像、視頻和視覺文檔的檢索任務。

現有的多模態嵌入模型通常訓練於特定的數據集,如 MMEB 和 M-BEIR,主要集中在自然圖像和照片上。這些數據集大多來自 MSCOCO、Flickr 和 ImageNet,未能涵蓋更廣泛的視覺信息類型,例如文檔、PDF、網站、視頻和幻燈片。這種侷限性導致現有的嵌入模型在實際任務中的表現不盡人意,比如文章搜索、網站搜索以及 YouTube 視頻搜索。

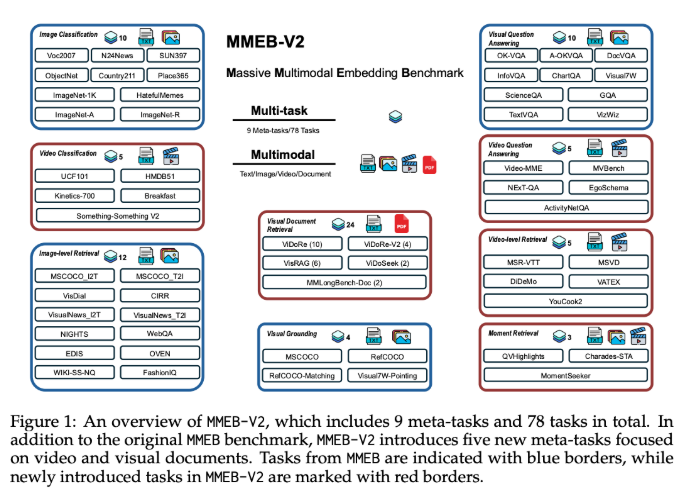

VLM2Vec-V2的推出,首先擴展了 MMEB 數據集,新增了五種任務類型,包括視覺文檔檢索、視頻檢索、時間定位、視頻分類和視頻問答。這一擴展爲多模態學習提供了更豐富的評估標準。此外,VLM2Vec-V2作爲通用的嵌入模型,支持多種輸入形式,在新任務和傳統圖像基準測試上都表現出色,爲研究和實際應用奠定了更靈活和可擴展的基礎。

VLM2Vec-V2採用了 Qwen2-VL 作爲其核心架構,後者在多模態處理方面具有獨特的優勢。Qwen2-VL 具備三大關鍵特性,分別是簡單動態分辨率、多模態旋轉位置嵌入(M-RoPE)以及結合二維和三維卷積的統一框架。爲了實現跨多種數據源的有效多任務訓練,VLM2Vec-V2還引入了一種靈活的數據採樣管道,利用預設的採樣權重表和交錯的子批處理策略來提升對比學習的穩定性。

在綜合78個數據集的評估中,VLM2Vec-V2以58.0的最高平均得分領先於多個強基線模型,並在圖像任務和視頻任務上展現出優異的表現。儘管在視覺文檔檢索方面略遜於 ColPali 模型,VLM2Vec-V2在多模態學習的統一框架上爲未來的研究指明瞭方向。

項目:https://github.com/TIGER-AI-Lab/VLM2Vec

huggingface:https://huggingface.co/VLM2Vec/VLM2Vec-V2.0

劃重點:

📊 VLM2Vec-V2是一個新推出的多模態嵌入學習框架,能夠統一圖像、視頻和視覺文檔的檢索任務。

📝 新模型的評估數據集 MMEB-V2增加了多種任務類型,提升了多模態學習的豐富性和準確性。

🚀 VLM2Vec-V2在多個任務中表現優異,成爲了多模態學習領域的重要基準模型。