マルチモーダル埋め込み学習の分野では、研究者たちはさまざまなデータ形式を結びつけることを常に試みており、多様な情報の理解と処理をよりよくするための努力を続けています。最近、Salesforce Research、カリフォルニア大学サンタバーバラ校、ウィローコン大学、清华大学の研究チームが共同でVLM2Vec-V2を発表しました。これは、画像、動画、ビジュアルドキュメントの検索タスクを統一するための新しいマルチモーダル埋め込み学習フレームワークです。

現在利用されているマルチモーダル埋め込みモデルは通常、特定のデータセット(例:MMEBやM-BEIR)に訓練されており、自然な画像や写真に焦点を当てています。これらのデータセットは主にMSCOCO、Flickr、ImageNetから構成されており、ドキュメント、PDF、ウェブサイト、動画、スライドなど、より広範囲な視覚情報タイプをカバーしていません。この制限により、現存する埋め込みモデルは実際のタスクにおいて満足のいく性能を示すことができず、例えば記事検索、ウェブサイト検索、YouTube動画検索などの場面で問題があります。

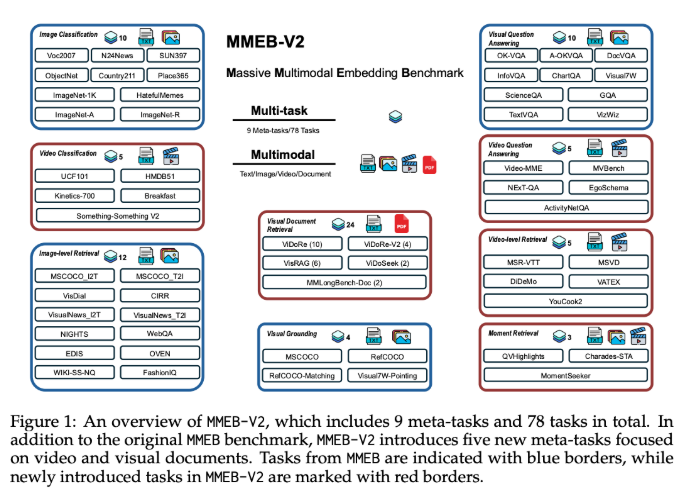

VLM2Vec-V2の登場により、MMEBデータセットは五つの新しいタスクタイプを追加し、ビジュアルドキュメント検索、動画検索、時間定位、動画分類、動画質問応答が含まれます。この拡張により、マルチモーダル学習にはより豊富な評価基準が提供されます。さらに、VLM2Vec-V2は汎用的な埋め込みモデルであり、さまざまな入力形式をサポートし、新規タスクおよび従来の画像ベンチマークテストで優れたパフォーマンスを示しており、研究および実際の応用に対してより柔軟かつ拡張可能な基盤を築いています。

VLM2Vec-V2はQwen2-VLをそのコアアーキテクチャとして採用しています。これはマルチモーダル処理において特異な利点を持っています。Qwen2-VLには3つの重要な特性があり、それはシンプルなダイナミック解像度、マルチモーダル回転位置埋め込み(M-RoPE)、そして二次元と三次元畳み込みを組み合わせた統一フレームワークです。複数のデータソース間での効果的なマルチタスクトレーニングを実現するために、VLM2Vec-V2は柔軟なデータサンプリングパイプラインを導入し、事前に設定されたサンプリング重み表と交差するサブバッチ戦略を利用して、比較学習の安定性を向上させています。

78個のデータセットを総合的に評価した結果、VLM2Vec-V2は最高の平均得点58.0を記録し、多くの強力なベースラインモデルを上回りました。また、画像タスクと動画タスクにおいて優れたパフォーマンスを示しました。視覚ドキュメント検索ではColPaliモデルに少し劣るものの、VLM2Vec-V2はマルチモーダル学習の統一フレームワークにおいて未来の研究への道を示しています。

プロジェクト:https://github.com/TIGER-AI-Lab/VLM2Vec

huggingface:https://huggingface.co/VLM2Vec/VLM2Vec-V2.0

ポイント:

📊 VLM2Vec-V2は、画像、動画、ビジュアルドキュメントの検索タスクを統一する新しいマルチモーダル埋め込み学習フレームワークです。

📝 新しいモデルの評価データセットMMEB-V2は、多くのタスクタイプを追加し、マルチモーダル学習の豊かさと正確さを高めました。

🚀 VLM2Vec-V2は多くのタスクで優れたパフォーマンスを示し、マルチモーダル学習の分野における重要なベースラインモデルとなりました。