隨着 AI 技術的迅猛發展,視頻生成的質量正以驚人的速度提升,從最初模糊不清的片段發展到如今極具真實感的生成視頻。然而,在這一進程中,缺乏對生成視頻的控制和編輯能力,仍然是一個亟待解決的關鍵問題。直到 NVIDIA 及其合作伙伴在最新研究中推出的 DiffusionRenderer,才爲這一難題帶來了新的解決方案。

DiffusionRenderer 是一項開創性的研究成果,它不僅可以生成視頻,還能對視頻中的3D 場景進行理解和操作。這一模型將生成與編輯有機結合,極大地解鎖了 AI 驅動內容創作的潛力。以往的技術,如物理基礎渲染(PBR),在生成高真實感視頻方面表現出色,但對於場景的編輯卻束手無策。DiffusionRenderer 通過獨特的方式處理3D 場景,突破了這一侷限。

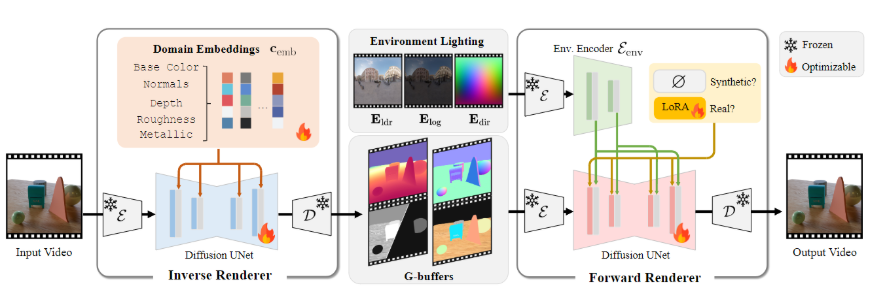

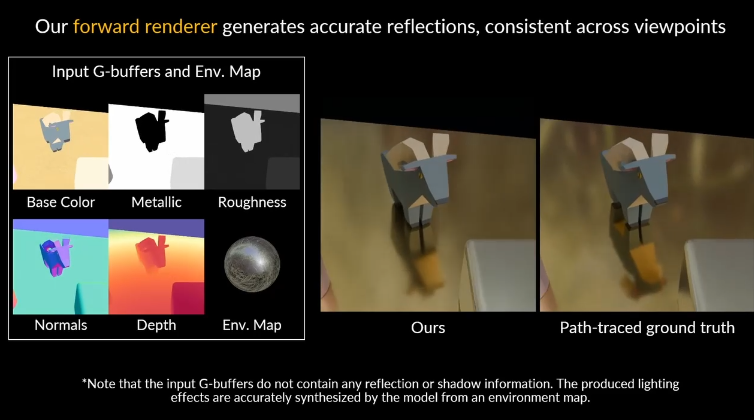

該模型使用了兩個神經渲染器。首先是神經逆渲染器,它會分析輸入的視頻,從中提取場景的幾何和材質屬性,生成所需的數據緩衝區;其次是神經前向渲染器,它將這些數據與所需的光照結合,生成高質量的逼真視頻。兩者的協同工作,使得 DiffusionRenderer 在處理現實世界數據時表現出了強大的適應能力。

研究團隊爲 DiffusionRenderer 設計了獨特的數據策略,構建了一個包含15萬個視頻的龐大合成數據集,作爲模型學習的基礎。同時,他們還利用一個包含10,510個真實世界視頻的數據集,自動生成了場景屬性標籤,使模型能夠更好地適應真實視頻的特性。

DiffusionRenderer 的表現令人矚目,在多項任務的對比測試中,均展現出了領先於其他方法的優勢。它不僅能夠在複雜場景中生成更逼真的光影效果,還能在反向渲染時準確估計場景的材質屬性。

這一技術的實際應用潛力巨大,用戶可以通過 DiffusionRenderer 進行動態光照、材料編輯及無縫對象插入等操作。用戶只需提供一段視頻,便可輕鬆實現對場景的修改和再創作。這一技術的發佈標誌着視頻渲染和編輯領域的一次重要飛躍,賦予了更多創作者和設計師更大的創作自由。

- Demo Video https://youtu.be/jvEdWKaPqkc

- github : https://github.com/nv-tlabs/cosmos1-diffusion-renderer

- 項目頁: https://research.nvidia.com/labs/toronto-ai/DiffusionRenderer/

劃重點:

🌟 DiffusionRenderer 通過結合生成與編輯功能,爲3D 場景創作帶來新的可能性。

🎥 該模型利用神經逆渲染器和神經前向渲染器的協同作用,提升了視頻渲染的真實感和適應性。

🚀 它的實際應用包括動態光照、材料編輯和對象插入,讓創作者能夠更加輕鬆地進行視頻創作。