AI技術の急激な発展に伴い、ビデオ生成の品質は驚くべきスピードで向上しており、初期の曖昧な映像から現在では非常に現実的なビデオに進化しています。しかし、このプロセスにおいて、生成された動画を制御や編集する能力が欠如しているという問題は依然として重要な課題となっています。NVIDIAとそのパートナーが最新の研究で発表したDiffusionRendererにより、この課題に対する新たな解決策が提示されました。

DiffusionRendererは画期的な研究成果であり、動画の生成だけでなく、動画内の3Dシーンの理解と操作も可能です。このモデルは生成と編集を統合し、AI駆動のコンテンツ制作の潜在力を大きく開花させました。過去の技術、例えば物理ベースレンダリング(PBR)は高精細な動画生成には優れていましたが、シーンの編集には限界がありました。DiffusionRendererは独自の方法で3Dシーンを処理し、この制約を突破しました。

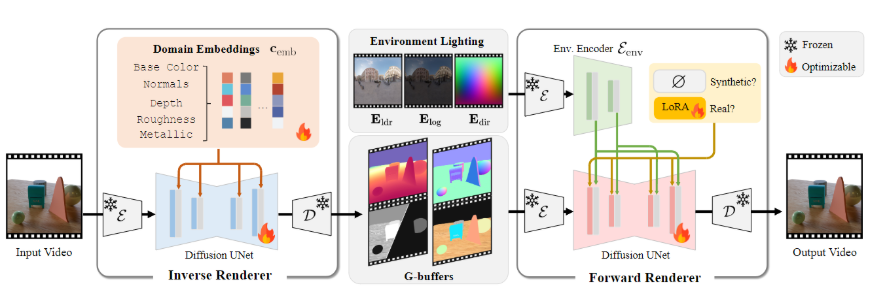

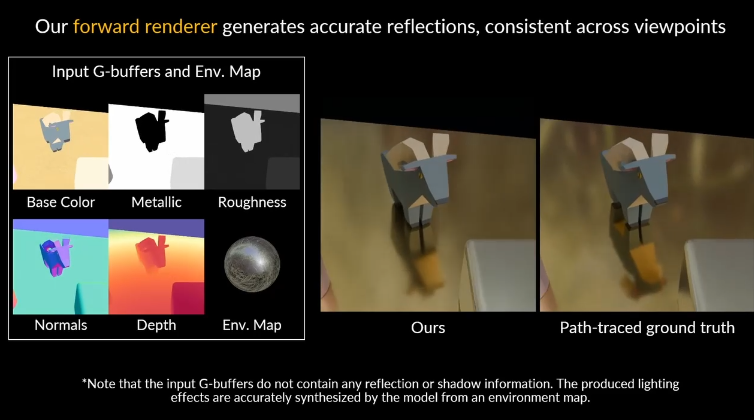

このモデルは2つのニューラルレンダラーを使用しています。最初はニューラル逆レンダラーで、入力された動画を分析し、シーンの幾何学的属性や材質を抽出して必要なデータバッファを生成します。次にニューラルフォワードレンダラーは、これらのデータと必要な照明を組み合わせて高品質で現実的な動画を生成します。両者の協働により、DiffusionRendererは現実世界のデータに対して強力な適応性を示しています。

研究チームはDiffusionRendererのために独自のデータ戦略を設計し、15万本の動画を含む大規模な合成データセットを構築しました。これはモデルの学習の基盤となります。また、10,510本の現実世界の動画を含むデータセットを用いて、自動的にシーン属性のラベルを生成し、モデルが現実的な動画の特性にさらに適応できるようにしました。

DiffusionRendererのパフォーマンスは注目すべきもので、複数のタスクにおける比較テストで他の手法よりも優れた結果を示しました。複雑なシーンにおいてよりリアルな光と影の効果を生成できるだけでなく、逆レンダリング時にシーンの材質属性を正確に推定することもできます。

この技術には実際の応用可能性が非常に大きく、ユーザーはDiffusionRendererを用いて動的な照明、素材の編集、そしてシームレスなオブジェクト挿入などの操作を行うことができます。ユーザーは単に動画を提供するだけで、シーンの修正や再創作を簡単に実現できます。この技術のリリースは、ビデオレンダリングおよび編集分野における重要な飛躍を示しており、より多くのクリエイターとデザイナーに創作の自由をもたらします。

- Demo Video https://youtu.be/jvEdWKaPqkc

- github : https://github.com/nv-tlabs/cosmos1-diffusion-renderer

- プロジェクトページ: https://research.nvidia.com/labs/toronto-ai/DiffusionRenderer/

ポイント:

🌟 DiffusionRendererは生成と編集の機能を統合し、3Dシーンの創作に新たな可能性をもたらします。

🎥 このモデルはニューラル逆レンダラーとニューラルフォワードレンダラーの協働によって、ビデオレンダリングの現実感と適応性を向上させます。

🚀 実際の応用には動的な照明、素材編集、オブジェクト挿入が含まれ、クリエイターが動画制作をより簡単にできるようになります。