微軟今天凌晨在官網上開源了最新版本的 Phi-4家族模型 ——Phi-4-mini-flash-reasoning。這一新版本在繼承了 Phi-4系列參數小、性能強的優點基礎上,專爲受到計算能力、內存和延遲限制的場景設計,能夠在單個 GPU 上運行,非常適合筆記本和平板電腦等邊緣設備。

Phi-4-mini-flash-reasoning 的推出,標誌着推理效率的顯著提升,相較於前一版本,推理效率暴漲了10倍,同時平均延遲降低了2到3倍。這種大幅度的性能提升,使其在高級數學推理方面表現得尤爲突出,非常適合教育和科研領域的應用。

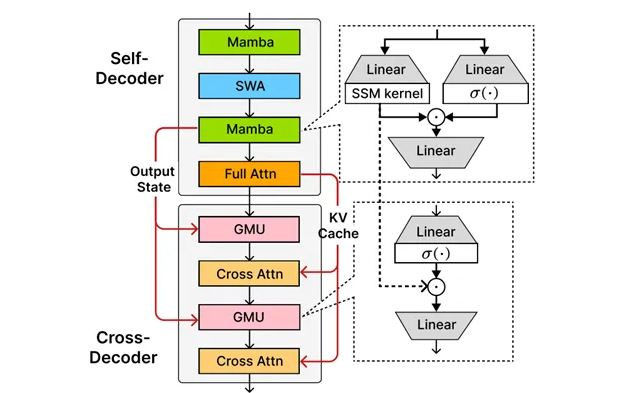

這一版本的核心在於微軟自研的 SambaY 架構。SambaY 是一種創新的解碼器混合架構,由微軟與斯坦福大學共同研發。通過引入門控存儲單元,SambaY 能夠實現跨層的高效記憶共享,從而在提升解碼效率的同時,保持線性預填充時間複雜度,增強長上下文性能,並且無需顯式位置編碼。

在長文本生成任務中,SambaY 展現了顯著的效率提升。在處理2K 長度的提示和32K 長度的生成任務時,解碼吞吐量相較於傳統的 Phi-4-mini-Reasoning 模型提高了10倍。此外,在數學推理能力的測試中,SambaY 的表現也有顯著提高,特別是在複雜的數學問題上,能夠生成清晰且邏輯連貫的解題步驟。

微軟還通過 Phonebook 和 RULER 等基準測試評估了 SambaY 在長上下文檢索方面的表現。在32K 長度的上下文中,SambaY 在 Phonebook 任務中達到了78.13% 的準確率,表現遠超其他模型。這證明了 SambaY 在長上下文理解與生成能力上的優勢。

爲了驗證 SambaY 的可擴展性,微軟進行了大規模的預訓練實驗,使用了3.8B 參數的 Phi-4-mini-Flash 模型,並在5T tokens 的數據集上進行了訓練。儘管訓練過程中遇到了一些挑戰,但通過引入標籤平滑和注意力 dropout 等技術,模型最終成功收斂,並在知識密集型任務中取得了顯著的性能提升。

開源地址:https://huggingface.co/microsoft/Phi-4-mini-flash-reasoning

英偉達API:https://build.nvidia.com/microsoft

劃重點:

🌟 微軟推出 Phi-4-mini-flash-reasoning,推理效率提升10倍,適合筆記本運行。

🔍 創新 SambaY 架構通過高效記憶共享提升解碼性能,適合長文本生成與數學推理。

📈 在基準測試中表現優異,Phonebook 任務準確率達78.13%,顯示出強大的長上下文理解能力。