在人工智能技術飛速發展的今天,中國科學院計算技術研究所自然語言處理團隊推出了一款名爲 Stream-Omni 的文本 - 視覺 - 語音多模態大模型。這一模型的核心亮點在於它能夠同時支持多種模態的交互方式,爲用戶帶來更加靈活和豐富的體驗。

全面支持多模態交互

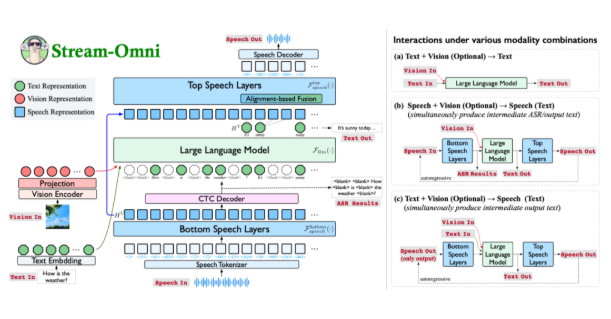

Stream-Omni 是一個基於 GPT-4o 架構的多模態大模型,展現了在文本、視覺和語音三種模態上的卓越能力。通過在線語音服務,用戶不僅可以進行語音交互,還能在此過程中實時獲取中間文本結果,使得交互體驗更爲自然,猶如 “邊看邊聽”。

創新的模態對齊方式

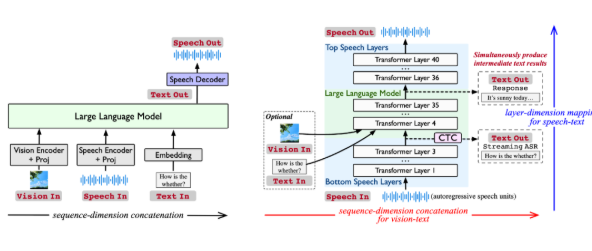

現有多模態大模型通常通過將不同模態的表示拼接在一起,以輸入到大語言模型中生成響應。然而,這種方法依賴於大量的數據,且缺乏靈活性。Stream-Omni 通過更有針對性的模態關係建模,減少了對大規模三模態數據的依賴。它強調語音與文本之間的語義一致性,並使視覺信息在語義上與文本互補,從而實現了更加高效的模態對齊。

強大的語音交互功能

Stream-Omni 獨特的語音建模方式使其在語音交互過程中能夠像 GPT-4o 一樣,同時輸出中間的文本轉錄結果。這一設計爲用戶提供了更全面的多模態交互體驗,尤其在需要語音到文本實時轉換的場景中,極大提升了效率和便利性。

實現任意模態組合的靈活交互

Stream-Omni 的設計允許通過靈活組合視覺編碼器、語音層和大語言模型,支持多種模態組合的交互。這種靈活性使得用戶能夠在不同場景下自由選擇輸入方式,無論是文本、語音還是視覺,均可獲得一致的響應。

在多項實驗中,Stream-Omni 的視覺理解能力與同規模的視覺大模型相當,而其語音交互能力則顯著優於現有技術。這種基於層級維度的語音 - 文本映射機制,確保了語音與文本之間的語義精確對齊,使得不同模態的響應更加一致。

Stream-Omni 不僅在多模態交互中提供了新思路,更以其靈活、高效的特性,推動了文本、視覺和語音技術的深度融合。儘管在擬人化表現和音色多樣性上仍有待提升,但它無疑爲未來的多模態智能交互奠定了堅實基礎。

論文鏈接:https://arxiv.org/abs/2506.13642

開源代碼:https://github.com/ictnlp/Stream-Omni

模型下載:https://huggingface.co/ICTNLP/stream-omni-8b