人工知能技術が急速に発展する今日、中国科学院計算技術研究所の自然言語処理チームは、「Stream-Omni」というテキスト-ビジョン-音声マルチモーダル大規模モデルをリリースしました。このモデルの核心的な特徴は、複数のモードのインタラクションを同時にサポートでき、ユーザーにより柔軟で豊かな体験を提供することです。

マルチモーダルインタラクションの完全なサポート

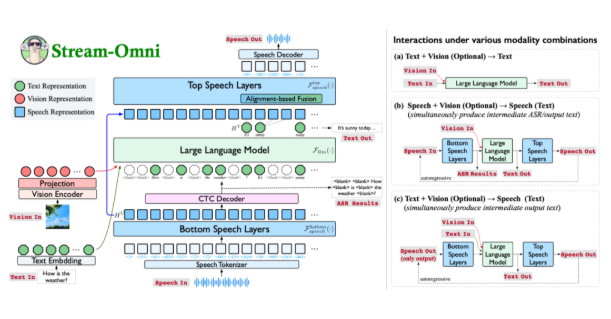

Stream-Omniは、GPT-4oアーキテクチャに基づいたマルチモーダル大規模モデルであり、テキスト、ビジュアル、音声の3つのモードにおける優れた能力を示しています。オンライン音声サービスを通じて、ユーザーは音声インタラクションだけでなく、その過程でリアルタイムで中間テキスト結果を得ることができます。これにより、インタラクションの体験がより自然になり、「見ながら聞く」ような感覚を得られます。

革新的なモード同期方式

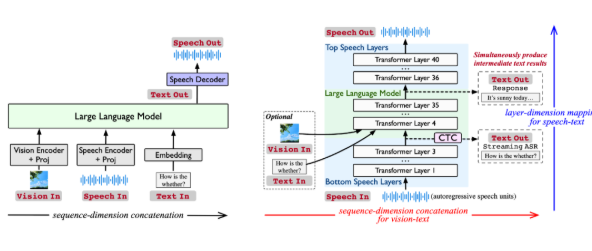

現存するマルチモーダル大規模モデルは通常、異なるモードの表現を結合して、大規模言語モデルに入力し、応答を生成します。しかし、この方法は大量のデータに依存しており、柔軟性に欠けます。Stream-Omniは、よりターゲットに沿ったモード関係モデリングを行い、大規模な3モードデータへの依存を減らしています。音声とテキストの意味の一貫性を強調し、ビジュアル情報がテキストと意味的に補完されるようにし、より効率的なモード同期を実現しています。

強力な音声インタラクション機能

Stream-Omniの独自な音声モデリングにより、音声インタラクション中にGPT-4oのように中間テキスト変換結果を出力できます。この設計により、ユーザーはより包括的なマルチモーダルインタラクション体験を得られ、特に音声からテキストへのリアルタイム変換が必要なシナリオにおいて、効率と利便性が大幅に向上します。

任意のモード組み合わせの柔軟なインタラクション

Stream-Omniの設計は、視覚エンコーダー、音声層、および大規模言語モデルを柔軟に組み合わせることで、さまざまなモード組み合わせのインタラクションをサポートしています。この柔軟性により、ユーザーは異なるシナリオで入力方法を選択でき、テキスト、音声、またはビジュアルいずれかでも一貫した応答を得ることができます。

多くの実験で、Stream-Omniの視覚理解能力は同規模の視覚大規模モデルと同等であり、音声インタラクション能力は既存の技術を大きく上回っています。この階層的次元に基づく音声-テキストマッピングメカニズムにより、音声とテキストの意味の正確な同期が確保され、異なるモードの応答がより一貫しています。

Stream-Omniは、マルチモーダルインタラクションにおいて新しい考え方を提供し、その柔軟さと効率性により、テキスト、ビジュアル、音声技術の深く融合を推進しています。人間らしい表現や音色の多様性にはまだ改善の余地がありますが、これは明らかに今後のマルチモーダルスマートインタラクションの堅固な基盤を築いています。

論文リンク:https://arxiv.org/abs/2506.13642

オープンソースコード:https://github.com/ictnlp/Stream-Omni

モデルダウンロード:https://huggingface.co/ICTNLP/stream-omni-8b