在人工智能領域,獎勵模型是對齊大型語言模型(LLMs)與人類反饋的關鍵組成部分,但現有模型面臨着 “獎勵黑客” 問題。

這些模型往往關注表面的特徵,例如回覆的長度或格式,而不是識別真正的質量指標,如事實準確性和相關性。問題的根源在於,標準訓練目標無法區分訓練數據中存在的虛假關聯和真實的因果驅動因素。這種失敗導致了脆弱的獎勵模型(RMs),從而生成不對齊的策略。爲了解決這一問題,需要一種利用因果理解來訓練 RMs 的新方法,以便對因果質量屬性敏感,並對各種虛假線索保持不變。

現有的獎勵模型方法試圖解決依賴 Bradley-Terry 或成對排名方法的標準 RLHF 系統中的獎勵黑客問題,包括架構修改、策略級調整和涉及集合或一致性檢查的數據中心方法。近期的因果啓發式方法使用 MMD 正則化針對預先指定的虛假因素,或者通過修正重寫估計因果效應。然而,這些方法僅針對預先確定的虛假因素,未能捕捉到未知的關聯。儘管增強策略仍然較爲粗糙,且以評估爲中心的方法未能爲獎勵模型提供應對多樣化虛假變異的強大訓練機制。

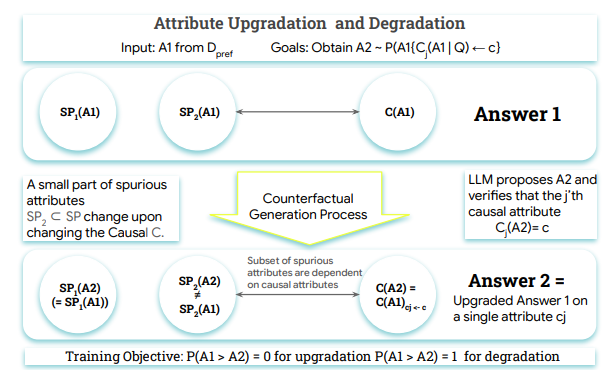

爲了應對這些挑戰,谷歌 DeepMind、麥吉爾大學和 MILA - 魁北克人工智能研究所的研究人員提出了 Crome(因果魯棒獎勵建模)。Crome 框架建立在對答案生成的明確因果模型之上,通過添加帶有針對性、由大型語言模型生成的反事實示例的偏好數據集,來訓練 RMs,從而區分真實的質量驅動因素和表面線索。此外,Crome 創建了兩種類型的合成訓練對:因果增強(Causal Augmentations)和中性增強(Neutral Augmentations),增強模型的魯棒性,最大限度提高獎勵基準的準確性。

Crome 的操作分爲兩個主要階段:基於因果模型生成屬性感知的反事實數據,並通過組合數據上的專門損失來訓練獎勵模型。在評估性能時,研究人員使用了多種基礎 LLM,包括 Gemma-2-9B-IT、Qwen2.5-7B 等,取得了顯著的性能提升。

Crome 在多個基準上表現優異,尤其在安全性和推理能力方面,取得了明顯的進步。此外,它在 WildGuardTest 上也表現良好,降低了對有害提示的攻擊成功率,同時保持了對良性提示的相似拒絕率。

未來,Crome 的研究方向將集中在因果數據增強上,推動合成數據生成,爲基礎模型訓練提供新的可能性。

論文:https://arxiv.org/abs/2506.16507

劃重點:

🌟 Crome 框架由谷歌 DeepMind 等機構提出,旨在提升獎勵模型的魯棒性。

📈 Crome 通過因果增強和中性增強策略,顯著提高了模型在多項任務中的表現。

🔒 Crome 在安全性測試中表現優異,降低了攻擊成功率,提升了模型的可靠性。