大型語言模型(LLM)通過結合任務提示和大規模強化學習(RL)在複雜推理任務中取得了顯著進展,如 Deepseek-R1-Zero 等模型直接將強化學習應用於基礎模型,展現出強大的推理能力。然而,這種成功在不同的基礎模型系列中難以複製,尤其是在 Llama 系列上。這引發了一個核心問題:究竟是什麼因素導致了不同基礎模型在強化學習過程中表現不一致?

強化學習在 Llama 模型上的擴展限制

OpenAI 的 o1、o3和 DeepSeek 的 R1等模型在競賽級數學問題上通過大規模強化學習取得了突破,推動了對千億參數以下小型模型強化學習能力的探索。然而,這些進展大多侷限於 Qwen 模型系列,難以在 Llama 等模型上覆現。預訓練流程缺乏透明度,使得理解預訓練如何影響強化學習的擴展變得困難。一些非傳統研究發現,一次性提示可以提高 Qwen 的推理能力,但對 Llama 卻收效甚微。儘管 OpenWebMath、MathPile 等項目致力於整理高質量的數學預訓練語料庫,但其規模仍受限於千億個 token 以下。

探索訓練中期的穩定衰減策略

上海交通大學的研究人員以 Qwen 和 Llama 爲研究對象,深入探究了中期訓練策略對強化學習動態的影響,並得出了以下見解:

首先,像 MegaMath-Web-Pro 這樣的高質量數學語料庫能同時提升基礎模型和強化學習的效果。其次,使用問答式數據,特別是包含長 CoT(Chain-of-Thought)推理的數據,可以進一步增強強化學習效果。第三,長 CoT 會在強化學習訓練中引入冗長性和不穩定性。最後,在中期訓練中應用擴展可以提升下游強化學習的性能。

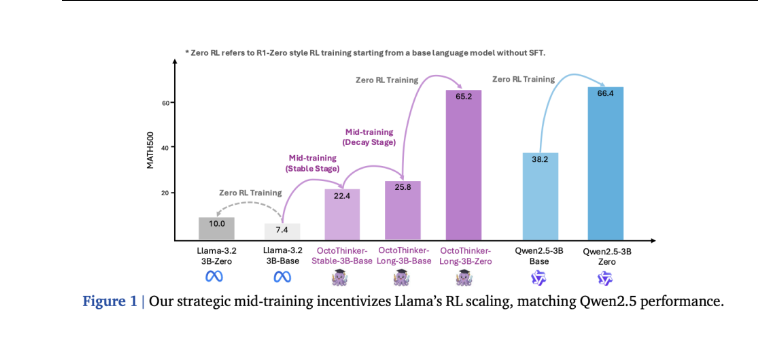

研究人員提出了一種名爲“穩定-衰減”的兩階段中期訓練策略:首先使用2000億個 token 訓練基礎模型,然後在三個以 CoT 爲中心的分支上使用200億個 token 進行訓練。最終,這一策略成功生成了具有強大強化學習兼容性的 OctoThinker 模型。

RL 配置和基準評估

研究人員使用 MATH8K 數據集進行強化學習 (RL) 訓練提示,配置包括全局訓練批次大小128、每個查詢16個 rollout 響應以及 PPO 最小批次大小64。實驗在 Llama-3.2-3B-Base 和 Qwen2.5-3B-Base 模型上進行。在評估中,基礎語言模型採用少樣本提示,而強化學習調優模型在 GSM8K、MATH500、OlympiadBench 和 AMC23 等指標任務上採用零樣本提示。

在強化學習訓練期間,Qwen 模型的響應長度持續增加並保持在合理範圍內,而 Llama 模型則表現出異常行爲,平均響應長度飆升至4,096個 token。評估結果進一步表明,強化學習調優後的 Qwen2.5-3B 在各個基準測試中均有所提升,而 Llama-3.2-3B 的提升則微乎其微。

OctoThinker 在 RL 兼容性方面優於 Llama

在13個數學基準測試中,每個 OctoThinker 分支都比原始 Llama 基礎模型提升了10%-20%,並且在所有規模的穩定階段模型上都取得了持續的提升。OctoThinker-Zero 系列在強化學習擴展過程中展現出多樣化的思維行爲,其中 OctoThinker-Long 變體表現出色。在強化學習訓練過程中比較三個3B 規模基礎模型時,OctoThinker-Long-3B 的表現優於原始 Llama-3.2-3B 模型,並與以強大的推理能力和廣泛預訓練而聞名的 Qwen2.5-3B 模型達到相近的性能水平。混合分支和短分支的性能略低,尤其是在更具挑戰性的基準測試中。

結論和未來工作:邁向 RL-Ready 基礎模型

該研究深入探討了 Llama 和 Qwen 等基礎模型在強化學習推理過程中行爲差異的原因,並強調了中期訓練對強化學習可擴展性的重要性。兩階段中期訓練策略成功將 Llama 轉化爲更適合強化學習的基礎模型,最終誕生了 OctoThinker 模型。

未來的研究方向包括:策劃更高質量的數學語料庫以改善中期訓練;使用開放配方創建 RL 友好的基礎模型,無需從長 CoT 推理模型中進行提煉;分離 QA 格式和內容以分別瞭解它們的貢獻;並通過新的分支(例如工具集成推理)擴展 OctoThinker 家族。