騰訊發佈了混元 TurboS 技術報告,揭示了其旗艦大語言模型 TurboS 的核心創新與強大能力。

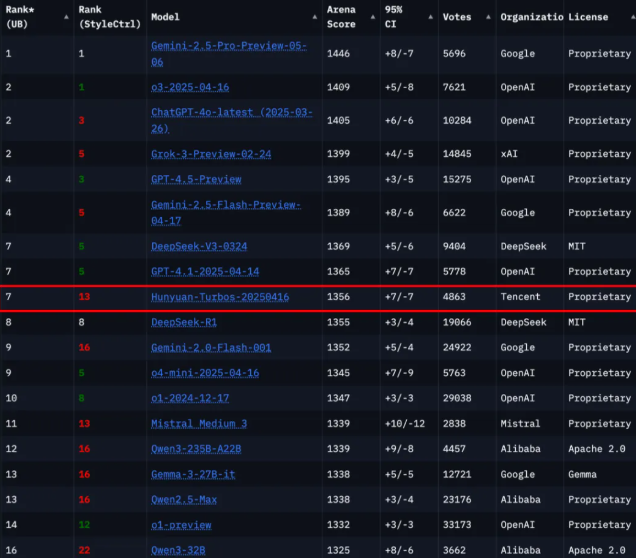

根據全球權威大模型評測平臺 Chatbot Arena 的最新排名,混元 TurboS 在239個參賽模型中位列第七,成爲國內僅次於 Deepseek 的頂尖模型,並在國際上僅落後於谷歌、OpenAI 及 xAI 等幾家機構。

混元 TurboS 模型的架構採用了創新的 Hybrid Transformer-Mamba 結構,這種新穎的設計結合了 Mamba 架構在處理長序列上的高效性與 Transformer 架構在上下文理解上的優勢,從而實現了性能與效率的平衡。該模型總共包含128層,激活參數量高達560億,成爲業界首個大規模部署的 Transformer-Mamba 專家混合模型(MoE)。通過這樣的架構創新,TurboS 在國際權威評測中取得了整體高分1356。

爲了進一步提升模型的能力,混元 TurboS 引入了自適應長短思維鏈機制,能夠根據問題的複雜度自動切換響應模式。這一機制讓模型在處理簡單問題時能夠迅速響應,而在面對複雜問題時,則會深入分析並給出高準確度的答案。此外,團隊還設計了包含監督微調、自適應長短 CoT 融合等四個關鍵模塊的後訓練流程,進一步增強了模型的表現。

在預訓練階段,混元 TurboS 在16萬億 Token 的語料上進行訓練,確保了模型的數據質量和多樣性。其核心架構包含 Transformer、Mamba2和前饋神經網絡(FFN)組件,層級構成合理,最大程度上提升了訓練和推理的效率。

此次技術報告的發佈,不僅展示了騰訊在大語言模型領域的技術實力,也爲今後大模型的發展提供了新的思路與方向。

論文鏈接: https://arxiv.org/abs/2505.15431

劃重點:

🌟 TurboS 模型在 Chatbot Arena 中排名第七,展現了強大的競爭力。

💡 創新的 Hybrid Transformer-Mamba 架構實現了性能與效率的最佳平衡。

🔍 自適應長短思維鏈機制提升了模型在不同複雜度問題下的響應能力。