近日,字節跳動(ByteDance)正式公佈了其最新AI項目“DreamActor-M1”,一項旨在革新視頻生成技術的前沿成果。這款模型通過結合一張靜態照片和一段參考動作視頻,能夠將照片中的人物無縫替換到視頻場景中,生成表情細膩、動作自然且畫質高清的動態影像。這一技術的亮相,不僅標誌着字節跳動在生成式AI領域的又一次突破,也被視爲對現有動畫生成工具(如Runway的Act-One)的有力挑戰。

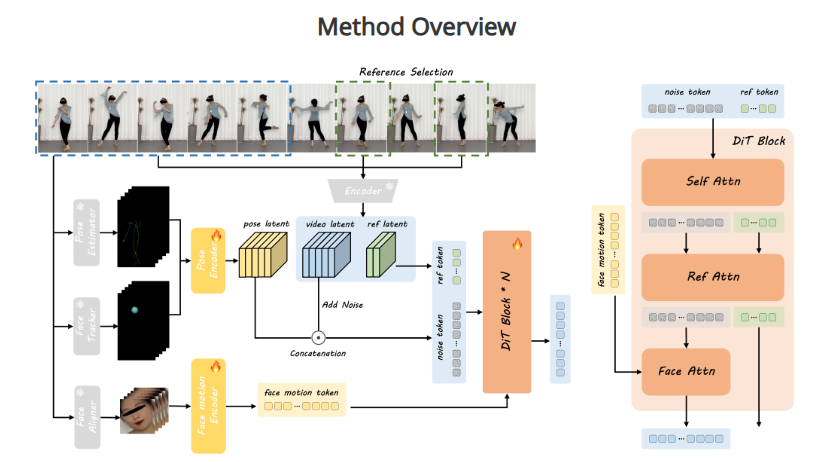

DreamActor-M1的核心創新在於其對細節的精準把控和一致性表現。傳統圖像到視頻的生成方法往往面臨諸多難題,例如表情刻畫不夠生動、動作過渡不自然,以及在長視頻中細節失配或“穿幫”的問題。而DreamActor-M1通過先進的算法設計,成功克服了這些技術瓶頸。無論是人物微笑時的嘴角弧度、眨眼時的自然節奏,還是嘴脣輕顫的細微變化,該模型都能以驚豔的真實感呈現。同時,它還能同步控制身體動作,例如轉頭、擡手甚至跳舞等複雜行爲,確保畫面整體的協調性和流暢性。

據技術分析,這一成果可能得益於字節跳動在深度學習和視頻處理技術上的深厚積累。DreamActor-M1不僅能夠捕捉參考視頻中的動作模式,還能將這些模式與靜態照片中的人物特徵無縫融合,生成的結果既保留了原始身份的獨特性,又避免了常見的“失真”或“亂動”現象。這種高保真度的輸出,使其在畫質上達到了高清標準,爲用戶提供了接近真實拍攝的視覺體驗。

業內專家指出,DreamActor-M1的推出填補了AI視頻生成領域的一項重要空白。與Runway的Act-One等現有技術相比,該模型在細粒度控制(如微表情的再現)和多維度動作同步(如面部與肢體的協調)上表現尤爲突出。這一特性使其在多種應用場景中具備廣闊前景。例如,在影視製作中,導演可以利用單張照片快速生成角色的動態表演;在社交媒體領域,用戶可以將自己的照片轉化爲生動有趣的動畫視頻;在教育或虛擬現實領域,這一技術也能爲沉浸式內容創作提供支持。

然而,DreamActor-M1的亮相也引發了關於技術應用的深層思考。其高度逼真的生成能力可能爲數字內容創作帶來革命性變化,但同時也可能加劇關於深度僞造(deepfake)和隱私保護的討論。字節跳動尚未透露該模型的具體訓練數據來源或商業化計劃,但外界普遍期待其能在未來提供更多細節,以平衡技術創新與倫理規範。

作爲TikTok的母公司,字節跳動近年來在AI領域的佈局日益深化。從圖像生成到視頻動畫,其技術研發正不斷向更復雜的多模態方向邁進。DreamActor-M1的發佈,不僅是對自身技術實力的又一次證明,也是在全球AI競賽中邁出的堅實一步。可以預見,隨着這一模型的進一步完善與推廣,它或將重新定義視頻內容的創作方式,爲用戶和行業帶來更多驚喜與可能性。

項目地址:https://grisoon.github.io/DreamActor-M1/