Meta 與滑鐵盧大學的研究團隊共同開發了一款名爲 MoCha 的人工智能系統,能夠生成包含同步語音和自然動作的完整角色動畫。這一創新突破不同於以往僅聚焦於面部的動畫生成模型,MoCha 可從多個攝像機角度渲染全身動作,涵蓋嘴脣同步、手勢表現,以及多個角色之間的互動。

提高口型同步準確度

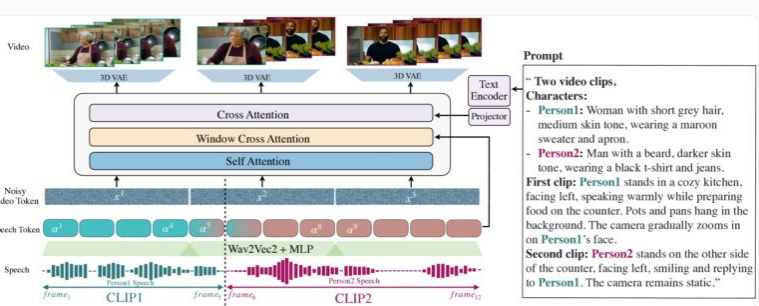

MoCha 的演示重點展示了特寫鏡頭和半特寫鏡頭下的上身動作與手勢同步生成。該系統的獨特之處在於其引入的“語音-視頻窗口注意”機制,這一機制成功解決了長期以來困擾 AI 視頻生成的兩個主要挑戰:一是視頻壓縮時如何保持音頻的全分辨率,二是在並行生成視頻時避免脣部運動與音頻不匹配的問題。

MoCha 的創新之處在於,通過限制每幀訪問特定音頻數據窗口,模擬了人類的發音方式——嘴脣運動與即時聲音密切相關,而肢體語言則依據更廣泛的文本模式展現。通過在每幀音頻前後添加標記,MoCha 能有效實現更平滑的過渡和更精準的嘴脣同步。

MoCha 根據文本描述生成帶有面部、手勢和嘴脣動作的逼真視頻。

爲了構建該系統,研究團隊使用了300小時精心篩選的視頻內容,並結合基於文本的視頻序列來擴展表現和互動的可能性。尤其是在多角色場景下,MoCha 展現了其強大的能力,用戶只需簡單地定義角色一次,便可通過標籤(如“人物1”或“人物2”)在不同場景中輕鬆調用,無需重複描述。

管理多個角色

在150種不同場景的測試中,MoCha 在口型同步與自然動作的質量上,均超過了同類系統。獨立評估人員一致認爲該系統生成的視頻高度逼真,表現出了前所未有的精度與自然度。

研究人員開發了一個提示模板,讓用戶無需重複描述即可引用特定字符。

MoCha 的開發使其在多個應用領域展現出巨大潛力,尤其在數字助理、虛擬化身、廣告與教育內容等領域。儘管 Meta 尚未透露該系統是否會開源,或仍處於研究原型階段,但這一技術的推出無疑爲 AI 驅動的視頻生成開闢了新的篇章。

在人工智能視頻技術競爭日益激烈的背景下,MoCha 的發佈尤爲引人注目。Meta 最近也推出了 MovieGen 系統,而 TikTok 母公司字節跳動則在研發自己的人工智能動畫工具,包括 INFP、OmniHuman-1和 Goku,顯示出社交媒體公司在這一領域的積極佈局。