Metaとウォータールー大学の研究チームが共同開発したMoChaという人工知能システムは、同期音声と自然な動作を含む完全なキャラクターアニメーションを生成できます。これは、顔のアニメーション生成モデルに焦点を当ててきた従来の方法とは異なり、MoChaは複数のカメラアングルから全身の動きをレンダリングし、唇の同期、ジェスチャー、複数のキャラクター間のインタラクションを網羅しています。

口パクの精度向上

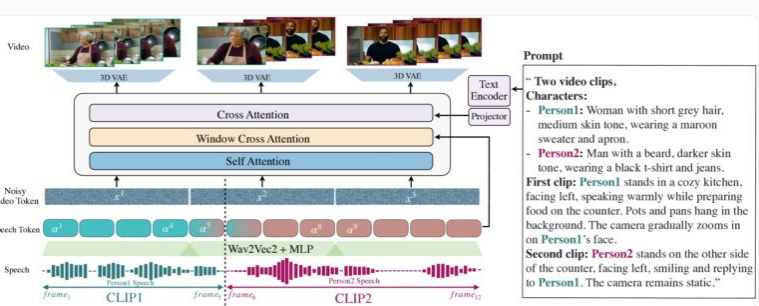

MoChaのデモでは、クローズアップとミドルショットでの上半身の動きとジェスチャーの同期生成が重点的に示されています。「音声-ビデオウィンドウ注意」メカニズムの導入が、このシステムの独自性です。このメカニズムは、AIビデオ生成における長年の課題、すなわち、1. 音声のフル解像度をビデオ圧縮時に維持する方法、2. ビデオを並列生成する際に唇の動きと音声の不一致を避ける方法、の2つの主要な課題を解決することに成功しました。

MoChaの革新的な点は、各フレームが特定の音声データウィンドウへのアクセスを制限することで、人間の発音方法、つまり唇の動きが瞬時の音と密接に関連し、ボディランゲージはより広範なテキストパターンに基づいて表現されることを模倣していることです。各フレームの音声の前後にマーカーを追加することで、MoChaはよりスムーズなトランジションとより正確な口パクを実現できます。

MoChaは、テキストの説明に基づいて、顔、ジェスチャー、唇の動きを含むリアルなビデオを生成します。

このシステムを構築するために、研究チームは300時間もの厳選されたビデオコンテンツを使用し、テキストベースのビデオシーケンスを組み合わせて表現とインタラクションの可能性を拡大しました。特に複数キャラクターのシーンでは、MoChaはその強力な能力を発揮します。ユーザーは一度キャラクターを定義するだけで、「キャラクター1」や「キャラクター2」などのラベルを使って異なるシーンで簡単に呼び出すことができ、繰り返し記述する必要はありません。

複数キャラクターの管理

150種類の異なるシーンでのテストにおいて、MoChaは口パクの同期と自然な動作の品質において、同種のシステムを上回りました。独立した評価者たちは、このシステムが生成するビデオは非常にリアルで、これまでにない精度と自然さを示していると一致して評価しています。

研究者たちは、ユーザーが特定のキャラクターを参照する際に繰り返し記述する必要がないプロンプトテンプレートを開発しました。

MoChaの開発により、デジタルアシスタント、バーチャルアバター、広告、教育コンテンツなどの多くのアプリケーション分野で大きな可能性が開かれています。Metaはまだこのシステムをオープンソース化するかどうか、あるいはまだ研究段階のプロトタイプであるかどうかを明らかにしていませんが、この技術の登場は、AI駆動のビデオ生成に新たな章を開いたことは間違いありません。

人工知能ビデオ技術の競争が激化する中、MoChaの発表は特に注目に値します。Metaは最近MovieGenシステムも発表しており、TikTokの親会社であるバイトダンスも、INFP、OmniHuman-1、GokuなどのAIアニメーションツールを開発しており、ソーシャルメディア企業がこの分野に積極的に取り組んでいることを示しています。