谷歌 CEO 桑達爾・皮查伊(Sundar Pichai)在一場發佈會上宣佈,谷歌開源了最新的多模態大模型 Gemma-3,該模型以低成本、高性能爲特點,備受關注。

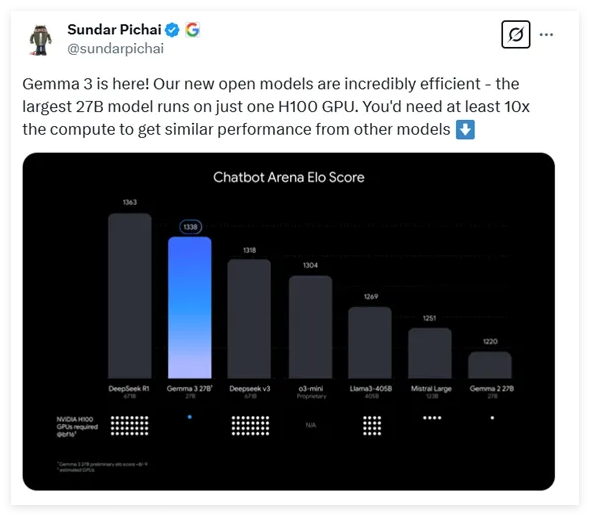

Gemma-3提供了四種不同參數規模的選項,分別爲10億、40億、120億和270億參數。令人驚訝的是,最大參數的270億模型只需一張 H100顯卡即可高效推理,而同類模型往往需要十倍的算力,這使 Gemma-3成爲目前算力要求最低的高性能模型之一。

根據最新的測試數據,Gemma-3在各類對話模型的評比中表現不俗,僅次於知名的 DeepSeek 模型,超越了 OpenAI 的 o3-mini 和 Llama3等多個熱門模型。此次發佈的 Gemma-3的架構延續了前兩代的通用解碼器 Transformer 設計,但加入了許多創新和優化。爲了解決長上下文帶來的內存問題,Gemma-3採用了局部與全局自注意力層交錯的架構,顯著降低了內存佔用。

在上下文處理能力方面,Gemma-3支持的上下文長度擴展到了128Ktoken,爲處理長文本提供了更好的支持。此外,Gemma-3還具備多模態能力,能夠同時處理文本和圖像,並集成了基於 VisionTransformer 的視覺編碼器,有效減少了圖像處理的計算成本。

在訓練過程中,Gemma-3使用了更多的 token 預算,特別是在270億參數模型中使用了14T 的 token 量,並引入了多語言數據,以增強模型的語言處理能力,支持140種語言,其中35種語言可以直接使用。Gemma-3採用了先進的知識蒸餾技術,在訓練後期通過強化學習優化模型表現,尤其是在幫助性、推理能力和多語言能力等方面取得了顯著提升。

經過評測,Gemma-3在多模態任務上表現優異,長文本處理能力也令人印象深刻,達到了66% 的準確率。此外,在對話能力評估中,Gemma-3的表現也名列前茅,顯示了其在各項任務中的綜合實力。

地址:地址:https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

劃重點:

🔍 Gemma-3是谷歌最新開源的多模態大模型,參數範圍從10億到270億,且算力需求降低10倍。

💡 模型採用創新的架構設計,有效處理長上下文和多模態數據,支持文本與圖像的同時處理。

🌐 Gemma-3支持140種語言的處理能力,經過訓練優化後在多項任務中表現優異,展現了強大的綜合能力。