GoogleのCEO、サンダー・ピチャイは発表会で、最新のマルチモーダル大規模言語モデルGemma-3をオープンソース化すると発表しました。このモデルは低コストで高性能を特徴とし、大きな注目を集めています。

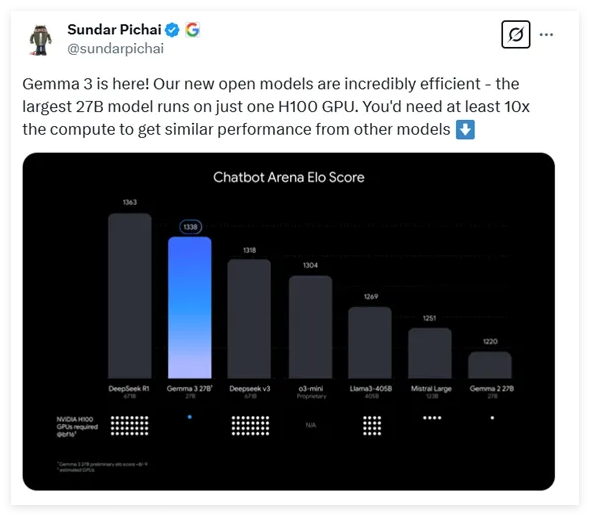

Gemma-3は、10億、40億、120億、270億パラメータの4つの異なるパラメータ規模のオプションを提供しています。驚くべきことに、最大パラメータ数の270億パラメータモデルは、H100 GPU1枚だけで効率的に推論を実行できます。同等のモデルは通常10倍の計算能力を必要とするため、Gemma-3は現在、最も計算能力の要求が低い高性能モデルの1つとなっています。

最新のテストデータによると、Gemma-3は様々な対話型モデルの比較において優れたパフォーマンスを示し、有名なDeepSeekモデルに次ぐ結果となりました。OpenAIのo3-miniやLlama3などの多くの注目モデルを上回っています。今回発表されたGemma-3のアーキテクチャは、前2世代の汎用デコーダTransformer設計を継承していますが、多くの革新と最適化が加えられています。長いコンテキストによるメモリの問題を解決するために、Gemma-3は局所的および大域的自注意層を交互に配置したアーキテクチャを採用しており、メモリ使用量を大幅に削減しています。

コンテキスト処理能力に関しては、Gemma-3はサポートされるコンテキスト長を128Kトークンに拡張し、長文処理をより適切にサポートしています。さらに、Gemma-3はマルチモーダル能力を備えており、テキストと画像の同時処理が可能で、VisionTransformerベースのビジョンエンコーダを統合することで、画像処理の計算コストを効果的に削減しています。

トレーニングプロセスでは、Gemma-3はより多くのトークン予算を使用しており、特に270億パラメータモデルでは14Tトークンを使用しています。また、多言語データを取り入れることで、モデルの言語処理能力を強化し、140種類の言語をサポートしており、そのうち35種類の言語は直接使用できます。Gemma-3は高度な知識蒸留技術を採用し、トレーニング後期に強化学習を用いてモデルのパフォーマンスを最適化することで、特にヘルプ機能、推論能力、多言語能力において顕著な向上を遂げています。

評価の結果、Gemma-3はマルチモーダルトスクにおいて優れたパフォーマンスを示し、長文処理能力も非常に高く、66%の精度を達成しました。さらに、対話能力評価でもトップクラスの結果となり、様々なタスクにおける総合的な能力の高さを示しています。

アドレス:アドレス:https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

要点:

🔍 Gemma-3はGoogleが新たにオープンソース化したマルチモーダル大規模言語モデルで、パラメータ数は10億から270億まで、計算能力の必要性は10分の1に削減されています。

💡 革新的なアーキテクチャ設計を採用し、長いコンテキストとマルチモーダルデータの効率的な処理を実現。テキストと画像の同時処理をサポートしています。

🌐 Gemma-3は140種類の言語を処理でき、トレーニングと最適化を経て、様々なタスクで優れたパフォーマンスを示し、強力な総合能力を備えています。