3月11日,通義實驗室團隊宣佈開源R1-Omni模型,爲全模態模型的發展帶來了新的突破。該模型結合了強化學習與可驗證獎勵(RLVR)方法,專注於提升多模態情感識別任務中的推理能力和泛化性能。

R1-Omni的訓練分爲兩個階段。在冷啓動階段,團隊使用包含580條視頻數據的組合數據集進行微調,這些數據來自Explainable Multimodal Emotion Reasoning(EMER)數據集和HumanOmni數據集。這一階段旨在爲模型奠定基礎推理能力,確保其在進入RLVR階段前具備一定的多模態情感識別能力,從而保障後續訓練的平穩性、效率與穩定性。

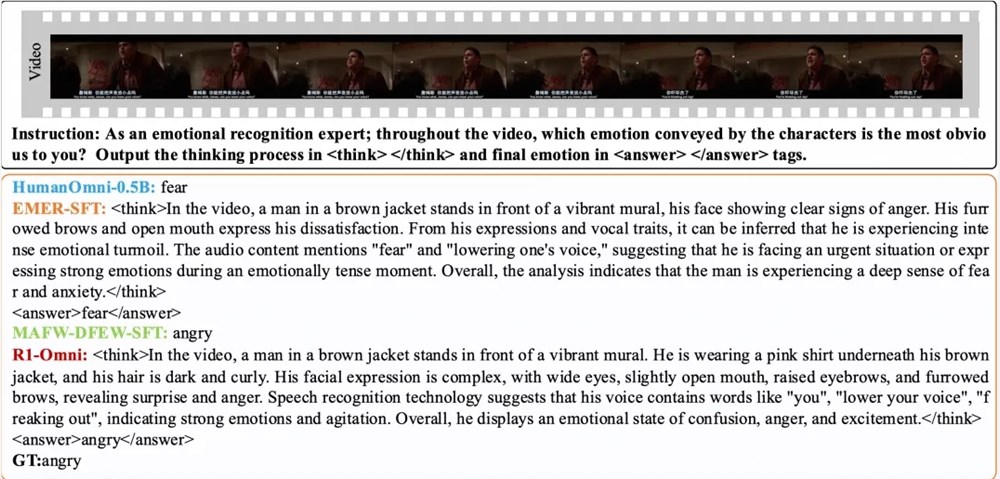

隨後,在RLVR階段,模型通過強化學習與可驗證獎勵機制進一步優化。該階段的關鍵在於策略模型和獎勵函數。策略模型處理視頻幀和音頻流組成的多模態輸入數據,生成帶有詳細推理過程的候選響應,展示模型如何整合視覺和聽覺信息以得出預測。獎勵函數則受DeepSeek R1啓發,分爲精確率獎勵和格式獎勵兩部分,共同形成最終獎勵,既鼓勵模型生成正確預測,又保證輸出結構化且符合預設格式。

實驗結果顯示,R1-Omni在同分布測試集DFEW和MAFW上,相較於原始基線模型平均提升超過35%,相較於有監督微調(SFT)模型在未加權平均召回率(UAR)上提升高達10%以上。在不同分佈測試集RAVDESS上,其加權平均召回率(WAR)和UAR均提升超過13%,展現出卓越的泛化能力。此外,R1-Omni還具有顯著的透明性優勢,通過RLVR方法,音頻和視頻信息在模型中的作用變得更加清晰可見,能夠明確展示各模態信息對特定情緒判斷的關鍵作用,爲理解模型決策過程和未來研究提供了重要參考。

論文:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/HumanMLLM/R1-Omni

模型:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B