在人工智能領域,語言模型的快速發展引發了語音理解語言模型(SULMs)的廣泛關注。近日,西北工業大學 ASLP 實驗室發佈了開放語音理解模型 OSUM,旨在探索在學術資源有限的情況下,如何有效訓練和利用語音理解模型,以推動學術界的研究與創新。

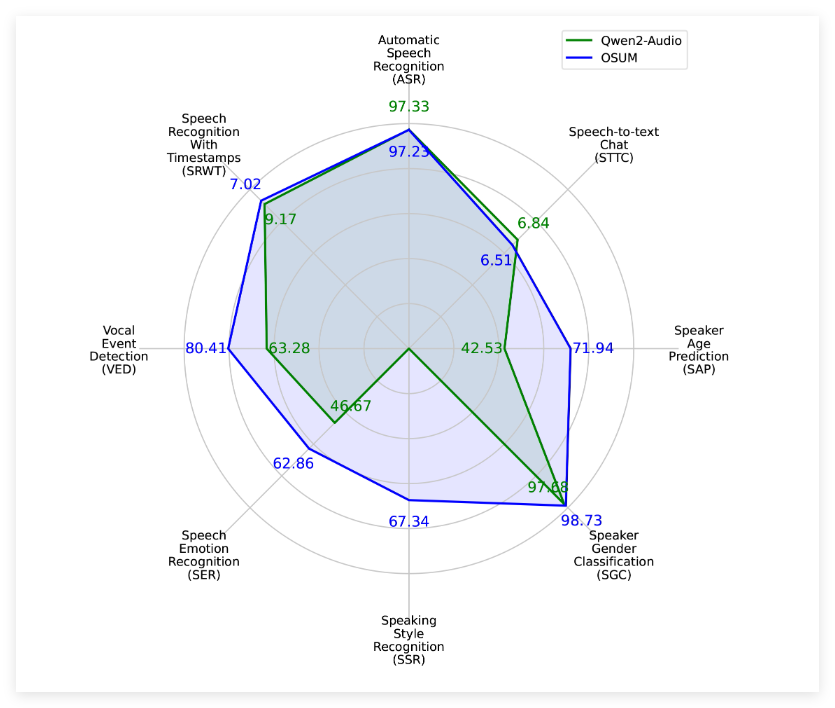

OSUM 模型融合了 Whisper 編碼器與 Qwen2語言模型,支持8種語音任務,包括語音識別(ASR)、帶時間戳的語音識別(SRWT)、語音事件檢測(VED)、語音情感識別(SER)、說話風格識別(SSR)、說話人性別分類(SGC)、說話人年齡預測(SAP)及語音轉文本聊天(STTC)。該模型通過採用 ASR+X 訓練策略,能夠在進行目標任務的同時高效穩定地優化語音識別,提升多任務學習的能力。

OSUM 模型的發佈不僅注重性能表現,還強調透明性。其訓練方法和數據準備過程均已開放,旨在爲學術界提供有價值的參考與指導。根據技術報告 v2.0的介紹,OSUM 模型的訓練數據量已提升至50.5K 小時,顯著高於之前的44.1K 小時。其中,包括3000小時的語音性別分類數據和6800小時的說話人年齡預測數據。這些數據的擴展使得模型在各種任務中的表現更加優異。

據評估結果顯示,OSUM 在多項任務上優於 Qwen2-Audio 模型,即使在計算資源和訓練數據方面明顯較少。相關的評估結果不僅涵蓋了公共測試集,還包括內部測試集,展示了 OSUM 模型在語音理解任務上的良好性能。

西北工業大學 ASLP 實驗室表示,OSUM 的目標是通過開放的研究平臺,促進先進語音理解技術的發展。科研人員和開發者可自由使用該模型的代碼和權重,甚至可用於商業目的,從而加速技術的應用與推廣。

項目入口:https://github.com/ASLP-lab/OSUM?tab=readme-ov-file

劃重點:

🌟 OSUM 模型結合 Whisper 編碼器與 Qwen2語言模型,支持多種語音任務,助力多任務學習。

📊 OSUM 在技術報告 v2.0中,訓練數據量增至50.5K 小時,提升了模型的性能。

🆓 該模型的代碼和權重在 Apache2.0許可下開放使用,鼓勵學術界和工業界的廣泛應用。