近日,微軟研究院聯合華盛頓大學、斯坦福大學、南加州大學、加利福尼亞大學戴維斯分校以及加利福尼亞大學舊金山分校的研究人員共同推出了 LLaVA-Rad,這是一種新型的小型多模態模型(SMM),旨在提升臨牀放射學報告的生成效率。該模型的推出不僅標誌着醫學圖像處理技術的一大進步,也爲放射學的臨牀應用帶來了更多的可能性。

在生物醫學領域,基於大規模基礎模型的研究已經展現出良好的應用前景,尤其是在多模態生成 AI 的發展下,可以同時處理文本與圖像,從而支持視覺問答和放射學報告生成等任務。然而,目前仍然存在諸多挑戰,例如大模型的資源需求過高,難以在臨牀環境中廣泛部署。小型多模態模型雖然在效率上有所提高,但與大型模型相比,性能仍存在顯著差距。此外,缺乏開放源代碼模型以及可靠的事實準確性評估方法也使得臨牀應用受到限制。

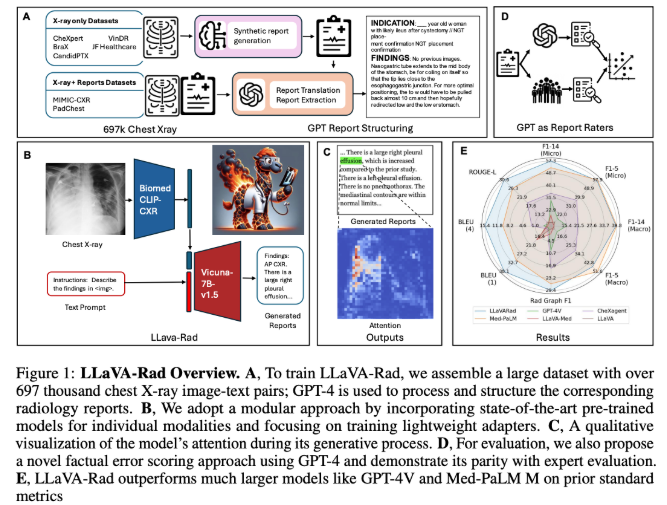

LLaVA-Rad 模型的訓練基於來自七個不同來源的697,435對放射學圖像與報告的數據集,專注於胸部 X 光(CXR)成像,這是最常見的醫學影像檢查類型。該模型的設計採用了一種模塊化的訓練方式,包括單模態預訓練、對齊和微調三個階段,利用高效的適配器機制將非文本模態嵌入文本嵌入空間。儘管 LLaVA-Rad 的規模小於一些大型模型,如 Med-PaLM M,但在性能上卻表現優異,尤其是在 ROUGE-L 和 F1-RadGraph 等關鍵指標上,相較於其他同類模型提升了12.1% 和10.1%。

值得一提的是,LLaVA-Rad 在多個數據集上均保持了優越的性能,即便是在未見過的數據測試中也表現穩定。這一切都歸功於其模塊化設計和高效的數據利用架構。此外,研究團隊還推出了 CheXprompt,一個用於自動評分事實正確性的指標,進一步解決了臨牀應用中的評估難題。

LLaVA-Rad 的發佈,無疑是推動基礎模型在臨牀環境中應用的一大步,爲放射學報告生成提供了一種輕量級且高效的解決方案,標誌着技術與臨牀需求之間的進一步融合。

項目地址:https://github.com/microsoft/LLaVA-Med

劃重點:

🌟 LLaVA-Rad 是微軟研究團隊推出的小型多模態模型,專注於放射學報告的生成。

💻 該模型經過697,435對胸部 X 光圖像與報告的訓練,實現了高效且優越的性能。

🔍 CheXprompt 是配套推出的自動評分指標,幫助解決臨牀應用中的評估難題。