隨着視頻技術的快速發展,視頻已成爲信息檢索和理解複雜概念的重要工具。視頻結合了視覺、時間和上下文數據,提供了超越靜態圖像和文本的多模態表現。如今,隨着視頻分享平臺的普及和大量教育及信息視頻的涌現,利用視頻作爲知識源爲解決需要詳細背景、空間理解和過程演示的查詢提供了前所未有的機會。

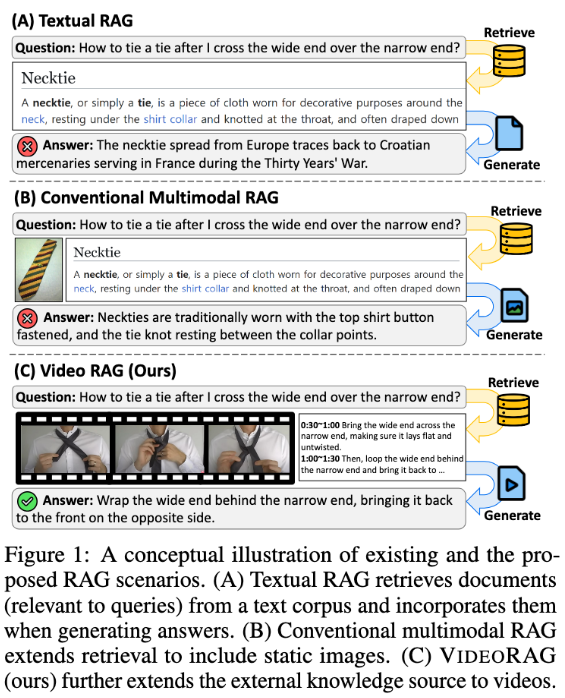

然而,現有的檢索增強生成(RAG)系統往往忽視了視頻數據的全部潛力。這些系統通常依賴文本信息,偶爾使用靜態圖像來支持查詢響應,卻未能捕捉視頻所包含的視覺動態和多模態線索,這對於複雜任務至關重要。傳統方法要麼在沒有檢索的情況下預定義查詢相關視頻,要麼將視頻轉化爲文本格式,從而失去重要的視覺上下文和時間動態,限制了提供準確和信息豐富的答案的能力。

爲了解決這些問題,來自韓國科學技術院(KaIST)和 DeepAuto.ai 的研究團隊提出了一種新穎的框架 ——VideoRAG。該框架能夠動態檢索與查詢相關的視頻,並將視覺和文本信息整合到生成過程中。VideoRAG 利用先進的大型視頻語言模型(LVLMs)實現多模態數據的無縫集成,確保檢索到的視頻與用戶查詢的上下文一致,並保持視頻內容的時間豐富性。

VideoRAG 的工作流程分爲兩個主要階段:檢索和生成。在檢索階段,框架通過查詢識別與其視覺和文本特徵相似的視頻。

在生成階段,利用自動語音識別技術爲沒有字幕的視頻生成輔助文本數據,從而確保所有視頻的響應生成都能有效貢獻信息。相關的檢索視頻進一步輸入生成模塊,整合視頻幀、字幕和查詢文本等多模態數據,藉助 LVLMs 處理,從而生成長篇且豐富、準確、上下文恰當的響應。

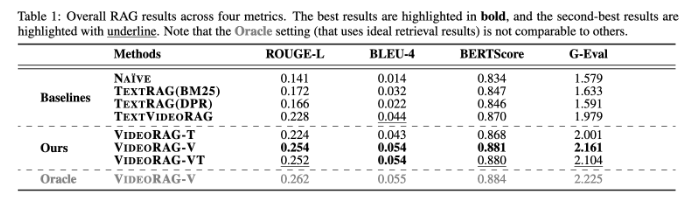

VideoRAG 在 WikiHowQA 和 HowTo100M 等數據集上進行了廣泛實驗,結果顯示其響應質量明顯優於傳統方法。這一新框架不僅提升了檢索增強生成系統的能力,也爲未來的多模態檢索系統設定了新的標準。

論文:https://arxiv.org/abs/2501.05874

劃重點:

📹 ** 新框架 **:VideoRAG 動態檢索相關視頻,將視覺和文本信息融合以提升生成效果。

🔍 ** 實驗驗證 **:在多個數據集上測試,顯示出明顯優於傳統 RAG 方法的響應質量。

🌟 ** 技術革新 **:利用大型視頻語言模型,VideoRAG 開啓了多模態數據整合的新篇章。