ビデオ技術の急速な発展に伴い、ビデオは情報検索や複雑な概念の理解において重要なツールとなっています。ビデオは視覚、時間、コンテキストデータを組み合わせ、静止画やテキストを超えたマルチモーダル表現を提供します。現在、ビデオ共有プラットフォームの普及と教育や情報ビデオの大量出現により、詳細な背景、空間的理解、プロセスのデモンストレーションを必要とするクエリ解決のために、ビデオを知識源として活用する前例のない機会が生まれています。

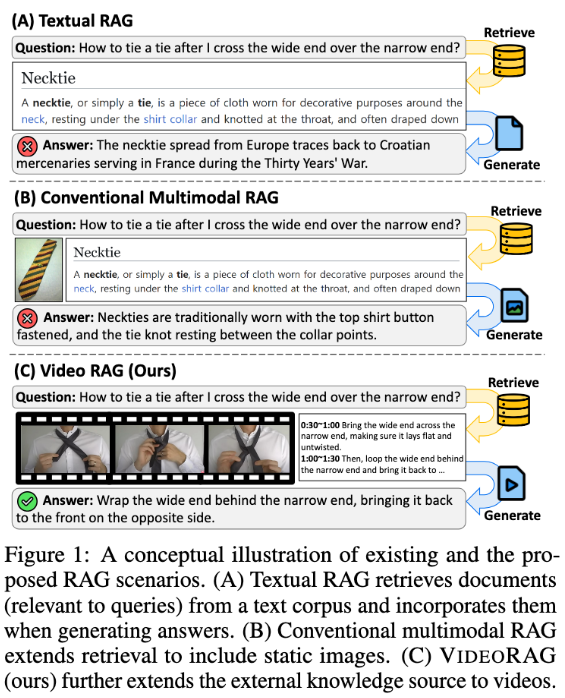

しかし、既存の検索強化生成(RAG)システムは、ビデオデータの可能性を十分に活用できていません。これらのシステムは通常、テキスト情報に依存し、クエリ応答をサポートするために静止画を使用することもありますが、複雑なタスクに不可欠なビデオに含まれる視覚的なダイナミクスとマルチモーダルな手がかりを捉えることができていません。従来の方法では、検索なしでクエリ関連のビデオを事前に定義するか、ビデオをテキスト形式に変換するため、重要な視覚的コンテキストと時間的ダイナミクスが失われ、正確で情報量の多い回答を提供する能力が制限されていました。

これらの問題を解決するために、韓国科学技術院(KAIST)とDeepAuto.aiの研究チームは、新しいフレームワークであるVideoRAGを提案しました。このフレームワークは、クエリに関連するビデオを動的に検索し、視覚情報とテキスト情報を生成プロセスに統合することができます。VideoRAGは、高度な大規模ビデオ言語モデル(LVLMs)を活用してマルチモーダルデータのシームレスな統合を実現し、検索されたビデオがユーザークエリのコンテキストと一致し、ビデオコンテンツの時間的な豊かさが維持されるようにします。

VideoRAGのワークフローは、検索と生成の2つの主要な段階に分かれています。検索段階では、フレームワークはクエリを使用して、その視覚的およびテキスト的特徴に類似したビデオを識別します。

生成段階では、自動音声認識技術を使用して字幕のないビデオの補助テキストデータを生成することにより、すべてのビデオの応答生成が効果的に情報を提供できるようにします。関連する検索ビデオはさらに生成モジュールに入力され、ビデオフレーム、字幕、クエリテキストなどのマルチモーダルデータを統合し、LVLMsを使用して処理することで、長文で豊富で正確かつコンテキストに適切な応答を生成します。

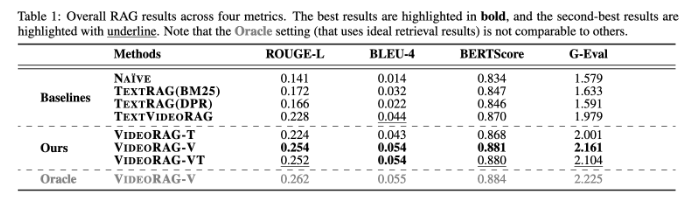

VideoRAGは、WikiHowQAやHowTo100Mなどのデータセットで広範な実験が行われ、その応答品質が従来の方法よりも明らかに優れていることが示されました。この新しいフレームワークは、検索強化生成システムの能力を高めるだけでなく、将来のマルチモーダル検索システムの新たな基準を設定します。

論文:https://arxiv.org/abs/2501.05874

要点:

📹 ** 新しいフレームワーク**: VideoRAGは関連するビデオを動的に検索し、視覚情報とテキスト情報を融合して生成効果を高めます。

🔍 ** 実験検証**: 複数のデータセットでテストされ、従来のRAG手法よりも明らかに優れた応答品質を示しました。

🌟 ** 技術革新**: 大規模ビデオ言語モデルを利用して、VideoRAGはマルチモーダルデータ統合の新時代を開きました。