近日,字節跳動發佈了名爲 LatentSync 的新型口型同步框架,旨在利用音頻條件潛在擴散模型實現更精確的口型同步。該框架基於Stable Diffusion,針對時間一致性做了優化。

與以往的基於像素空間擴散或兩階段生成的方法不同,LatentSync 採用端到端的方式,無需中間運動表示,能夠直接建模複雜的音頻與視覺之間的關係。

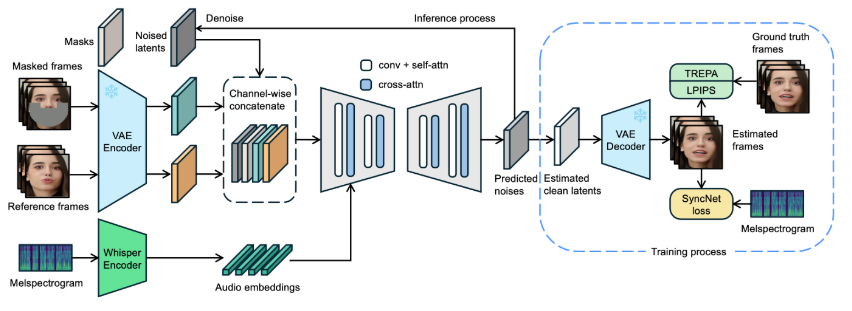

在 LatentSync 的框架中,首先使用 Whisper 將音頻頻譜圖轉換爲音頻嵌入,並通過交叉注意力層將其集成到 U-Net 模型中。框架通過將參考幀和掩碼幀與噪聲潛在變量進行通道級拼接,作爲 U-Net 的輸入。

在訓練過程中,採用一步法從預測噪聲中估計出乾淨的潛在變量,然後進行解碼以生成乾淨的幀。同時,模型引入了 Temporal REPresentation Alignment(TREPA)機制,以增強時間一致性,確保生成的視頻在口型同步準確性的同時,能夠在時間上保持連貫。

爲了展示該技術的效果,項目提供了一系列示例視頻,分別展示了原始視頻與經過口型同步處理後的視頻。通過示例,用戶可以直觀地感受到 LatentSync 在視頻口型同步方面的顯著進步。

原始視頻:

輸出視頻:

此外,項目還計劃開源推理代碼和檢查點,方便用戶進行訓練和測試。對於想要嘗試推理的用戶,只需下載必要的模型權重文件,即可進行操作。完整的數據處理流程也已設計好,涵蓋了從視頻文件處理到面部對齊的各個步驟,確保用戶能夠輕鬆上手。

模型項目入口:https://github.com/bytedance/LatentSync

劃重點:

🌟 LatentSync 是一個基於音頻條件潛在擴散模型的端到端口型同步框架,無需中間運動表示。

🎤 該框架利用 Whisper 將音頻頻譜圖轉換爲嵌入,增強了模型在口型同步過程中的準確性和時間一致性。

📹 項目提供了一系列示例視頻,並計劃開源相關代碼和數據處理流程,方便用戶使用和訓練。