非營利性 AI 研究機構 Ai2近日發佈了其於全新的OLMo2系列,這是該機構推出的“開放語言模型”(OLMo)系列的第二代模型。OLMo2的發佈不僅爲AI社區提供了強大的技術支持,更以其完全開放源代碼的特性,代表了開源AI的最新發展。

與目前市場上其他“開放”語言模型如Meta的Llama系列不同,OLMo2符合開放源代碼倡議的嚴格定義,這意味着用於其開發的訓練數據、工具和代碼都是公開的,任何人都可以訪問和使用。根據開放源代碼促進會的定義,OLMo2滿足了該機構對“開源AI”標準的要求,這一標準於今年10月最終確定。

Ai2在其博客中提到,OLMo2的開發過程中,所有的訓練數據、代碼、訓練方案、評估方法以及中間檢查點都完全開放,旨在通過共享資源,推動開源社區的創新與發現。“通過公開分享我們的數據、方案和發現,我們希望爲開源社區提供發現新方法和創新技術的資源。”Ai2表示。

OLMo2系列包括兩個版本:一個是70億參數的OLMo7B,另一個是130億參數的OLMo13B。參數的數量直接影響模型的表現,參數更多的版本通常能處理更復雜的任務。在常見的文本任務中,OLMo2表現出色,能夠完成諸如回答問題、總結文檔和編寫代碼等任務。

圖源備註:圖片由AI生成,圖片授權服務商Midjourney

爲訓練OLMo2,Ai2使用了包含五萬億個token的數據集。Token是語言模型中最小的單位,100萬個token大約等於75萬個單詞。訓練數據包括來自高質量網站、學術論文、問答討論板以及合成數學練習冊的內容,這些數據經過精心篩選,以確保模型的高效性和準確性。

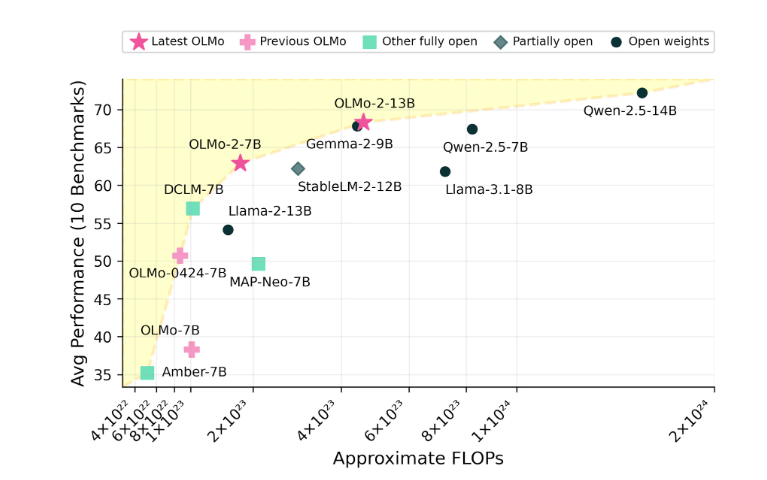

Ai2對OLMo2的表現充滿信心,聲稱其在性能上已與Meta的Llama3.1等開源模型競爭。Ai2指出,OLMo27B的表現甚至超越了Llama3.18B,成爲目前最強的完全開放語言模型之一。所有OLMo2模型及其組件均可通過Ai2官網免費下載,並遵循Apache2.0許可,意味着這些模型不僅可以用於研究,也可以用於商業應用。