近日,研究團隊發佈了名爲 HelloMeme 的框架,可以超還原的將畫面中一個人的表情遷移到另外一個畫面中人物的表情上圖片上。

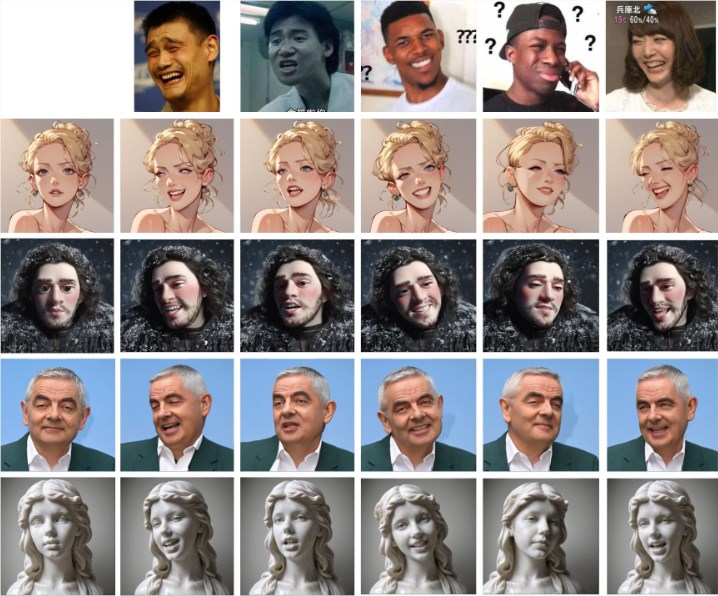

如下圖,給出一個表情圖片(第一行),就可將表情細節遷移到其它圖片人物形象上面。

HelloMeme 的核心在於其獨特的網絡結構。該框架能夠從駕駛視頻中提取每一幀的特徵,並將這些特徵輸入 HMControlModule。通過這樣的處理,研究人員可以生成流暢的視頻畫面。然而,在初步生成的視頻中,幀與幀之間存在閃爍的問題,影響了整體觀看體驗。爲了解決這一問題,團隊引入了 Animatediff 模塊,這一創新顯著提高了視頻的連續性,但也在一定程度上降低了畫面的保真度。

針對這一矛盾,研究人員對 Animatediff 模塊進行了進一步的優化調整,最終實現了在提升視頻連續性的同時保持較高的畫質。

此外,HelloMeme 框架還爲面部表情編輯提供了強大的支持。通過綁定 ARKit Face Blendshapes,用戶可以輕鬆控制生成的視頻中角色的面部表情。這種靈活性使得創作者可以根據需要生成具有特定情感和表現的視頻,極大地豐富了視頻內容的表現力。

在技術兼容性方面,HelloMeme 採用了一種基於 SD1.5的熱插拔適配器設計。這一設計的最大優勢在於,不會影響 T2I(文本到圖像)模型的泛化能力,允許在 SD1.5基礎上開發的任何風格化模型與 HelloMeme 無縫集成。這爲各種創作提供了更多的可能性。

研究團隊發現,HMReferenceModule 的引入使得生成視頻時的保真度條件顯著提升,這意味着在生成高質量視頻的同時,可以減少採樣步驟。這一發現不僅提高了生成效率,也爲實時視頻生成打開了新的大門。

與其他方法的比較效果如下,很明顯HelloMeme的表情遷移效果更爲自然和接近原表情效果。

項目入口:https://songkey.github.io/hellomeme/

https://github.com/HelloVision/ComfyUI_HelloMeme

劃重點:

🌐 HelloMeme 通過獨特的網絡結構和 Animatediff 模塊,實現了視頻生成的流暢性與畫質的雙重提升。

🎭 框架支持 ARKit Face Blendshapes,使用戶能夠靈活控制角色面部表情,豐富視頻內容的表現。

⚙️ 採用熱插拔適配器設計,確保與 SD1.5基礎上的其他模型兼容,爲創作提供更大的靈活性。