在 AI 的世界裏,數據就像是金礦,越豐富越閃亮。最近,LLM360推出了一個令人矚目的數據集 TxT360,專爲大語言模型訓練量身定做。這個龐然大物不僅收錄了來自各行各業的高質量文本數據,更是經歷了一場全球範圍的去重大作戰,最終匯聚成5.7萬億個優質 tokens,真可謂是 “數據界的百寶箱”!

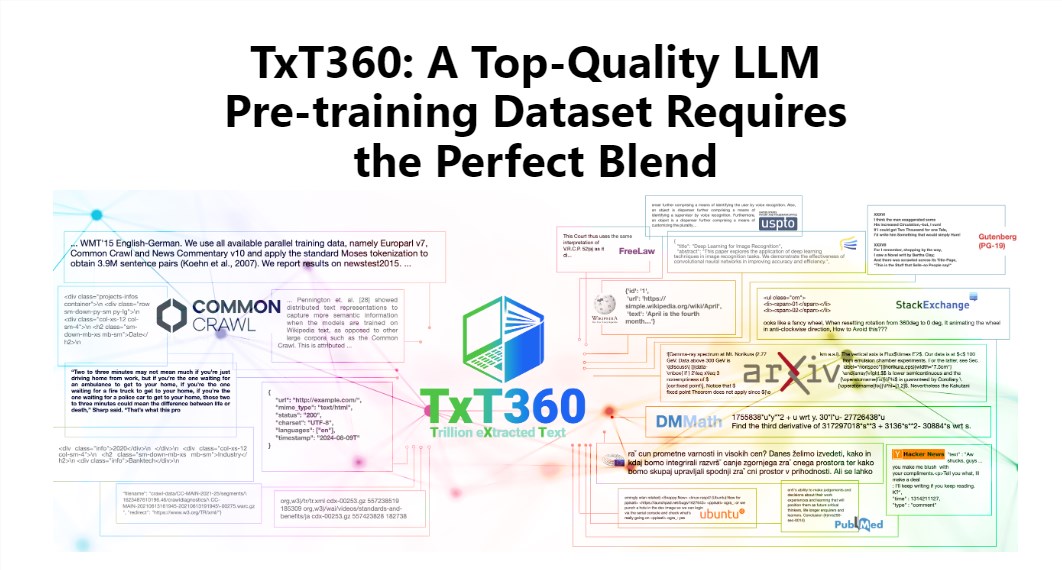

TxT360的魅力在於其超大的規模和超高的質量,完勝現有的 FineWeb 和 RedPajama 等數據集。這份數據集從99個 Common Crawl 快照中抓取了互聯網的精華,同時還特別挑選了14個高質量的數據源,比如法律文檔和百科全書,讓它的內容不僅豐富多樣,還相當靠譜。

更酷的是,TxT360給用戶提供了一種 “數據權重調整配方”,讓你可以根據自己的需求靈活調整不同數據源的權重。這就好比在烹飪時,你可以根據口味隨意調配各種材料,確保每一口都美味無比。

當然,去重技術也是 TxT360的一大亮點。通過複雜的去重操作,這個數據集有效地解決了訓練過程中的數據冗餘和信息重複問題,確保每一個 token 都是獨一無二的。同時,項目組還通過正則表達式手段,聰明地移除了文檔中的個人身份信息,比如電子郵件和 IP 地址,從而確保數據的隱私和安全性。

TxT360的設計不僅關注規模,還兼顧了質量。結合網絡數據和精選數據源的優勢,它讓研究人員能夠精確控制數據的使用和分佈,就像是擁有了一個操控魔法的遙控器,可以隨意調整數據的比例。

在訓練效果方面,TxT360也不甘示弱。它通過簡單的上採樣策略,使得數據量大增,最終創造出一個超過15萬億 tokens 的數據集。在一系列關鍵評估指標上,TxT360的表現都優於 FineWeb,尤其在 MMLU 和 NQ 等領域,顯示了超強的學習能力。而結合代碼數據(如 Stack V2)後,學習曲線更加穩定,模型性能也有了明顯提升。

詳細介紹:https://huggingface.co/spaces/LLM360/TxT360