AIの世界では、データはまさに金鉱です。豊富であればあるほど、輝きを増します。最近、LLM360は、大規模言語モデルのトレーニングのために特注された注目すべきデータセット、TxT360を発表しました。この巨大なデータセットは、あらゆる業界から収集された高品質のテキストデータを含むだけでなく、世界規模の重複排除処理を経て、5.7兆個もの高品質なトークンを集約しました。まさに「データの宝箱」と言えるでしょう!

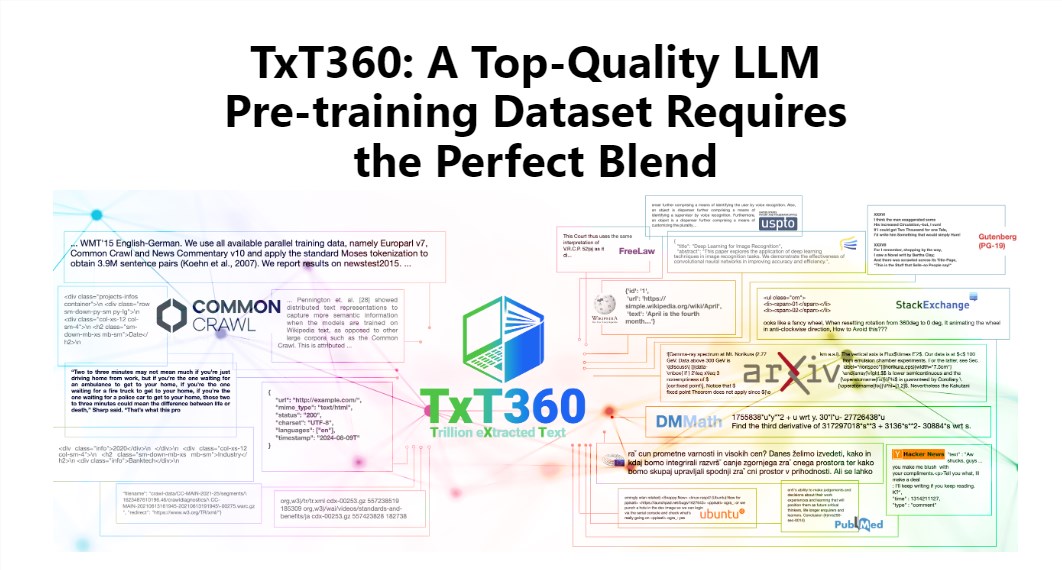

TxT360の魅力は、その巨大な規模と非常に高い品質にあります。既存のFineWebやRedPajamaなどのデータセットをはるかに凌駕しています。このデータセットは、99個のCommon Crawlスナップショットからインターネットのエッセンスを抽出し、さらに法律文書や百科事典など、14個の高品質なデータソースを厳選することで、コンテンツの豊富さと信頼性を両立させています。

さらに素晴らしいことに、TxT360はユーザーに「データウェイト調整レシピ」を提供しており、ニーズに合わせて様々なデータソースのウェイトを柔軟に調整できます。料理に例えるなら、自分の好みに合わせて材料を自由に調整し、一口ごとに最高の味を堪能できるようなものです。

もちろん、重複排除技術もTxT360の大きな特徴です。複雑な重複排除処理により、トレーニング過程におけるデータの冗長性と情報重複の問題を効果的に解決し、各トークンの一意性を確保しています。同時に、プロジェクトチームは正規表現を用いて、メールアドレスやIPアドレスなどの個人情報を含むドキュメントを巧みに削除することで、データのプライバシーとセキュリティを確保しています。

TxT360のデザインは、規模だけでなく品質にも配慮しています。ウェブデータと厳選されたデータソースの長所を組み合わせることで、研究者はデータの使用と分布を正確に制御できます。まるで魔法の杖を操るリモコンを持っているかのように、データの比率を自由に調整できます。

トレーニング効果においても、TxT360は引けを取りません。単純なアップサンプリング戦略により、データ量が大幅に増加し、最終的に15兆個を超えるトークンを含むデータセットが作成されました。いくつかの重要な評価指標において、TxT360はFineWebを上回り、特にMMLUやNQなどの分野では、非常に高い学習能力を示しました。さらに、コードデータ(Stack V2など)を組み合わせることで、学習曲線がより安定し、モデルのパフォーマンスも大幅に向上しました。