最近,Zyphra 公司發佈了全新的 Zamba2-2.7B 語言模型,這一發布在小型語言模型的發展史上具有重要意義。新模型在性能和效率方面取得了顯著提升,它的訓練數據集達到了大約3萬億個標記,這使得它在性能上可以與 Zamba1-7B 及其他領先的7B 模型相媲美。

而最令人驚喜的是,Zamba2-2.7B 在推理時的資源需求顯著降低,成爲了移動設備應用的高效解決方案。

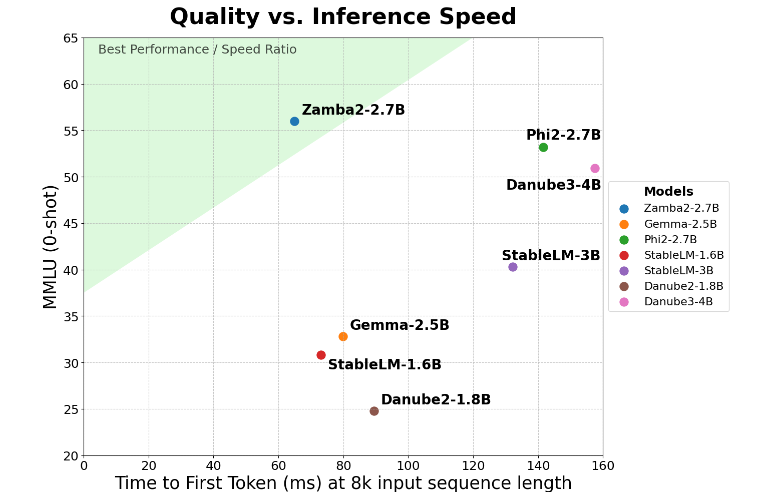

Zamba2-2.7B 在 “首次生成響應時間” 這一關鍵指標上實現了兩倍的提升,這意味着它可以比競爭對手更快地生成初始響應。這對於虛擬助手、聊天機器人等需要實時互動的應用來說至關重要。

除了速度的提升,Zamba2-2.7B 在內存使用上也做得非常出色。它減少了27% 的內存開銷,使得它成爲在內存資源有限的設備上部署的理想選擇。這樣的智能內存管理確保了模型在計算資源受限的環境中也能有效運行,擴展了其在各種設備和平臺上的應用範圍。

Zamba2-2.7B 還有一個顯著的優勢,那就是生成延遲更低。與 Phi3-3.8B 相比,它的延遲降低了1.29倍,這使得交互更加流暢。低延遲在需要無縫、持續交流的應用中尤爲重要,比如客服機器人和互動教育工具。因此,Zamba2-2.7B 在提升用戶體驗方面無疑是開發者的首選。

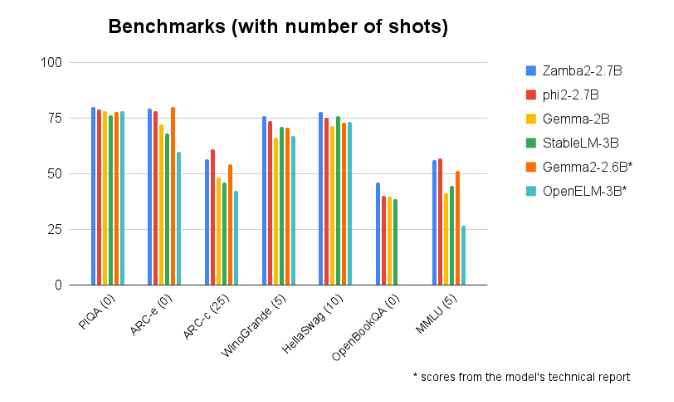

在與其他同類規模模型的基準比較中,Zamba2-2.7B 始終表現優異。它的優越表現證明了 Zyphra 在推動人工智能技術發展上的創新和努力。這一模型採用了改進的交錯共享注意力機制,並配備了 LoRA 投影器在共享的 MLP 模塊上,確保了在處理複雜任務時的高效能輸出。

模型入口:https://huggingface.co/Zyphra/Zamba2-2.7B

劃重點:

🌟 Zamba2-27B 模型在首次響應時間上提升至原來的兩倍,適合實時互動應用。

💾 該模型減少了27% 的內存開銷,適合資源有限的設備。

🚀 在生成延遲上,Zamba2-2.7B 表現優於同類模型,提升了用戶體驗。