最近、Zyphra社は、小型言語モデルの発展において画期的な新言語モデル「Zamba2-2.7B」を発表しました。このモデルは、性能と効率において著しい向上を遂げており、約3兆トークンのデータセットでトレーニングされました。その性能は、Zamba1-7Bや他の主要な7Bモデルに匹敵します。

最も驚くべき点は、Zamba2-2.7Bの推論時のリソース消費量が大幅に削減され、モバイル機器への応用が容易になったことです。

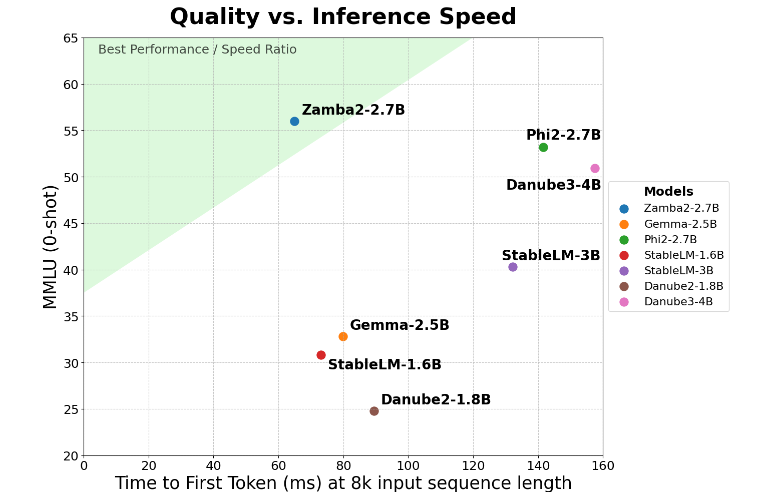

Zamba2-2.7Bは、「初回応答時間」という重要な指標において、2倍の向上を実現しました。これは、競合他社よりも速く初期応答を生成できることを意味し、仮想アシスタントやチャットボットなど、リアルタイムのインタラクションが必要なアプリケーションにとって非常に重要です。

速度の向上に加え、Zamba2-2.7Bはメモリ使用量も非常に優れています。メモリ消費量が27%削減されたため、メモリリソースが限られたデバイスへの展開に最適です。このスマートなメモリ管理により、計算リソースが制限された環境でも効率的に動作し、様々なデバイスやプラットフォームでの適用範囲が広がります。

Zamba2-2.7Bのもう一つの大きな利点は、生成遅延の低さです。Phi3-3.8Bと比較して、遅延が1.29倍低減されました。これにより、インタラクションがよりスムーズになります。低遅延は、シームレスで継続的なコミュニケーションが必要なカスタマーサービスロボットやインタラクティブな教育ツールなどのアプリケーションで特に重要です。そのため、Zamba2-2.7Bは、ユーザーエクスペリエンスの向上を目指す開発者にとって最適な選択肢と言えるでしょう。

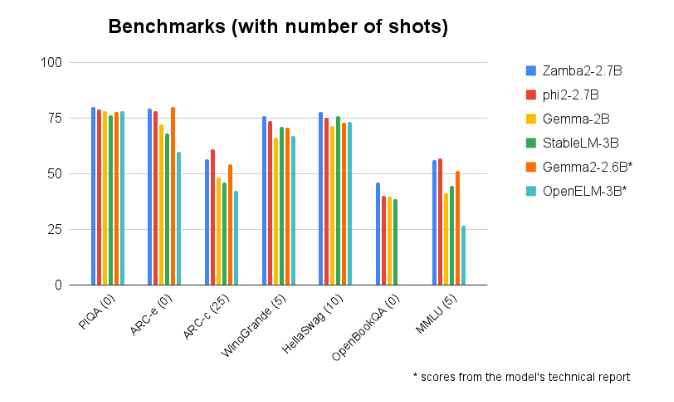

他の同規模モデルとのベンチマーク比較でも、Zamba2-2.7Bは常に優れたパフォーマンスを示しています。その優れた性能は、Zyphra社の人工知能技術開発における革新と努力の証です。このモデルは、改良されたインタリーブ共有アテンションメカニズムを採用し、共有MLPモジュール上にLoRAプロジェクターを搭載することで、複雑なタスク処理においても高効率な出力を実現しています。

モデルへのアクセス:https://huggingface.co/Zyphra/Zamba2-2.7B

重要なポイント:

🌟 Zamba2-2.7Bモデルは、初回応答時間が従来の2倍に向上し、リアルタイムインタラクションが必要なアプリケーションに最適です。

💾 メモリ消費量が27%削減され、リソースの少ないデバイスにも適しています。

🚀 生成遅延において、Zamba2-2.7Bは同等のモデルを上回り、ユーザーエクスペリエンスを向上させます。