最近,新加坡國立大學的Wenyi Yu及其團隊提出了一項名爲video-SALMONN的新技術,它不僅能夠理解視頻中的視覺幀序列、音頻事件和音樂,更重要的是,它能夠理解視頻中的語音內容。這項技術的提出標誌着我們在讓機器理解視頻內容方面邁出了重要一步。

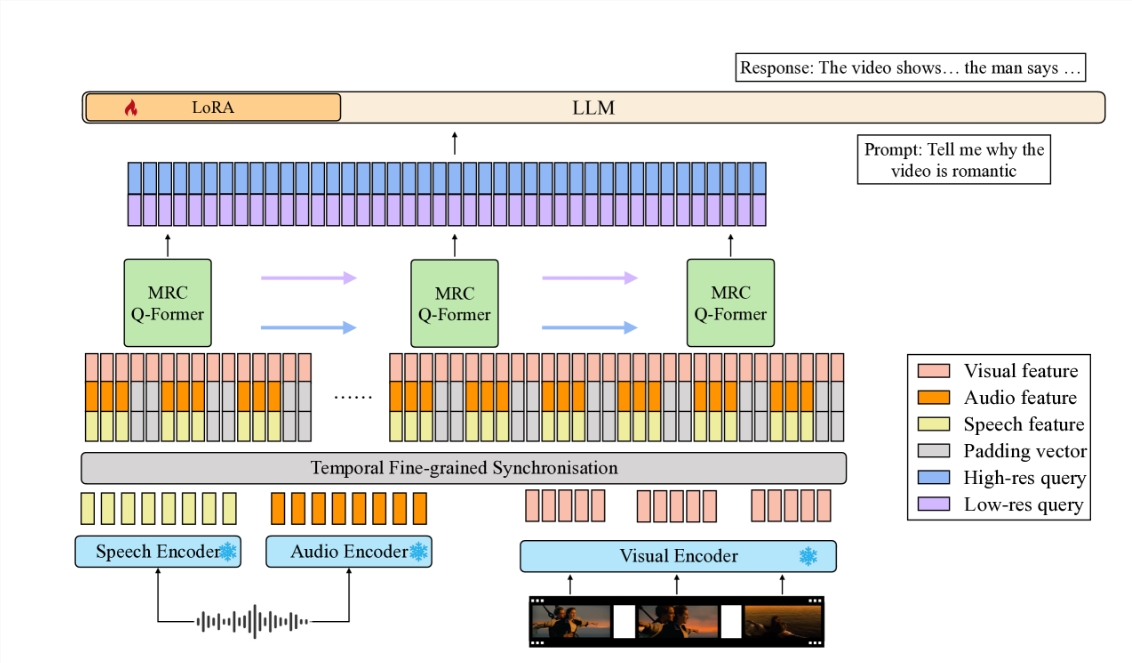

視頻-SALMONN是一種端到端的音頻-視覺大型語言模型(av-LLM),它通過一種新穎的多分辨率因果Q-Former(MRC Q-Former)結構,將預訓練的音視頻編碼器與大型語言模型的主體連接起來。這種結構不僅能夠捕捉到語音理解所需的細粒度時間信息,同時也保證了對其他視頻元素的高效處理。

爲了提高模型對不同視頻元素的平衡處理,研究團隊提出了專門的訓練方法,包括多樣性損失和未配對音視頻混合訓練策略,以避免視頻幀或模態的主導。

在新引入的語音-音頻-視覺評估基準(SAVE)上,視頻-SALMONN在視頻問答(video-QA)任務上取得了超過25%的絕對準確率提升,在涉及人類語音的音視頻問答任務上取得了超過30%的絕對準確率提升。此外,視頻-SALMONN在其他av-LLMs前所未有的任務上展示了卓越的視頻理解與推理能力。

視頻-SALMONN的核心是多分辨率因果(MRC)Q-Former結構,它在三個不同的時間尺度上對同步的音視頻輸入特徵與文本表示空間進行對齊,滿足不同任務對不同視頻元素的依賴需求。此外,爲了加強連續視頻幀之間的時間因果關係,MRC Q-Former中包含了具有特殊因果掩碼的因果自注意力結構。

視頻-SALMONN的提出,不僅爲學術界帶來了新的研究工具,也爲實際應用提供了廣闊的可能性。它使得技術與人類的交互變得更加自然和直觀,降低了用戶尤其是兒童和老年人學習使用技術的難度。同時,它還有潛力提高包括運動障礙人士在內的技術的可訪問性。

視頻-SALMONN的提出,是朝着實現通用人工智能(AGI)邁出的重要一步。通過整合語音輸入以及現有的非語音音頻和視覺輸入,這樣的模型將獲得對人類交互和環境的全面理解,從而能夠應用到更廣泛的領域。

這項技術的發展,無疑將爲視頻內容的分析、教育應用、以及提升人們的生活質量帶來深遠的影響。隨着技術的不斷進步,我們有理由相信,未來的AI將更加智能,更加貼近人類的需求。

論文地址:https://arxiv.org/html/2406.15704v1