最近、シンガポール国立大学のWenyi Yu氏らのチームが、video-SALMONNという新技術を発表しました。これは、ビデオ内の視覚フレームシーケンス、音声イベント、音楽だけでなく、音声内容も理解できる技術です。この技術は、機械によるビデオ内容の理解において重要な一歩を踏み出したことを意味します。

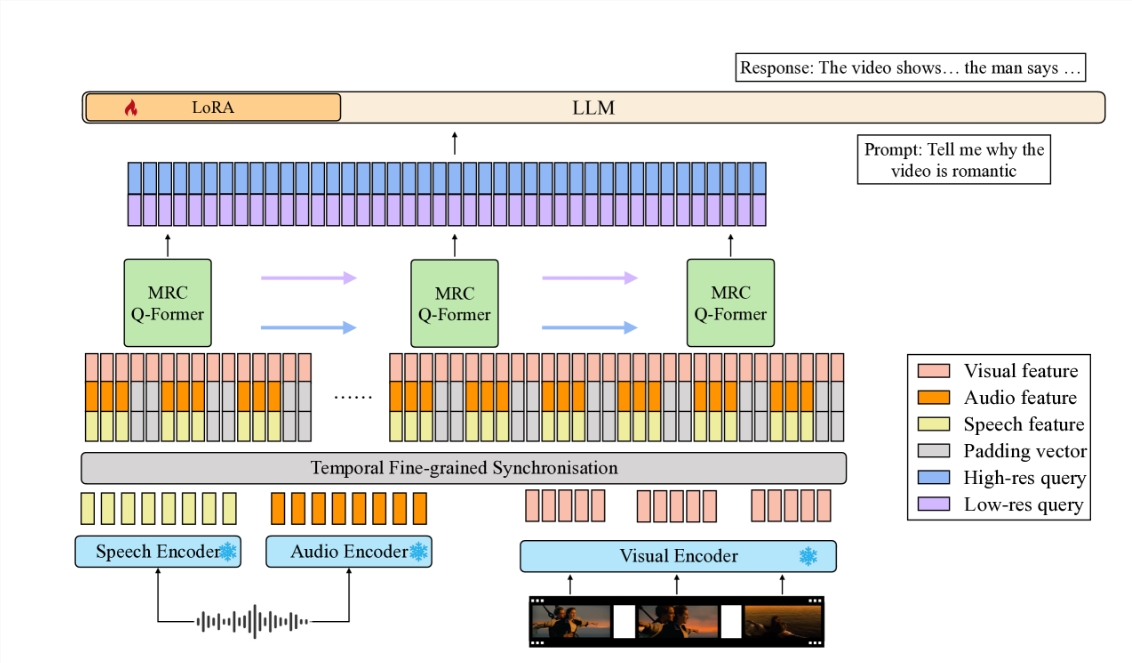

video-SALMONNは、エンドツーエンドの音声・視覚大型言語モデル(av-LLM)であり、新規の多解像度因果Q-Former(MRC Q-Former)構造によって、事前学習済みの音声・ビデオエンコーダと大型言語モデルの本体を接続しています。この構造は、音声理解に必要な細粒度の時間情報を捉えるだけでなく、他のビデオ要素の効率的な処理も保証します。

異なるビデオ要素のバランスのとれた処理を向上させるため、研究チームは、ビデオフレームやモダリティの支配を避けるため、多様性損失と非対の音声・ビデオ混合訓練戦略を含む、専用の訓練方法を提案しました。

新しく導入された音声・音声・視覚評価基準(SAVE)において、video-SALMONNは、ビデオ質問応答(video-QA)タスクで25%以上の絶対精度向上を達成し、人間の音声を含む音声・ビデオ質問応答タスクでは30%以上の絶対精度向上を達成しました。さらに、video-SALMONNは、他のav-LLMでは前例のないタスクにおいて、優れたビデオ理解と推論能力を示しました。

video-SALMONNの中核は、多解像度因果(MRC)Q-Former構造です。これは、同期した音声・ビデオ入力特徴とテキスト表現空間を3つの異なる時間スケールで整列させ、異なるタスクが異なるビデオ要素に依存するニーズを満たします。さらに、連続するビデオフレーム間の時間的因果関係を強化するために、MRC Q-Formerには、特別な因果マスクを持つ因果的自己注意機構が含まれています。

video-SALMONNの発表は、学術界に新たな研究ツールをもたらすだけでなく、実用化の可能性も広げます。これにより、技術と人間のインタラクションがより自然で直感的になり、特に子供や高齢者にとって技術の学習が容易になります。同時に、運動障害のある方々を含む、技術へのアクセシビリティ向上にも貢献する可能性があります。

video-SALMONNの発表は、汎用人工知能(AGI)の実現に向けた重要な一歩です。音声入力と既存の非音声オーディオおよび視覚入力を統合することにより、このようなモデルは人間とのインタラクションと環境を包括的に理解し、より幅広い分野に応用できるようになります。

この技術の発展は、ビデオコンテンツの分析、教育用途、そして人々の生活の質の向上に大きな影響を与えるでしょう。技術の進歩に伴い、将来のAIはよりスマートで、人間のニーズにより近づくと確信しています。