繼昨天Meta宣佈發佈最強開源模型Llama3.1之後,Mistral AI在今天凌晨 隆重推出了其旗艦模型 Mistral Large2,這一新產品有 1230億個參數,擁有超大的128k 上下文窗口,與從這方面來看可以媲美Llama3.1。

Mistral Large2模型詳情

Mistral Large2具有128k 上下文窗口,支持法語、德語、西班牙語、意大利語、葡萄牙語、阿拉伯語、印地語、俄語、中文、日語和韓語等數十種語言,以及 Python、Java、C、C++、JavaScript 和 Bash 等80多種編碼語言。

Mistral Large2專爲單節點推理而設計,主要針對長上下文應用 - 其1230億個參數的大小使其能夠在單個節點上以大吞吐量運行。Mistral Large2根據 Mistral 研究許可證發佈,旨在用於研究和非商業用途;若有商業需求,用戶需要聯繫以獲取商業許可證。

整體表現:

在性能方面,Mistral Large2在評估指標上建立了新的標杆,尤其是在 MMLU 基準測試中實現了84.0% 的準確率,展現出強大的性能與服務成本的平衡。

代碼與推理

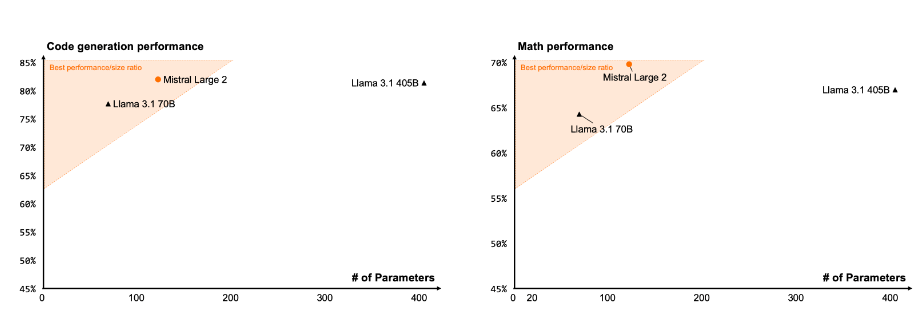

通過對 Codestral22B 和 Codestral Mamba 的訓練經驗,Mistral Large2在代碼處理上表現優異,甚至與 GPT-4o、Claude3Opus 和 Llama3405B 等頂尖模型相媲美。

指令遵循與對齊

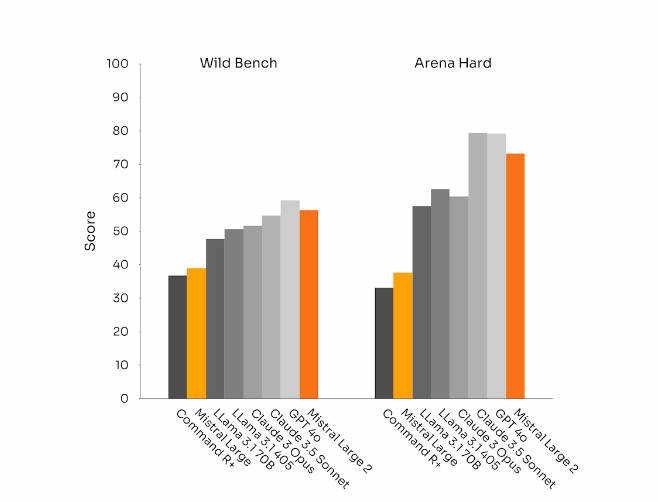

Mistral Large2在指令遵循和對話能力上也取得了顯著進展,尤其是在處理複雜、多輪的對話時更加靈活。在某些基準測試中,生成較長的響應往往會提高分數。然而,在許多商業應用中,簡潔性至關重要——較短的模型生成有助於加快交互速度,並且推理更具成本效益。

語言多樣性

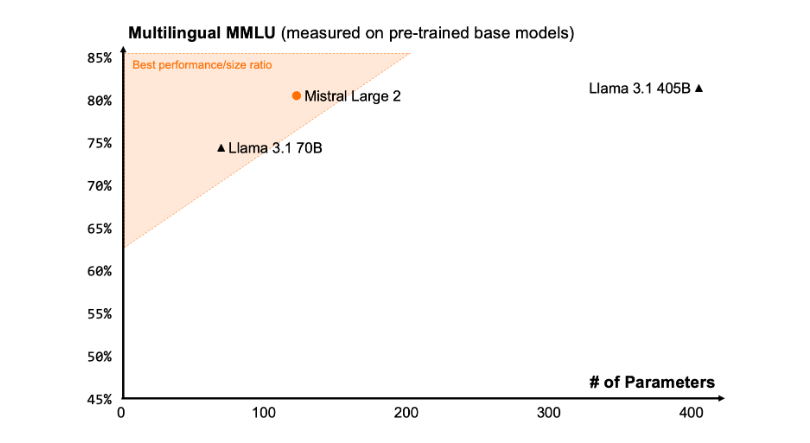

新的 Mistral Large2是在大量多語言數據上進行訓練的,特別是在英語、法語、德語、西班牙語、意大利語、葡萄牙語、荷蘭語、俄語、中文、日語、韓語、阿拉伯語和印地語方面表現出色。以下是 Mistral Large2在多語言 MMLU 基準上的性能結果,與之前的 Mistral Large、Llama3.1模型以及 Cohere 的 Command R+ 進行了比較。

工具使用和函數調用

Mistral Large2配備了增強的函數調用和檢索技能,並經過訓練,可以熟練地執行並行和順序函數調用,使其能夠作爲複雜業務應用程序的動力引擎。

使用方法:

目前,用戶可以在la Plateforme(https://console.mistral.ai/)使用 Mistral Large2,名稱爲mistral-large-2407,並在 le Chat 上進行測試。它可在版本24.07(我們應用於所有模型的 YY.MM 版本控制系統)和 API 名稱下使用mistral-large-2407。instruct 模型的權重可用,並且也託管在HuggingFace上(https://huggingface.co/mistralai/Mistral-Large-Instruct-2407)。

La Plateforme 上的產品,包括兩個通用模型 Mistral Nemo 和 Mistral Large,以及兩個專業模型 Codestral 和 Embed。隨着我們逐步棄用 La Plateforme 上的舊模型,所有 Apache 模型(Mistral7B、Mixtral8x7B 和8x22B、Codestral Mamba、Mathstral)仍可使用 SDK mistral-inference 和 mistral-finetune 進行部署和微調。

從今天開始,產品將擴展 la Plateforme 上的微調功能:這些功能現在可用於 Mistral Large、Mistral Nemo 和 Codestral。

Mistral AI 還與多家領先的雲服務提供商合作,讓 Mistral Large2在全球範圍內可用,尤其是在 Google Cloud Platform 的 Vertex AI 中也能找到它的身影。

** 劃重點:**

🌟 Mistral Large2具備128k 上下文窗口,支持多達十種語言及80多種編程語言。

📈 在 MMLU 基準測試中實現84.0% 的準確率,性能與成本表現卓越。

💻 用戶可通過 La Plateforme 訪問新模型,並在雲服務平臺上廣泛應用。