在人工智能領域,大型語言模型(LLMs)如GPT-3和Llama-2已經取得了顯著進展,能夠準確理解和生成人類語言。然而,這些模型龐大的參數量使得它們在訓練和部署過程中需要大量的計算資源,這對資源有限的環境構成了挑戰。

論文入口:https://arxiv.org/html/2406.10260v1

傳統上,爲了在不同的計算資源限制下實現效率和準確性的平衡,研究人員需要訓練多個不同版本的模型。例如,Llama-2模型系列包括70億、13億和7億參數的不同變體。然而,這種方法需要大量的數據和計算資源,效率並不高。

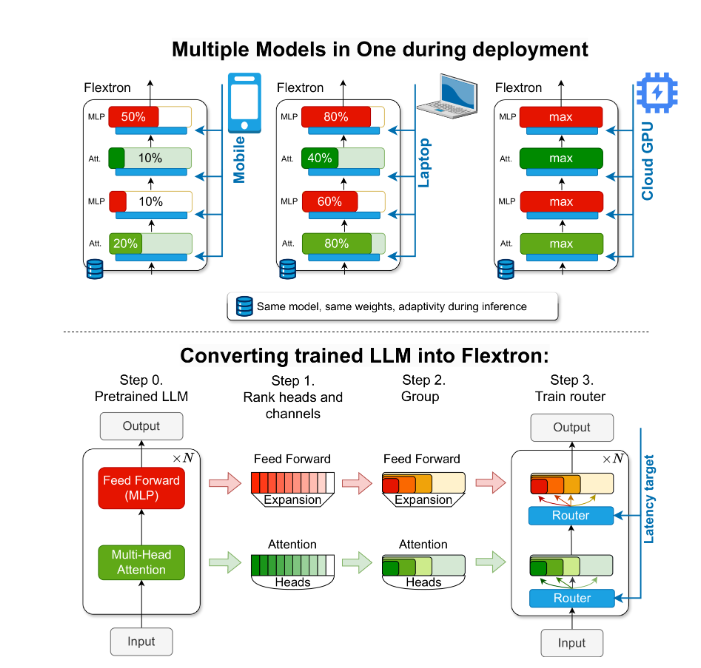

爲了解決這一問題,NVIDIA和德克薩斯大學奧斯汀分校的研究人員推出了Flextron框架。Flextron是一種新穎的靈活模型架構和後訓練優化框架,支持在不需要額外微調的情況下適應性地部署模型,從而解決了傳統方法的低效問題。

Flextron通過樣本高效訓練方法和先進的路由算法將預訓練的LLM轉化爲彈性模型。這種結構採用嵌套彈性設計,允許在推理過程中動態調整以滿足特定的延遲和準確性目標。這種適應性使得在各種部署場景中使用單一預訓練模型成爲可能,顯著減少了對多個模型變體的需求。

Flextron的性能評估顯示,與多個端到端訓練模型和其他最先進的彈性網絡相比,它在效率和準確性上表現出色。例如,Flextron在ARC-easy、LAMBADA、PIQA、WinoGrande、MMLU和HellaSwag等多個基準測試中均表現出色,僅使用了原始預訓練中7.63%的訓練標記,從而節省了大量的計算資源和時間。

Flextron框架還包括彈性多層感知器(MLP)和彈性多頭注意力(MHA)層,進一步增強了其適應性。彈性MHA層通過根據輸入數據選擇注意力頭的子集,有效利用可用內存和處理能力,特別適合計算資源有限的場景。

劃重點:

🌐 Flextron框架支持靈活AI模型部署,無需額外微調。

🚀 通過樣本高效訓練和先進路由算法,提高了模型效率和準確性。

💡 彈性多頭注意力層優化了資源利用,特別適合計算資源有限的環境。

這篇報道希望能爲高中生讀者通俗易懂地介紹Flextron框架的重要性和創新性。