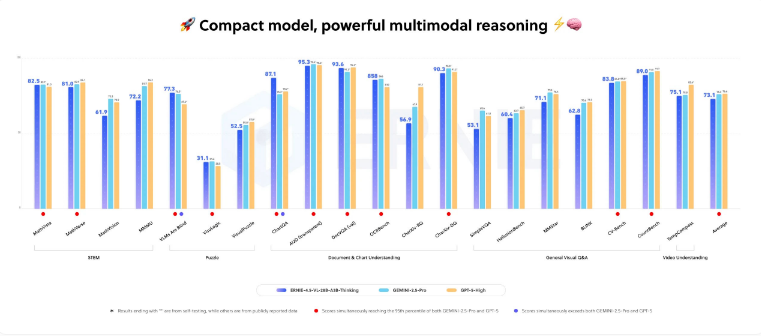

百度は最近、最新のマルチモーダル人工知能モデルであるERNIE-4.5-VL-28B-A3B-Thinkingをリリースしました。このモデルは、画像を推論プロセスに深く統合できる新しいAIモデルです。百度は、このモデルが多くのマルチモーダルベンチマークテストで優れた性能を発揮し、グーグルのGemini2.5ProやOpenAIのGPT-5Highなど、トップクラスの商業モデルを時折上回ったと主張しています。

軽量性と高性能の融合

このモデルの総パラメータ数は280億ですが、ルーティングアーキテクチャを採用しているため、推論には30億のアクティブパラメータのみを使用します。このような効率的なアーキテクチャにより、ERNIE-4.5-VL-28B-A3B-Thinkingは、80GB GPU(例:Nvidia A100)を搭載したデバイスで動作できます。百度はこのモデルをApache2.0ライセンスで公開しており、商用プロジェクトでの無料利用が可能となっています。ただし、百度が主張する性能はまだ独立して検証されていません。

コア機能:“画像思考”と正確な位置特定

このモデルの特徴は、**“画像思考”(Image Thinking)**という機能で、推論中に画像を動的に処理し、重要な詳細を強調することができます。例えば、このモデルは画像内の青色のロゴを自動的に拡大し、その上にある文字を正確に認識でき、内部で画像編集ツールを使用して処理しているように見えます。

他のテストでは、その強力なマルチモーダル能力が示されています:

画像内の人間を正確に位置特定し、座標を返す。

回路図を分析して複雑な数学問題を解決する。

グラフデータに基づいて最適な観光時期を推奨する。

ビデオ入力に対して字幕を抽出し、シーンと特定のタイムスタンプをマッチングする。

外部ツール、例えばネットワークベースの画像検索を利用して、未知の生物を識別する。

業界背景と機能比較

百度は、ERNIE-4.5-VL-28B-A3B-Thinkingが推論中に画像を切り抜き、処理できると強調していますが、このような方法はそれほど新しくありません。2025年4月には、OpenAIがo3およびo4-miniモデルで同様の機能を導入しており、モデルが画像を直接内部の思考プロセスに統合し、視覚タスクの処理時にスケーリング、トリミング、回転などのネイティブツールを使用できるようになりました。これにより、類似したエージェントの推論および問題解決能力の新たな基準が設定されました。