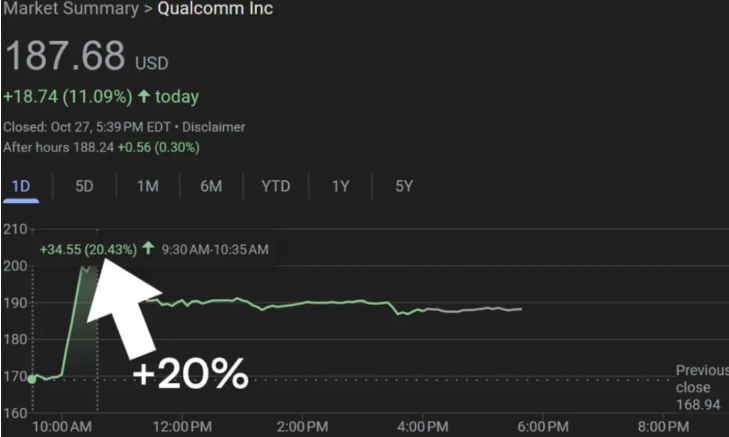

最近、スマートフォンチップで有名なこの大手企業は、クラウドAI推論専用の新製品2種類を発表しました。AI200(2026年商用)とAI250(2027年に登場)です。これは、端末チップメーカーからフルスタックAIインフラのプレイヤーへの重要な転換を示しています。このニュースが公表されると、クアルコムの株価は1日で20%以上上昇し、2019年以来最大の上昇幅となりました。資本市場は実際の資金を投入して信頼を示しました。

推論シーンに焦点を当て、エネルギー効率とコストで突破

インテルとは異なり、英伟達はトレーニングと推論の両方を扱う総合的なアプローチを取っていますが、クアルコムは大規模モデルの推論市場に焦点を当て、「低コスト(TCO)+高エネルギー効率+大メモリ」の3つの利点を強調しています。

- AI200は最大768GBのLPDDRメモリをサポートし、独立したアクセラレーターカードまたは整機架システムとして提供可能で、大規模言語モデルやマルチモーダル推論を最適化し、企業が必要とする高並列性・低遅延の推論ニーズに対応します;

- AI250はさらに進化し、ニアメモリコンピューティング(近メモリコンピューティング)アーキテクチャを導入し、メモリ帯域を10倍に向上させ、同時に消費電力を大幅に削減し、超大規模な展開のためにエネルギー効率の新しい基準を提示します。

この戦略は現在のデータセンターの課題を直接的に突いています。モデル推論コストが急騰している中、企業は単にピーク演算性能を求めるのではなく、よりコストパフォーマンスの高い、低消費電力の専用ソリューションを必要としています。

10年かけて磨いた一振り、Hexagon NPUが鍵となるエンジン

クアルコムは突然の行動ではありません。2019年から、そのIoTと5Gエッジコンピューティング分野での経験を通じて、クラウドチップの開発に取り組んでおり、その核心的な武器は自社開発のHexagon神経処理ユニット(NPU)です。長年の進化により、Hexagonはスマートフォン向けAIアクセラレーターからデータセンターまで拡張可能な高性能推論エンジンへと進化し、クアルコムがクラウド市場に挑む技術的支柱となっています。

巨頭たちがインテルを狙う、市場は「一極化からの転換点」を迎える

インテルが現在AIチップ市場の約90%を占めていますが、顧客はサプライチェーンの多様化への需要がますます強まっています。グーグル(TPU)、アマゾン(Trainium/Inferentia)、マイクロソフト(Maia)などのクラウドベンダーはすでに自社のチップを開発しており、クアルコムの参入によって第三者の独立サプライヤーに新たな選択肢が生まれました。マケンジーより、2030年までに世界のデータセンター投資は6.7兆ドルに達すると予測されています。この広い市場は複数のプレイヤーを受け入れることができるでしょう。

クアルコムは最初の大きな顧客を獲得しました。サウジアラビアのAIスタートアップであるHumainは、2026年にAI200/AI250に基づくラックシステムを導入する予定で、総出力は200メガワットに達し、小都市の電力使用量に相当します。

インテルの地位を揺さぶれるか?カギはエコシステムと実装

インテルに挑むには、チップ性能は入り口の切符であり、ソフトウェアエコシステム、開発者支援、そして実際に運用された結果が勝敗を決める鍵となります。クアルコムがモバイル端末で成功したエコシステムの統合能力を再現できるかどうか、ツールチェーンからフレームワークまでの完全な推論スタックを構築できるかどうかが、高級市場で本当にシェアを得られるかどうかを決定するでしょう。