上海人工知能実験室と浙江大学などの機関は、最近IWR-Benchを共同で公開しました。これは、動画をインタラクティブなウェブコードに変換する能力を評価するための最初のベンチマークテストです。このベンチマークは、多モードの巨大言語モデル(LVLM)が動的ウェブ再構築において持つ能力をより現実的に測定することを目的としており、AIフロントエンド開発分野における動的インタラクティブ評価の空白を埋めています。

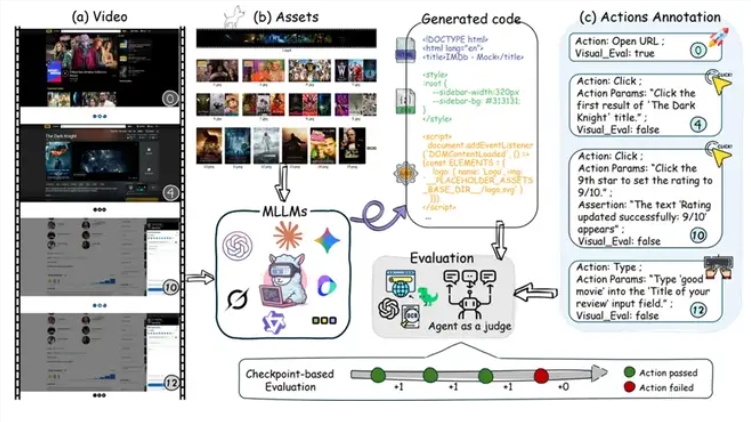

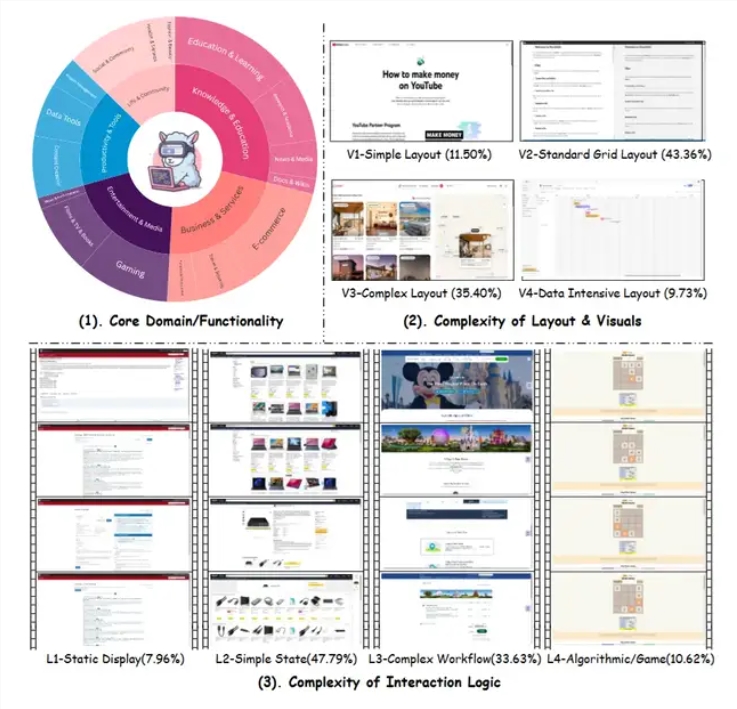

従来の画像からコードへのタスク(Image-to-Code)とは異なり、IWR-Benchではモデルがユーザーの完全な操作プロセスを記録した動画を視聴し、ウェブに必要なすべての静的リソースを組み合わせて、ウェブの動的なインタラクティブ動作を再構築することが求められます。タスクの複雑さは、単純なウェブブラウジングから複雑なゲームルールの再構築に至るまで幅広く、2048ゲームや航空券予約などのさまざまなシナリオを含んでいます。

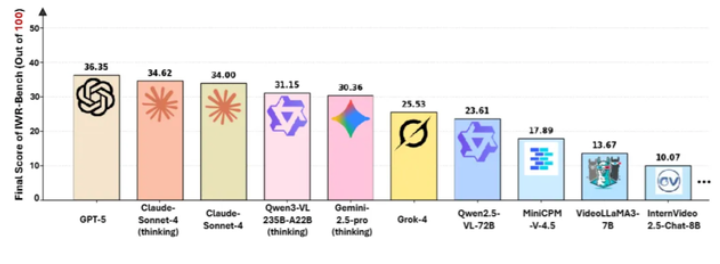

テスト結果は、現在のAIモデルがこのタスクにおいて顕著な限界を持っていることを示しています。28の主要なモデルを評価した結果、最も良い成績を収めたGPT-5の総合得点は36.35点でした。そのうち、インタラクティブ機能の正しさ(IFS)得点は24.39%、視覚の正確度(VFS)得点は64.25%でした。このデータは、モデルが視覚の復元に関して相対的に強い一方で、イベント駆動ロジックや動的なインタラクティブ機能を実装する上で明確な欠点があることを明確に示しています。

評価方法の観点から見ると、IWR-Benchはモデルの視覚的復元能力だけでなく、インタラクティブ機能の正しさを自動代理で評価することにも注目しています。各タスクには完全な静的リソースが提供され、すべてのファイル名は匿名化されています。これにより、モデルはリソースを関連付けるために文脈的推論ではなく視覚的マッチングに頼らざるを得ません。この設計は現実的な開発環境に近づけており、モデルが操作動画内の因果関係や状態変化を理解し、それを実行可能なコードロジックに変換する能力を要求しています。

研究者たちはいくつかの興味深い現象も見つけました。「思考」メカニズムを持つモデルバージョンは特定のタスクでより良い結果を示しましたが、改善幅度は限定的であり、基本モデルの能力が決定的な要因であることを示しています。また、動画理解に特化したモデルはこのタスクでのパフォーマンスが一般的なマルチモーダルモデルに劣るということが判明しました。これは、動画からウェブに変換するタスクが従来の動画理解タスクと本質的に異なることを示しており、前者が必要とするのは単なる動画内容の理解ではなく、動的な行動をプログラミングロジックに抽象化することであることを意味しています。

技術的な課題としては、動画からウェブへの変換タスクの難しさは複数の層にわたっています。第一に時系列理解があり、モデルは連続する動画フレームから重要なインタラクティブイベントと状態遷移を抽出する必要があります。第二に論理抽象があり、観察された行動パターンをイベントリスナー、状態管理などのプログラミングコンセプトに変換する必要があります。第三にリソースマッチングがあり、匿名化された静的リソースの中で正しい画像やスタイルなどのファイルを正確に見つける必要があります。第四にコード生成があり、構造的かつ論理的に正しいHTML、CSS、JavaScriptコードを生成する必要があります。

GPT-5は総合得点で36.35点にとどまり、これは最高水準のマルチモーダルモデルでも、動的な行動を実行可能なコードに変換するというタスクにおいて大幅な改善余地があることを示しています。24.39%のインタラクティブ機能の正解率は、モデルが生成したウェブページの75%以上でインタラクティブ機能に問題があることを意味します。これは、イベント応答が正しくない、状態管理が間違っている、ビジネスロジックが欠如しているなどの問題が含まれます。

IWR-Benchの導入は、AI研究および応用において重要な意義を持っています。研究の観点から見ると、これは多モードモデルの動的理解とコード生成能力に対して新しい評価軸を提供し、現在の技術の弱い部分を特定する助けになります。応用の観点から見ると、動画からウェブへの変換能力が成熟すれば、フロントエンド開発の障壁を大幅に低下させ、非技術者でも操作のデモを通じて機能プロトタイプを生み出すことが可能になります。

ただし、モデルがこのベンチマークで高いスコアを取得しても、実際の応用にはまだ距離があります。現実的なウェブ開発にはパフォーマンス最適化、互換性処理、セキュリティ保護、保守性など、多くの次元が含まれており、これらは動画デモだけで完全に伝えられない可能性があります。さらに、複雑なビジネスロジック、エッジケースの処理、ユーザー体験の詳細についても、操作動画だけからは完全に推測するのが難しい場合があります。

業界トレンドの観点から見ると、IWR-BenchはAIコード生成が静的から動的、単一フレームから複数フレーム、説明からデモへと進化する方向を示しています。これは現在のAIコードアシスタントが主にテキスト記述に依存している現状と対照的であり、「見えるものすべてが即座に実現される」スマート開発ツールの技術的基盤を提供しています。もし今後のモデルがこのタスクで突破を遂げれば、新世代のプロトタイピングツールが登場し、製品マネージャーやデザイナーが操作動画を録画することでインタラクティブなウェブプロトタイプを生成できるようになるかもしれません。

テスト結果から見ると、現在のAIモデルは複雑な動的なインタラクションを理解する段階に留まっています。視覚的正確度は64.25%と比較的高く、モデルがページの静的な外観をある程度うまく復元できていることを示しています。しかし、インタラクティブ機能の正しさは24.39%と低く、観察された行動を正しいプログラムロジックに変換することが依然として大きな課題であることを示しています。このギャップは、AIが「見て理解する」ことと「正しく行う」ことの間にある溝を反映しており、視覚要素を識別できるからといって背後にあるインタラクティブロジックを理解できるとは限らないということです。

IWR-Benchの意味は、評価ツールを提供することにとどまらず、AIの多モード能力の発展における重要な方向性を明確にすることにもあります。このベンチマークが広く普及すれば、動的な行動の理解、時系列推論、コード生成の統合に焦点を当てた研究が増えることが予想されます。それにより、多モードの巨大モデルが実際の開発シナリオにおいてより高い応用価値を持つようになるでしょう。