人工知能の分野において、大規模言語モデル(LLM)は優れた性能で注目を集めていますが、導入時には大きな計算とメモリのコスト問題に直面しています。この課題を克服するため、グーグル DeepMind は最近、新しいアーキテクチャ「Mixture-of-Recursions (MoR)」を発表しました。このアーキテクチャは、従来の Transformer モデルの「杀手」として注目されています。

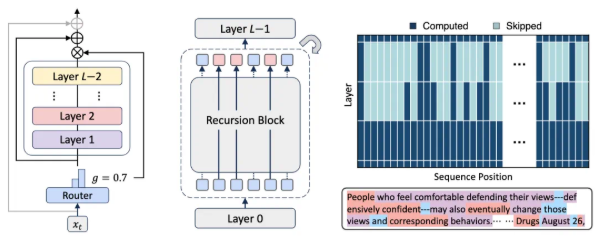

MoR アーキテクチャは、再帰的な Transformer をもとに革新を加え、パラメータ共有と自己適応的な計算を同時に実現することを目的としています。動的なトークンレベルのルーティングを効率的な再帰的な Transformer に組み込むことで、モデルのコストを増やさずに大規模モデルと同等の性能を提供できます。このモデルは、軽量なルーティングシステムを通じて、各トークンに固有の再帰深度を割り当て、それぞれのトークンが必要とする「思考」の回数を動的に決定します。この方法により、計算リソースを効果的に配分し、処理効率を向上させることができます。

具体的な実装では、MoR はトークンの再帰深度に基づいて関連するキー値ペアを選択的にキャッシュおよび検索する高度なキャッシュ機構を採用しています。このイノベーションにより、メモリバンド幅の圧力を大幅に軽減し、推論スループットを向上させます。また、パラメータ共有、計算ルーティング、再帰レベルのキャッシュなどの複数の最適化措置により、パラメータ数を著しく削減し、計算コストを低減しています。

実験では、同じ計算予算下で、MoR は元の Transformer と再帰的な Transformer をより少ないパラメータ数で上回りました。これにより、その優れた性能が確認されました。ベースラインモデルとの比較では、MoR は少サンプル学習の平均精度でも優れた結果を達成しました。これは、パラメータ数が約50%減少したにもかかわらずです。この成功は、効率的な計算戦略により MoR がより多くのトレーニングトークンを処理できるようになったことに起因しています。

さらに、研究者たちは、MoR が異なる計算予算下で常に再帰的ベースラインモデルを上回っていることを発見しました。特に、モデルサイズが3億6,000万を超える場合、MoR は元の Transformer と並ぶだけでなく、低~中程度の予算でもしばしば相手を上回ることがあります。したがって、MoR は拡張性があり、効率的な代替案として、大規模なプリトレーニングと展開に適しているとされます。

AI技術の進歩とともに、MoR アーキテクチャの登場は、大規模言語モデルの効率化に対して新たな解決策を提供し、AI研究分野での新たな突破を示しています。

論文リンク: alphaxiv.org/abs/2507.10524

ポイント:

🌟 MoR アーキテクチャは、計算リソースの動的配分とキャッシュ機構により、大規模言語モデルの効率を効果的に向上させています。

📉 同じ計算予算下で、MoR はより少ないパラメータで伝統的な Transformer を上回り、性能が優れています。

🚀 MoR は AI 研究における新たな突破とされ、大規模なプリトレーニングと展開に適しています。