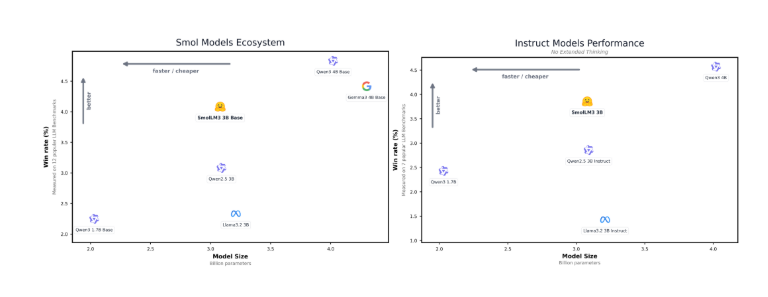

最近、世界的に有名な大規模モデルオープンプラットフォームである Hugging Face は、最新のオープンソースモデルである SmolLM3 を正式にリリースしました。このモデルは30億パラメータを持ち、パラメータ数が比較的少ないものの、その性能は同様のオープンソースモデルである Llama-3.2-3B や Qwen2.5-3B に大きく優れています。

SmolLM3は128kのコンテキストウィンドウをサポートし、英語、フランス語、スペイン語、ドイツ語などのテキストをスムーズに処理できます。これは小パラメータモデル分野におけるまた一つの重要な進展を示しています。

多様な推論モード、柔軟に対応

SmolLM3は深く考えるモードとそれ以外のモードの2つの推論モードを備えています。ユーザーは実際のニーズに応じて柔軟に切り替えることができます。このイノベーション設計により、モデルは複雑な問題を処理する際に、特に深層分析が必要なシナリオでより良い推論能力を発揮できるようになります。

オープンソースアーキテクチャ、研究と最適化を支援

注目すべき点は、Hugging Face が SmolLM3 のアーキテクチャの詳細、データの混合方法、およびモデルトレーニングプロセスをすべて公開していることです。このオープン戦略は、開発者たちによるモデルの研究と最適化を大幅に促進し、オープンソース AI モデルのさらなる発展を推進するでしょう。

モデルアーキテクチャとトレーニング設定

SmolLM3は先進的な transformer デコーダー構造を採用しており、SmolLM2の設計を参考にしつつ、Llamaに対する重要な改善を行って効率性と長文対応力を向上させています。具体的には、グループ化されたクエリ注意機構とドキュメント内マスク技術を使用して、長文トレーニングの効果を確保しています。

トレーニング設定に関しては、SmolLM3のパラメータ数は3.08Bであり、36層の深い構造を持ち、オプティマイザとして AdamW を使用し、24日間の分散トレーニングを経て、強力なモデルが完成しました。

3段階の混合トレーニング、能力の向上

このモデルのトレーニングプロセスは3つの段階に分けられ、さまざまな種類のデータを使って混合トレーニングを行います。第一段階では、ネットワーク、数学、コードデータの統合トレーニングによって汎用的な能力を構築します。第二段階では、より高品質な数学とコードデータを取り入れます。第三段階では、数学とコードデータのサンプリングをさらに強化し、推論能力和指示遵守能力を向上させます。

SmolLM3のリリースにより、Hugging Face は再びAI分野でのリーダーシップを固めました。このモデルは強力な推論能力を持ち、効率的な性能により開発者たちにとって豊富な応用可能性を提供しています。今後、より多くのオープンソース研究とコミュニティ協力が進むことで、SmolLM3は様々な応用シーンでより大きな役割を果たすことが期待されます。

ベースモデル: https://huggingface.co/HuggingFaceTB/SmolLM3-3B-Base

推論および指示モデル: https://huggingface.co/HuggingFaceTB/SmolLM3-3B