2024年8月、科大訊飛は正式に「星火極速超擬人インタラクティブ技術」を発表しました。エンド・トゥ・エンドの音声モデリングと多次元の感情分離トレーニングにより、応答速度、感情共鳴、音声コントロール表現の3つの主要な突破を実現しました。この技術はユーザーの音声における感情の変動を正確に認識し、適切なトーンでリアルタイムで返答でき、語速、音色、キャラクター設定の動的調整をサポートします。これは、音声インタラクションが「機能の実現」から「感情のつながり」への飛躍的な進化を示しています。

現在、「超擬人インタラクティブAPI」は正式に科大訊飛オープンプラットフォームにリリースされ、開発者は低コストで技術能力を呼び出せます。ゲーム領域では、NPCがプレイヤーの感情に応じて対話戦略を動的に調整できます。教育シーンでは、AIの英会話パートナーがネイティブ講師のリアルな反応を模倣できます。観光文化産業では「デジタルガイド」が登場し、キャラクターとしての役割プレイを通じて訪問者と深く交流しています。ある観光地の試験導入では、この技術を搭載したガイドAIによって訪問者の滞在時間が40%増加し、再購入率が25%上昇しました。

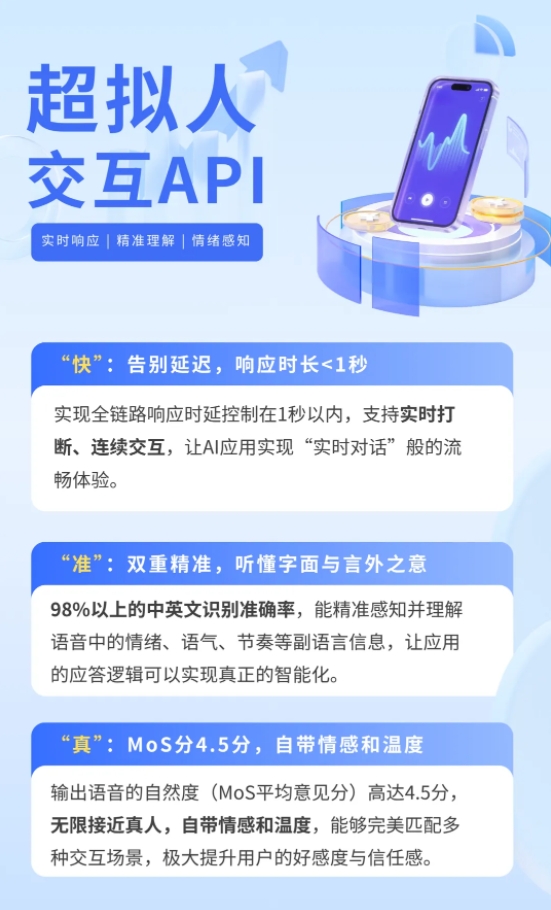

従来の音声インタラクティブシステムは「音声認識-大規模モデル処理-音声合成」の直列構造を採用しており、平均応答時間は3秒以上になることがあります。また、感情伝達はテキスト内容に依存し、音声内のトーンやリズムなどの副言語情報は捕捉できません。星火極速超擬人インタラクティブ技術は統一されたニューラルネットワークフレームワークを採用し、音声から音声へのエンド・トゥ・エンドモデリングを直接実現します。音声信号は音声エンコーダーで特徴を抽出され、テキストの意味表現と一致させた後、マルチモーダルの大規模モデルが出力表現を予測し、最終的に音声デコーダーで自然な感情と正確なリズムを持つ合成音声を生成します。この革新により、インタラクションの遅延は0.5秒以内に圧縮され、応答形式は「あなたが尋ねれば私があなたに答える」から「リアルタイムでの会話」へと進化しました。

真の感情共鳴を実現するために、技術チームは多次元の音声属性分離表現体系を構築しました。コンテンツ、感情、語種、音色、リズムなどの要素を分離してトレーニングします。比較学習とマスク予測を用いて、システムは音声中の喜び、怒り、不安などの感情を正確に識別し、自動的に返答戦略を調整します。例えば、ユーザーが急いで道を尋ねるときには、AIは落ち着いたトーンで迅速にルートを計画します。ユーザーが面白いことを話すときには、AIは軽快なトーンで話題を広げます。また、開発者はAPIを介してAIキャラクターの設定をカスタマイズし、特定の価値観や言語スタイルを持たせたり、有名人の声を模倣してインタラクションを行うこともできます。

アプリケーションのハードルを下げるために、科大訊飛は段階的な価格戦略を提供しています。API呼び出しコストは最低0.1元/分まで下がり、企業ユーザーは認証を通じて3か月間、10時間の無料試用枠を得られます。従来の音声インタラクティブシステムでは音声認識、合成、NLPなどのモジュールを個別に購入する必要がありましたが、星火極速超擬人技術は全体のコストを60%以上削減しています。