最近、アリババの通義实验室は、最新の研究成果であるViDoRAGをオープンソースとして公開しました。ViDoRAGは、視覚的なドキュメントの理解のために設計された、検索強化型生成(RAG)システムです。GPT-4oモデルでのテストでは、驚異的な79.4%の精度を達成し、従来のRAGシステムと比べて10%以上も向上しました。この画期的な成果は、視覚ドキュメント処理分野における大きな一歩であり、複雑なドキュメントの理解における人工知能の応用可能性に新たな展望を開きます。

マルチエージェントフレームワークによる視覚ドキュメント理解の強化

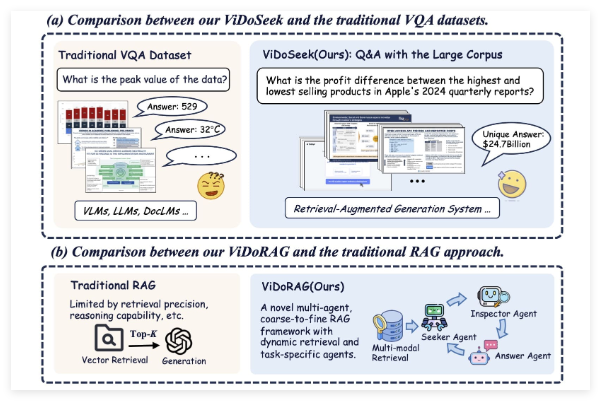

ViDoRAGは従来の単一モデルとは異なり、革新的なマルチエージェントフレームワークを採用しています。このシステムは、動的繰り返し推論エージェント(Dynamic Iterative Reasoning Agents)と、GMM(ガウス混合モデル)ベースのハイブリッド検索技術を組み合わせています。この手法により、ViDoRAGは画像とテキストを含む視覚ドキュメントを処理する際に、重要な情報をより正確に抽出・推論できます。従来のRAGシステムがテキスト検索に依存していた制限とは異なり、ViDoRAGはマルチモーダルデータの融合により性能を大幅に向上させています。

通義实验室は、公開された論文とコードリポジトリでViDoRAGの動作原理を詳しく説明しています。その核心は、複数のエージェントが連携して検索と生成のプロセスを動的に調整することで、複雑な状況下での「幻覚」(モデルが不正確な内容を生成したり、でたらめな内容を作成したりすること)を減らし、回答の信頼性とコンテキストの関連性を高めることにあります。

性能向上:精度が10%以上向上

GPT-4oでの精度は79.4%に達し、その優れた性能を示すと同時に、従来のRAGシステムとの比較も行われました。従来のRAGシステムはテキスト生成タスクでは優れた性能を発揮しますが、視覚ドキュメントの処理では単一モーダリティの検索能力に制限され、精度は一般的に低いレベルにとどまっていました。一方、ViDoRAGは視覚情報とテキスト情報の深層統合を導入することで、精度を10%以上向上させました。この進歩は、法律文書分析、医療レポートの解釈、企業データ処理など、高精度なドキュメント理解が必要な場面で大きな意味を持ちます。

アリババの通義实验室によるViDoRAGのオープンソース化は、Twitterでも話題になっています。ユーザーは、このシステムの公開はアリババのAI分野における技術力を示すと同時に、世界中の開発者や研究者にとって貴重なリソースになると考えています。論文とコード(関連するリンクはTwitterの投稿で共有されています)を公開することで、ViDoRAGは視覚ドキュメントRAG技術の研究と応用を加速し、マルチモーダルAIシステムの更なる発展を促進すると期待されています。

ViDoRAGの公開とオープンソース化は、RAG技術に新たな方向性を切り開きました。視覚ドキュメント処理の需要が継続的に増加する中で、ViDoRAGの登場は始まりに過ぎず、今後、同様の革新的なシステムが数多く登場する可能性があります。