幻方量化は12月26日夜、驚異的な技術的ブレークスルーを示す、次世代大規模言語モデルDeepSeek-V3を発表しました。MoE(混合専門家)アーキテクチャを採用したこのモデルは、性能においてトップレベルのクローズドソースモデルに匹敵するだけでなく、低コストで高効率である点が業界の注目を集めています。

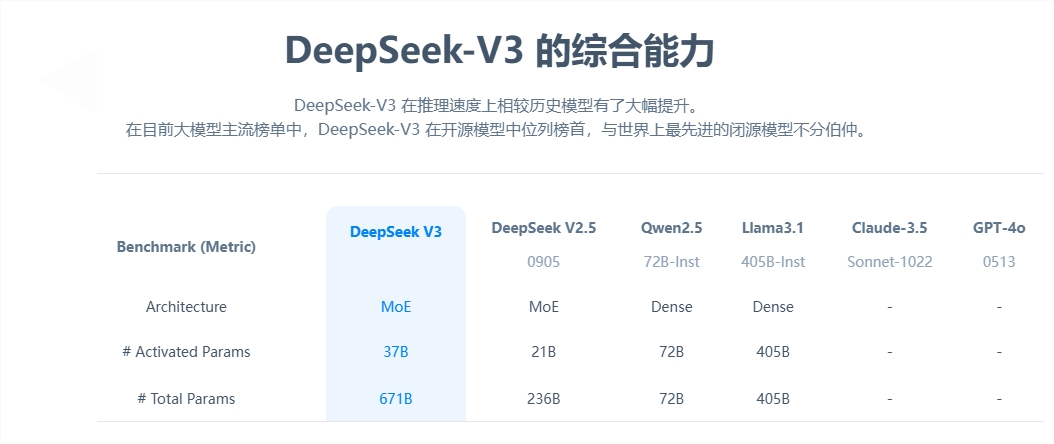

主要パラメータから見ると、DeepSeek-V3は6710億パラメータを備え、そのうち活性化パラメータは370億です。14.8兆トークンのデータ規模で事前学習が行われました。前世代の製品と比較して、新モデルの生成速度は3倍に向上し、毎秒60トークンを処理できるようになり、実用的な効率が大幅に向上しています。

性能評価において、DeepSeek-V3は卓越した能力を示しました。Qwen2.5-72BやLlama-3.1-405Bなどの有名なオープンソースモデルを凌駕するだけでなく、多くのテストでGPT-4やClaude-3.5-Sonnetに匹敵する結果を出しました。特に数学能力テストでは、既存のオープンソースおよびクローズドソースモデルをすべて上回る優秀な成績を収めました。

最も注目すべきはDeepSeek-V3の低コスト性です。公開された論文によると、GPU時間あたり2ドルで計算した場合、モデルの全トレーニングコストはわずか557.6万ドルでした。この画期的な成果は、アルゴリズム、フレームワーク、ハードウェアの協調的な最適化によるものです。OpenAIの共同設立者Karpathyは、DeepSeek-V3がLlama3を上回る性能をわずか280万GPU時間で達成し、計算効率が約11倍向上したと高く評価しています。

商業化に関して、DeepSeek-V3のAPIサービスの価格は前世代と比べて上昇しましたが、それでも高いコストパフォーマンスを維持しています。新バージョンの価格は、入力トークン100万あたり0.5~2元、出力トークンあたり8元で、総コストは約10元です。これに対し、GPT-4の同等のサービス価格は約140元と、価格差は顕著です。

完全にオープンソースの大規模言語モデルであるDeepSeek-V3の発表は、中国のAI技術の進歩を示すだけでなく、開発者や企業に高性能で低コストなAIソリューションを提供します。