AIの世界では、「力技」が成功の秘訣のように思われています。モデルが大きければ大きいほど、データが多ければ多いほど、計算能力が強ければ強いほど、まるで知性の聖杯に近づけるかのように。しかし、この急激な進歩の裏には、莫大なコストとエネルギー消費という課題が潜んでいます。

AIのトレーニングをより効率的にするために、科学者たちはより強力な最適化アルゴリズムを探し続けてきました。まるでコーチのように、モデルのパラメータを最適化し、最終的に最高の状態に導くのです。AdamWはTransformerの事前学習におけるデフォルトの最適化アルゴリズムとして、長年業界のベンチマークとなってきました。しかし、ますます巨大化するモデル規模に対しても、AdamWは限界に近づきつつあります。

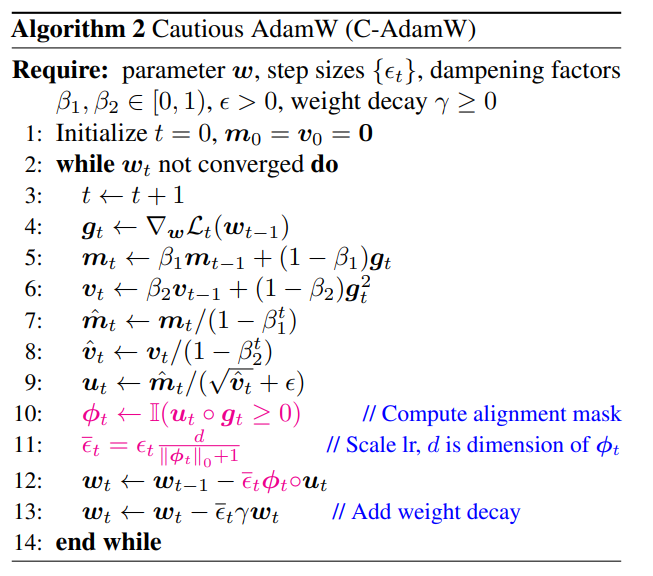

トレーニング速度を向上させながら、エネルギー消費を削減する方法はないのでしょうか?ご安心ください。全中国人チームが彼らの「秘密兵器」C-AdamWを持って登場しました!

C-AdamWの正式名称はCautious AdamWで、日本語では「慎重なAdamW」という意味です。「悟りを開いた」ように聞こえますね?その通りです。C-AdamWの中核となる考え方は「よく考える」ということです。

モデルのパラメータを、活気あふれる子供たちだと想像してみてください。彼らは常に動き回ろうとしています。AdamWは勤勉な教師のように、子供たちを正しい方向に導こうと努力します。しかし、時には子供たちは興奮しすぎて、間違った方向に進んでしまい、時間と労力を無駄にしてしまうことがあります。

そこで、C-AdamWは賢明な長老のような存在です。「慧眼」を持っており、更新の方向が正しいかどうかを正確に識別できます。方向が間違っていれば、C-AdamWは断固として停止させ、モデルが間違った道を進んでいくのを防ぎます。

この「慎重さ」という戦略により、毎回の更新で損失関数を効果的に削減し、モデルの収束速度を向上させることができます。実験結果によると、C-AdamWはLlamaとMAEの事前学習において、トレーニング速度を1.47倍に向上させました!

さらに重要なのは、C-AdamWは追加の計算コストがほとんどなく、既存のコードに1行の簡単な変更を加えるだけで実装できることです。つまり、開発者はC-AdamWを様々なモデルのトレーニングに簡単に適用し、「スピードと興奮」を楽しむことができます!

C-AdamWの「悟りを開いた」点は、Adamのハミルトン関数を使用し、リアプノフ解析の下で収束性の保証を損なわないことです。つまり、C-AdamWは速度が速いだけでなく、安定性も保証されており、トレーニングが失敗するなどの問題が発生しません。

もちろん、「悟りを開いた」ということは「進歩しない」という意味ではありません。研究チームは、より豊富なϕ関数の探求を続け、パラメータ空間ではなく特徴空間でマスクを適用することで、C-AdamWの性能をさらに向上させる予定です。

C-AdamWは、深層学習分野の新たな寵児となり、大規模モデルのトレーニングに革命的な変化をもたらすことが期待されます!

論文アドレス:https://arxiv.org/abs/2411.16085

GitHub:

https://github.com/kyleliang919/C-Optim