最近、AIの大規模言語モデル(LLM)は詩作、コーディング、チャットなど様々なタスクで優れた能力を発揮し、まさに万能のようです!しかし、信じられますか?これらの「天才」AIはなんと「数学音痴」なのです!簡単な算術問題でもしばしば間違え、驚くべき事実です。

最新の研究が、LLMの算術推論能力の裏にある「奇妙な」秘密を明らかにしました。それは強力なアルゴリズムにも、完全な記憶力にも依存せず、「ヒューリスティックな寄せ集め」と呼ばれる戦略を採用しているのです!まるで学生が、数学の公式や定理を真面目に勉強せず、「小賢しさ」や「経験則」で答えを当てようとするようなものです。

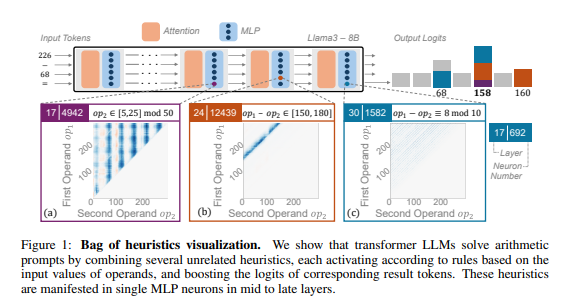

研究者たちは算術推論を典型的なタスクとして、Llama3、Pythia、GPT-Jなどの複数のLLMを詳細に分析しました。そして、LLMにおける算術計算を担当する部分(「回路」と呼ばれる)は、多くの単一ニューロンから構成されており、各ニューロンは「小型計算機」のようなもので、特定の数字パターンを認識して対応する答えを出力することが分かりました。例えば、あるニューロンは「一の位が8の数字」を専門に認識し、別のニューロンは「150~180の間の結果となる減算」を認識するといった具合です。

これらの「小型計算機」は、まるで雑然と置かれた道具の山のように、LLMは特定のアルゴリズムに従ってそれらを使用するのではなく、入力された数字パターンに基づいてランダムにこれらの「道具」を組み合わせて計算します。まるで料理人が、決まったレシピを持たずに、手元の材料で適当に組み合わせ、最終的に「闇鍋」のような料理を作るようなものです。

さらに驚くべきことに、この「ヒューリスティックな寄せ集め」戦略はLLMの訓練の初期段階から現れ、訓練が進むにつれて徐々に洗練されていきます。つまり、LLMは最初からこの「寄せ集め」式の推論方法に依存しており、後からこの戦略を開発したわけではないのです。

では、この「奇妙な」算術推論方法は何を引き起こすのでしょうか?研究者たちは、「ヒューリスティックな寄せ集め」戦略は汎化能力が限られており、誤りが生じやすいことを発見しました。これは、LLMが習得している「小賢しさ」の数が限られており、それらの「小賢しさ」自体にも欠陥がある可能性があり、新しい数字パターンに出会った際に正しい答えを出せないためです。まるで「卵焼き」しか作れない料理人に突然「回鍋肉」を作らせようとするようなもので、彼はきっと慌てふためき、途方にくれるでしょう。

この研究は、LLMの算術推論能力の限界を明らかにするとともに、LLMの数学能力を向上させるための将来の方向性を示唆しています。研究者たちは、既存の訓練方法とモデルアーキテクチャだけではLLMの算術推論能力を向上させるには不十分であり、LLMがより強力で汎化されたアルゴリズムを学習できるようにする新しい方法を探求する必要があると考えています。真の「数学の達人」になるためには。