マイクロソフトは、多言語およびマルチモーダルAI開発におけるリーダーシップをさらに強化するため、3つの新しいPhi-3.5モデルを発表しました。この3つの新しいモデルは、Phi-3.5-mini-instruct、Phi-3.5-MoE-instruct、Phi-3.5-vision-instructであり、それぞれ異なる用途に対応しています。

Phi-3.5-mini-instructモデルは、軽量なAIモデルで、パラメーター数は3.8億個です。計算能力が限られた環境に最適で、128kのコンテキスト長をサポートし、命令実行能力を最適化することで、コード生成、数学問題解決、論理推論などのタスクに適しています。小型ながら、多言語や複数回にわたる対話タスクにおいて、他の同等のモデルを凌駕するパフォーマンスを示しています。

アクセスはこちら: https://huggingface.co/microsoft/Phi-3.5-mini-instruct

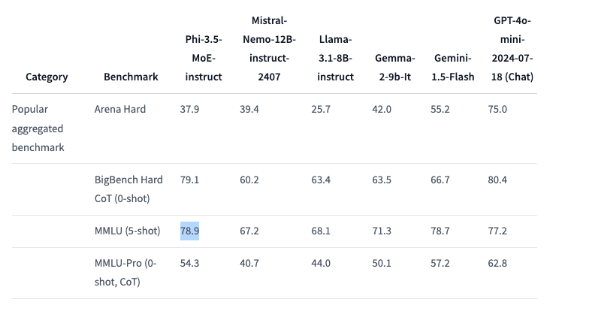

Phi-3.5-MoEモデルは、「専門家混合」モデルで、それぞれ特定のタスクに特化した複数の異なるタイプのモデルを組み合わせたものです。419億個のパラメーターを持ち、128kのコンテキスト長をサポートし、様々な推論タスクで強力な性能を発揮します。コード、数学、多言語理解において優れたパフォーマンスを示し、MMLU(大規模多言語理解)ベンチマークではOpenAIのGPT-4o miniを上回るなど、一部のベンチマークテストではより大規模なモデルを上回っています。

アクセスはこちら: https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

Phi-3.5-vision-instructモデルは、テキストと画像処理能力を統合した高度なマルチモーダルAIモデルで、画像理解、光学文字認識、グラフや表の分析、ビデオ要約などのタスクに適しています。このモデルも128kのコンテキスト長をサポートし、複雑な複数フレームのビジョンテストに対応できます。

アクセスはこちら: https://huggingface.co/microsoft/Phi-3.5-vision-instruct

これらの3つのモデルをトレーニングするために、マイクロソフトは大規模なデータ処理を行いました。Mini Instructモデルは3.4兆個のトークンを使用し、512個のH100-80G GPUで10日間トレーニングされました。Vision Instructモデルは5000億個のトークンを使用し、6日間トレーニングされました。MoEモデルは4.9兆個のトークンを使用し、23日間トレーニングされました。

特筆すべきは、これらの3つのPhi-3.5モデルはすべてMITオープンソースライセンスで公開されているため、開発者は自由にこれらのソフトウェアを使用、修正、配布できます。これは、マイクロソフトによるオープンソースコミュニティへのサポートを示すとともに、より多くの開発者が最先端のAI機能を自身のアプリケーションに統合することを可能にします。

要点:

🌟 マイクロソフトが3つの新しいAIモデルを発表。軽量推論、専門家混合、マルチモーダルタスクに対応。

📊 Phi-3.5-MoEはベンチマークテストでGPT-4o miniを上回る優れたパフォーマンス。

📜 3つのモデルはすべてMITオープンソースライセンスで提供され、開発者は自由に使用・修正可能。