随着AI技术的飞速发展,大模型在图像放大领域的表现已令人惊叹,高清化低分辨率图片早已不是难事。然而,在视频超分辨率(RealVSR)领域,如何在保持帧间流畅性的同时大幅提升清晰度,一直是技术难题。近日,由香港理工大学与OPPO研究院联合研发的DLoRAL框架横空出世,以其创新的双LoRA架构和高效的单步生成能力,为视频高清化提供了开源解决方案,引发业界广泛关注。以下,AIbase为您独家解读这一突破性技术的亮点与潜力。

项目地址:https://github.com/yjsunnn/DLoRAL

创新双LoRA架构,兼顾时间与空间

DLoRAL(Dual LoRA Learning)框架基于预训练的扩散模型(Stable Diffusion V2.1),通过独特的双LoRA架构实现了视频超分辨率的革命性突破。其核心在于两个专门设计的LoRA模块:

CLoRA:专注于视频帧之间的时间一致性(Temporal Consistency)。通过提取低质量输入视频中的时序特征,CLoRA确保相邻帧之间过渡自然,避免了传统方法中常见的闪烁或跳跃现象。

DLoRA:负责增强视频的空间细节(Spatial Details)。DLoRA通过优化高频信息,显著提升画面的清晰度和细节表现,让低分辨率视频焕发出高清质感。

这种双LoRA设计将时间一致性与空间细节增强两大目标解耦,通过轻量化的模块嵌入预训练扩散模型,既降低了计算成本,又提升了生成效果。

双阶段训练策略,效率与质量双赢

DLoRAL的训练过程采用了创新的双阶段策略,分为一致性阶段和增强阶段,交替优化以实现最佳性能:

一致性阶段:通过CLoRA模块和CrossFrame Retrieval(CFR)模块,结合一致性相关损失函数,优化视频帧间的时序连贯性。这一阶段确保生成的视频在动态场景下也能保持流畅。

增强阶段:冻结CLoRA和CFR模块,专注于训练DLoRA,利用分类器分数蒸馏(CSD)等技术进一步提升高频细节,让画面更加锐利清晰。

这种交替训练的方式让DLoRAL能够专注于不同目标的优化,最终在推理阶段通过单步生成,将CLoRA和DLoRA融合到冻结的扩散UNet中,实现高效的高质量视频输出。相比传统多步迭代的超分辨率方法,DLoRAL的推理速度提升约10倍,展现了惊人的效率优势。

开源赋能,助力学术与产业

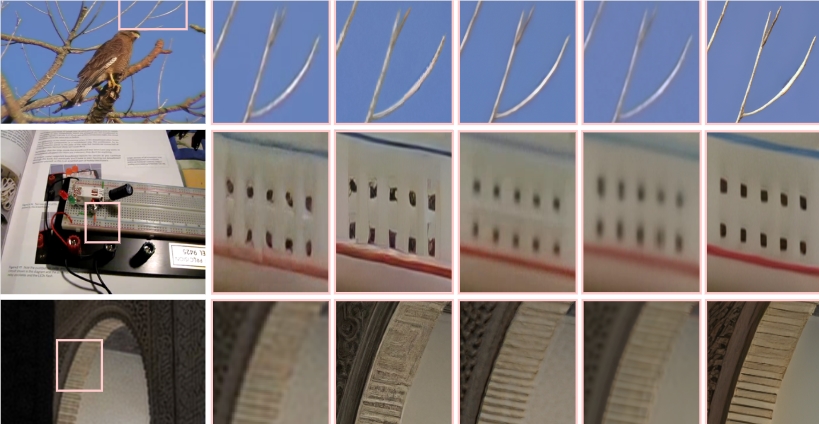

DLoRAL的开源发布为学术界和产业界带来了福音。其代码、训练数据以及预训练模型已于2025年6月24日在GitHub上公开,项目页面还提供了详细的2分钟讲解视频和丰富的视觉效果展示。DLoRAL不仅在视觉质量上超越了现有的RealVSR方法,还在PSNR和LPIPS等指标上展现了优异性能。然而,由于继承了Stable Diffusion的8倍下采样变分自编码器(VAE),DLoRAL在恢复极细小文本等细节时仍存在一定局限性,未来改进空间值得期待。

视频超分辨率的未来风向

DLoRAL的出现标志着视频超分辨率技术迈向了一个新阶段。其单步生成能力和开源特性为开发者提供了低成本、高效率的解决方案,极大地降低了视频高清化的技术门槛。AIbase认为,随着更多研究者和企业基于DLoRAL进行二次开发,视频处理领域或将迎来更多创新应用,例如实时视频增强、影视后期制作优化等。